Data är AI:s livsnerv, men det är inte en oändlig resurs. Kan mänskligheten få slut på data? Vad händer om vi gör det?

Komplexa AI-modeller kräver stora mängder träningsdata. För att träna en stor språkmodell (LLM) som ChatGPT krävs till exempel cirka 10 biljoner ord.

Vissa experter anser att tillgången på data av hög kvalitet minskar. Till exempel visade en studie från 2022 från forskare vid flera universitet uttalade, "Vår analys tyder på att lagret av högkvalitativa språkdata snart kommer att vara uttömt, sannolikt före 2026 ... Vårt arbete tyder på att den nuvarande trenden med ständigt växande ML-modeller som förlitar sig på enorma datamängder kan sakta ner om dataeffektiviteten inte förbättras drastiskt eller nya datakällor blir tillgängliga."

Att generera syntetisk data är en lösning, men den lyckas i allmänhet inte fånga djupet, nyanserna och variansen i verklig data.

För att ytterligare komplicera situationen finns det farhågor om vad som händer när AI börjar konsumera sin egen produktion, vilket forskare vid École Polytechnique Fédérale de Lausanne (EPFL) i Schweiz anser är händer redan.

Deras forskning tyder på att AI-företag som köper mänskligt producerad data via plattformar som Amazon Mechanical Turk kan få AI-genererad data istället.

Vad händer när AI börjar äta sin egen produktion? Går det att undvika?

Att bygga upp dataset är dyrt och tidskrävande - och insatserna är höga

Data finns överallt, men att operationalisera dem för AI är en komplex process. Kvaliteten på data och etiketter påverkar modellens prestanda - det är ett fall av "skräp in, skräp ut".

För att kortfattat beskriva processen för att bygga upp dataset tar dataantecknare (eller etiketterare) bearbetade data (t.ex. en beskuren bild) och etiketterar funktioner (t.ex. en bil, en person, en fågel).

Detta ger algoritmerna ett "mål" att lära sig från. Algoritmerna extraherar och analyserar funktioner från märkta data för att förutsäga dessa funktioner i nya, osedda data.

Detta krävs för övervakad maskininlärning, som är en av de viktigaste grenarna inom maskininlärning tillsammans med oövervakad maskininlärning och förstärkningsinlärning. Genom att vissa uppskattningarFörberedelse- och märkningsprocessen för data upptar 80% av ett maskininlärningsmodellprojekts varaktighet, men att skära för många hörn riskerar att äventyra en modells prestanda.

Förutom de praktiska utmaningarna med att skapa högkvalitativa dataset förändras datas natur hela tiden. Det som för 10 år sedan definierades som en "dataset som innehåller ett typiskt urval av fordon på vägarna" är inte detsamma idag. Nu hittar du till exempel ett mycket större antal eScooters och eBikes på vägarna.

Dessa kallas "edge cases", vilket är sällsynta objekt eller fenomen som inte förekommer i dataset.

Modellerna återspeglar kvaliteten på deras dataset

Om du tränar ett modernt AI-system på ett gammalt dataset riskerar modellen att få låg prestanda när den utsätts för nya, osedda data.

Mellan 2015 och 2020 upptäckte forskare stora strukturella fel i AI-algoritmer, som delvis berodde på att modellerna tränades på gamla och partiska data.

Till exempel kan Märkta ansikten i det vilda hemmet (LFW), ett dataset med kändisansikten som ofta används vid ansiktsigenkänning, består av 77,5% män och 83,5% personer med vit hudfärg individer. En AI har inget hopp om att fungera korrekt om data inte representerar alla som den avser att tjäna. Felprocenten för ansiktsigenkänning bland de bästa algoritmerna visade sig vara så låg som 0,8% för vita män och så hög som 34,7% för mörkhyade kvinnor.

Denna forskning kulminerade i den banbrytande Studie av genusnyanser och en dokumentärfilm som heter Kodad partiskhetsom undersökte hur AI sannolikt lär sig från bristfälliga och icke-representativa data.

Konsekvenserna av detta är långt ifrån oskyldiga - det har lett till felaktiga domslut, falska frihetsberövanden och till att kvinnor och andra grupper har nekats jobb och krediter.

AI behöver mer data av hög kvalitet, som måste vara rättvisande och representativ - det är en svårfångad kombination.

Är syntetisk data svaret?

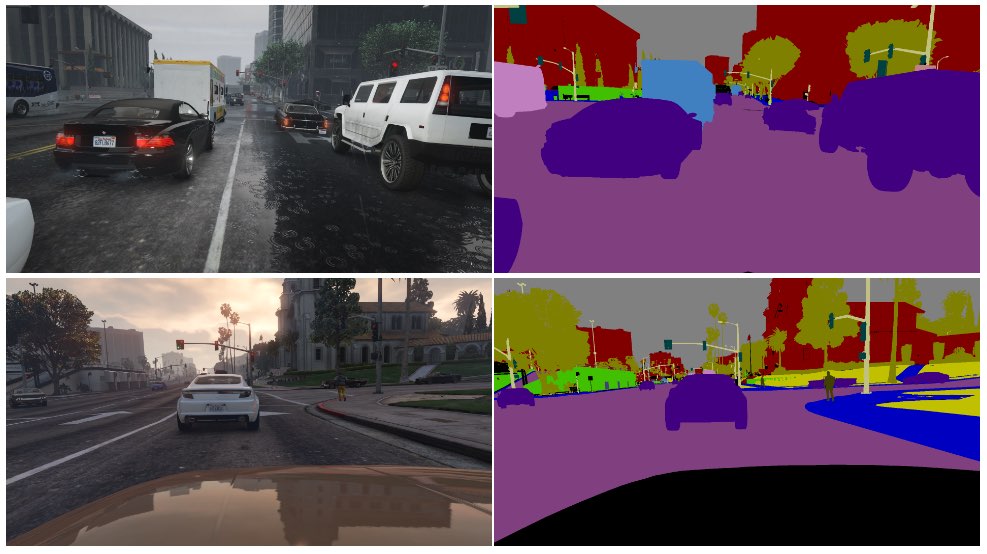

Syntetisk data används ofta inom computer vision (CV), där AI identifierar objekt och funktioner från bilder och video.

Istället för att samla in bilddata från den verkliga världen - som att fotografera eller videofilma en gata, vilket är tekniskt utmanande och medför integritetsfrågor - genererar man helt enkelt data i en virtuell miljö.

Även om detta ger AI:erna mer data finns det flera nackdelar:

- Att modellera verkliga scenarier i en virtuell miljö är inte helt enkelt.

- Att generera stora mängder syntetiska data är fortfarande kostsamt och tidskrävande.

- Kantfall och avvikande värden är fortfarande ett problem.

- Det kan inte perfekt replikera den verkliga varan.

- Å andra sidan kan vissa aspekter vara för perfekta, och det är svårt att avgöra vad som saknas.

I slutändan är syntetisk data utmärkt för lättvirtualiserade miljöer, som ett fabriksgolv, men det räcker inte alltid till för snabbrörliga miljöer i verkligheten, som en gata i en stad.

Hur är det med att generera syntetisk textdata?

Text är enklare än bild- eller videodata, så kan modeller som ChatGPT användas för att generera nästan oändliga syntetiska träningsdata?

Ja, men det är riskabelt och effekterna är inte lätta att förutse. Även om syntetisk textdata kan hjälpa till att ställa in, testa och optimera modeller är den inte idealisk för att lära modeller ny kunskap och kan förstärka fördomar och andra problem.

Här är en analogi av varför det är problematiskt att träna AI med AI-genererad data:

- Tänk dig en skola som använder alla världens bästa läroböcker för att utbilda sina elever i allt som finns att veta från sina resurser under en dag.

- Därefter börjar skolan producera sitt eget arbete baserat på den kunskapen - på samma sätt som en chatbot. Eleverna har lärt sig av all tillgänglig data fram till det datum då utbildningen börjar, men de kan inte effektivt föra in ny data i kunskapssystemet efteråt.

- Kunskap skapas dagligen - även om den allra största delen av människans kunskap skapades före en viss dag, utvecklas och omvandlas kunskap över tid. Avgörande är att människor inte bara skapar ny kunskap hela tiden - vi ändrar också vårt perspektiv på befintlig kunskap.

- Anta nu att skolan, som har slut på data, börjar undervisa sina elever med hjälp av sin egen produktion. Eleverna börjar "äta" sitt innehåll för att producera nytt innehåll.

- I det skedet kan studenternas resultat inte anpassas till den verkliga världen och dess användbarhet minskar. Systemet återskapar sitt eget arbete. Arbetet kan visserligen anpassas och utvecklas, men det sker isolerat från allt utanför återkopplingsslingan.

AI konfronterar ständigt människor med gåtor att lösa, och den här har en hel del kommentatorer på Reddit och Y Combinator forum förvirrad.

Det är häpnadsväckande saker, och det finns ingen riktig konsensus om konsekvenserna.

Mänskliga dataetiketterare använder ofta AI för att producera data

Det finns ytterligare ett oförutsett lager till problemet med att ta fram utbildningsdata av hög kvalitet.

Plattformar för gräsrotsarbete som Amazon Mechanical Turk (MTurk) används regelbundet av AI-företag som vill ta fram äkta "mänskliga" dataset. Tet finns farhågor om att dataantecknare på dessa plattformar använder AI för att utföra sina uppgifter.

Forskare vid École Polytechnique Fédérale de Lausanne (EPFL) i Schweiz analyserade data som skapats via MTurk för att undersöka om arbetare använde AI för att generera sina inlägg.

Studiensom publicerades den 13 juni, anlitade 44 MTurk-deltagare för att sammanfatta abstrakten från 16 medicinska forskningsartiklar. Det visade sig att 33% till 46% av användarna på plattformen genererade sina bidrag med AI, trots att de ombads att svara med naturligt språk.

"Vi utvecklade en mycket specifik metod som fungerade mycket bra för att upptäcka syntetisk text i vårt scenario", säger Manoel Ribeiro, medförfattare till studien och doktorand vid EPFL, berättade för The Register den här veckan.

Även om studiens dataset och urvalsstorlek är ganska liten, är det långt ifrån otänkbart att tro att AI tränas omedvetet på AI-genererat innehåll.

Studien handlar inte om att skylla på MTurk-anställda - forskarna konstaterar att låga löner och repetitivt arbete bidrar till problemet. AI-företag vill ha mänskligt skapade data av högsta kvalitet samtidigt som kostnaderna hålls låga. En kommentator sa på Reddit: "Jag är för närvarande en av dessa arbetare, som har till uppgift att träna Bard. Jag är säker som fan att använda ChatGPT för detta. 20$/timme är inte tillräckligt för den hemska behandling vi får, så jag ska pressa varje cent ur det här ******* jobbet."

Kaninhålet blir ännu djupare, eftersom AI ofta tränas på data som skrapats från internet. I takt med att mer AI-skrivet innehåll publiceras på nätet kommer AI oundvikligen att lära sig av sina egna resultat.

I takt med att människor börjar bli beroende av AI för att få information blir kvaliteten på deras resultat allt viktigare. Vi måste hitta innovativa metoder för att uppdatera AI med färska, autentiska data.

Som Ribeiro uttrycker det: "Mänskliga data är guldstandarden, eftersom det är människor vi bryr oss om, inte stora språkmodeller."

Arbetet med att analysera den potentiella effekten av att AI konsumerar sina egna resultat pågår, men autentiska mänskliga data är fortfarande avgörande för ett brett spektrum av maskininlärningsuppgifter.

Att generera stora mängder data för hungriga AI:er och samtidigt navigera bland riskerna är ett pågående arbete.