Den exponentiella tillväxten av AI-system går snabbare än forskning och reglering, vilket gör att regeringar hamnar i en besvärlig situation när de ska balansera fördelar med risker.

Det tar åratal för lagar att utvecklas och bli juridiskt bindande. AI utvecklas varje vecka.

Det är den dikotomi som AI-ledare och politiker står inför, med den första delen av meningsfull AI-reglering i väst, EU AI Act, som kommer 2026. Redan för ett år sedan var ChatGPT bara en viskning.

Topptjänstemän från USA och EU träffades för US-EU Trade and Tech Council (TTC) den 31 maj i Luleå. Margrethe Vestager, EU:s digitala kommissionär, som veckan innan träffade Googles VD Sundar Pichai för att diskutera en potentiell "AI-pakt", sa: "Demokratin måste visa att vi är lika snabba som tekniken."

Tjänstemännen erkänner det stora gapet mellan teknikens och lagstiftningens tempo. Med hänvisning till generativ AI som ChatGPT sa Gina Raimondo, USA:s handelsminister: "Det kommer i en takt som ingen annan teknik."

Så vad uppnåddes vid TTC-mötet?

Vattenmärkning, externa revisioner, återkopplingsloopar - bara några av de idéer som diskuterades med @AnthropicAI och @sama @OpenAI för #AI #C Uppförandekod lanserades idag på #TTC i #Luleå @SecRaimondo Vi ser fram emot att diskutera med internationella partners. pic.twitter.com/wV08KDNs3h

- Margrethe Vestager (@vestager) 31 maj 2023

Deltagarna diskuterade framför allt icke-bindande eller frivilliga ramverk kring risk och transparens, som kommer att presenteras för G7 i höst.

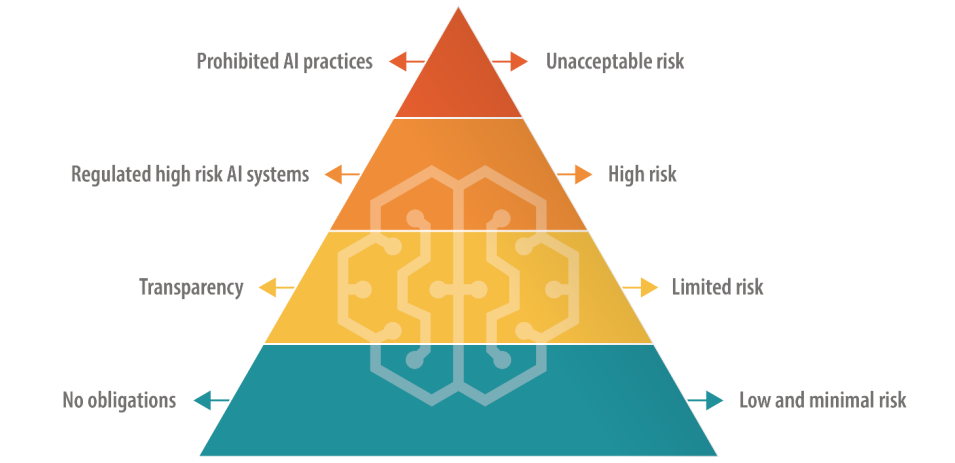

EU, som har en direkt strategi för digital lagstiftning, väljer en differentierad strategi för AI-reglering, där AI sorteras in i kategorier baserat på risk.

Detta inkluderar en förbjuden "oacceptabel risk"-nivå och en "hög risk"-nivå, som teknikchefer som OpenAI:s VD Sam Altman fruktar kommer att äventyra deras produkters funktionalitet.

USA föreslår inte några sådana definitiva regler, gynnar frivilliga regler.

Det kommer att krävas många fler möten mellan EU, USA och de stora teknikföretagen för att åsikterna ska leda till meningsfulla praktiska åtgärder.

Kommer frivilliga AI-regler att fungera?

Det finns många exempel på frivilliga regler i andra sektorer och branscher, t.ex. frivilliga ramverk för datasäkerhet och ESG-information, men inget ligger så nära framkanten som ett frivilligt ramverk för styrning av AI.

Vi har trots allt att göra med ett hot på utrotningsnivå här, enligt toppteknologiledare och akademiker som undertecknade Center for AI Safety's uttalande om AI-risk denna vecka.

Stora företag som OpenAI och Google har redan centrala avdelningar som fokuserar på styrning och frågor om intern efterlevnad, så att anpassa sina produkter och tjänster till frivilliga ramverk kan vara en fråga om att skriva om interna policydokument.

Frivilliga regler är bättre än ingenting, men med många förslag på bordet kommer politiker och AI-ledare förr eller senare att behöva välja något att köra med.