I slutet av maj använde New York-advokaten Steven A Schwartz ChatGPT för att undersöka rättsfall för en klients räkning.

Schwartz och en kollega från samma advokatbyrå, Peter LoDuca, ställdes inför en domare på torsdagen för att förklara sitt agerande.

Vid förhöret erkände båda advokaterna att de hänvisat till falska rättsfall som genererats av ChatGPT.

Schwartz använde ChatGPT för att hitta juridiska prejudikat som stöd för en klients ärende mot det colombianska flygbolaget Avianca, som AI returnerade flera falska fall och ett verkligt fall med grovt förändrade detaljer.

Schwartz citerade dessa i kärandens inlaga, men när den amerikanska distriktsdomaren Kevin Castel fick den noterade han snabbt falska fall och sade: "Sex av de inlämnade fallen verkar vara falska rättsliga beslut med falska citat och falska interna hänvisningar."

"Jag förstod inte att ChatGPT kunde fabricera fall", erkände Schwartz för Castel och medgav att han hade "arbetat under en missuppfattning ... att den här webbplatsen fick dessa fall från någon källa som jag inte hade tillgång till."

Domare Castel konfronterade dem med ett särskilt påhittat rättsfall som borde ha slagit Schwartz som falskt. Fallet beskrevs först som ett fall av vållande till annans död men förvandlades senare till ett fall om en man som missat ett flyg och tvingats betala extra kostnader.

Med andra ord, även för en lekman var det förmodligen uppenbart att det här fallet var falskt, så Schwartz läste sannolikt inte AI:s utdata ordentligt. "Kan vi vara överens om att det är juridisk rappakalja?" sa Castel om fallet.

Schwartz bad så mycket om ursäkt: "Jag vill uppriktigt be om ursäkt", och sa att han kände sig "generad, förödmjukad och extremt ångerfull".

LoDuca medgav att han inte tillräckligt noggrant hade granskat det material som Schwartz sammanställt. Han sa: "Det gick aldrig upp för mig att det här var ett falskt fall" och att resultatet "smärtar mig oerhört".

När det gäller huruvida duon kommer att straffas hävdade advokat Ronald Minkoff att parets handlingar "berodde på vårdslöshet, inte ond tro" och därför inte borde straffas.

Minkoff hävdade: "Mr Schwartz, som knappt bedriver federal forskning, valde att använda den här nya tekniken. Han trodde att han hade att göra med en vanlig sökmotor."

Den slutliga domen om sanktioner har ännu inte avkunnats.

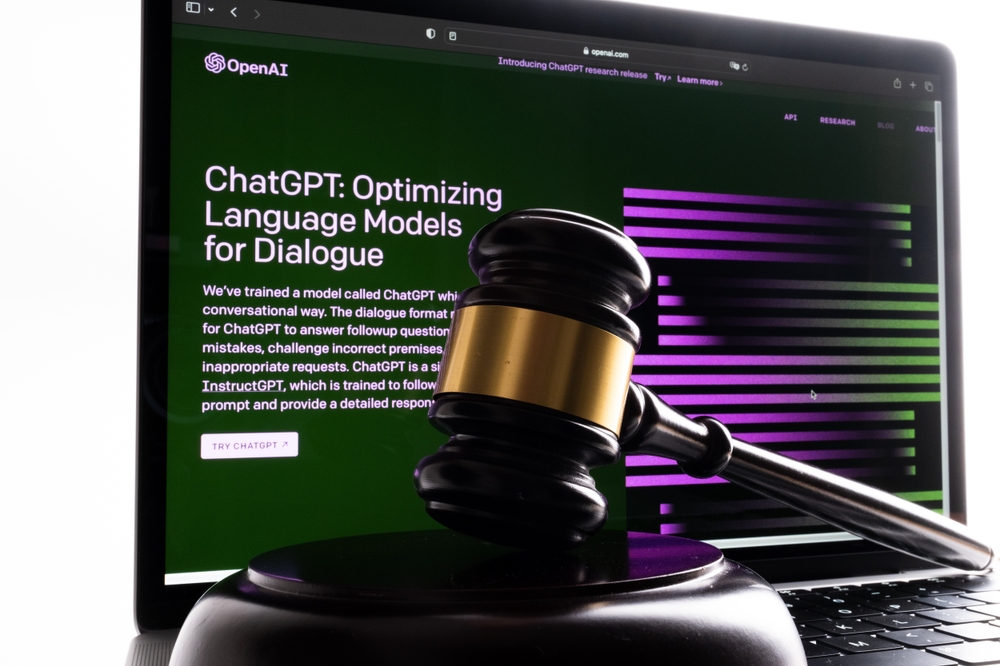

AI-"hallucinationer" ger upphov till både etiska och juridiska frågor

En sekvens av rättsfall slår mot OpenAI, inklusive tre fall av potentiellt förtal som uppstod när ChatGPT:s utdata innehöll falsk och ärekränkande information.

Utfallet här är annorlunda. Detta är ett exempel på tjänstefel till följd av råd som hämtats från ChatGPT:s utdata.

Daniel Shin, adjungerad professor och biträdande forskningschef vid Center for Legal and Court Technology vid William & Mary Law School, sa: "Detta var den första dokumenterade förekomsten av potentiellt yrkesmässigt fel av en advokat som använder generativ AI."

Det var bara en tidsfråga innan någon gjorde det här misstaget. Schwartz råkade vara den första (som vi känner till) i vad som har visat sig vara ett prejudikat som han förmodligen inte förväntade sig att skapa.