New York-advokaten Steven A Schwartz använde ChatGPT för att undersöka flera "fall" som visade sig vara falska.

Schwartz fall gällde en man som stämde det colombianska flygbolaget Avianca. Målsäganden arbetade med ett juridiskt team, Levidow, Levidow & Oberman, som utarbetade en juridisk sammanfattning med hänvisning till helt falska rättsfall.

Schwartz bad ChatGPT om en försäkran om att fallen var verkliga, men han försökte bara dubbelkolla ett av fallen i detalj, och ChatGPT försäkrade honom om att det fanns i databaserna Westlaw och LexisNexis. På grundval av detta antog Schwartz att även de andra fallen var verkliga.

Det visade sig senare att endast ett fall var verkligt, Zicherman mot Korean Air Lines Co, 516 U.S. 217 (1996), och ChatGPT angav fel datum och flera andra detaljer.

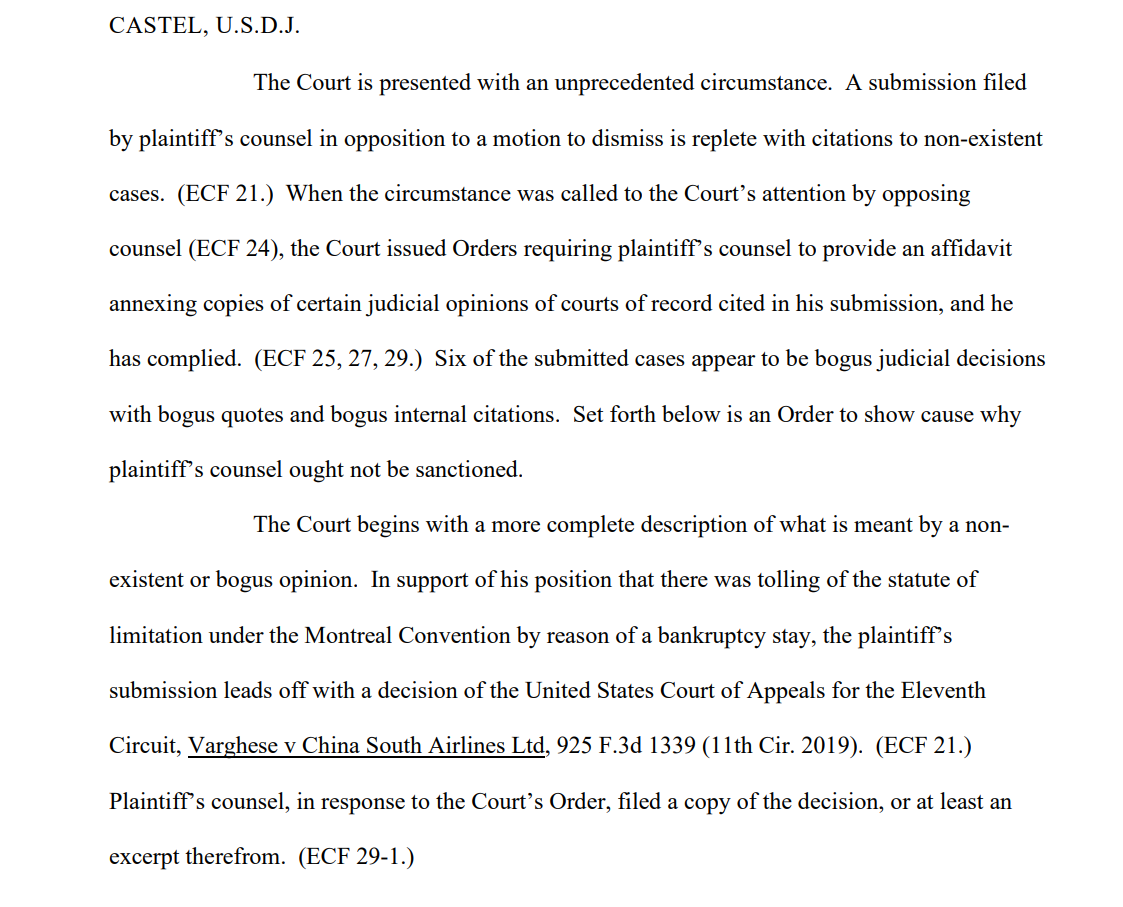

Efter att kärandens team hade lämnat in skrivelsen uttalade en av mottagarna, den amerikanska distriktsdomaren Kevin Castel, "Sex av de inlämnade fallen verkar vara falska rättsliga beslut med falska citat och falska interna citat."

En av de domstolshandlingar säger"Domstolen presenteras med en aldrig tidigare skådad omständighet. En inlaga som lämnats in av kärandens ombud i motsats till ett yrkande om avvisning är fylld med hänvisningar till obefintliga fall."

Schwartz, som har 30 års erfarenhet som advokat, hävdade att detta var ett oskyldigt misstag och berättade för domstolen att han "ångrar djupt" att han använde ChatGPT för forskning och var "omedveten om att dess innehåll kunde vara falskt". Han medgav också att han använt ChatGPT i andra rättsfall.

Schwartz, som agerade på uppdrag av Peter LeDocu, en kollega på samma advokatbyrå, ska inställa sig inför domstolen den 8 juni för att förklara varför han och hans advokatbyrå inte ska straffas.

När ChatGPT kontrollerar ChatGPT

OpenAI är mycket tydlig med att ChatGPT är sårbar för att förvränga sanningen, men AI:n kan framstå som självsäker när den ger kontextuellt relevanta "exempel" som inte är korrekta i sak - även kallat "hallucinationer".

Detta är ett problem även inom den akademiska världen, där ChatGPT ofta genererar falska referenser och ibland går så långt som att skapa realistiska studier och experiment som aldrig har ägt rum.

Många universitet har gjort uttalanden som belyser detta. Till exempel, Duke University säger, "Vad du kanske inte vet om ChatGPT är att det har betydande begränsningar som en pålitlig forskningsassistent. En sådan begränsning är att den har varit känd för att fabricera eller "hallucinera" (i maskininlärningstermer) citat."

Att analysera referenser för inkonsekvenser har blivit ett pålitligt sätt för handledare att fånga studenter som använder ChatGPT för att skriva uppsatser.

Det var precis vad som hände med Schwartz - han åkte fast. Han var inte den första och han kommer inte att bli den sista. Han verkade genuint okunnig, men okunnighet utgör inte nödvändigtvis ett försvar i domstol.

Att generera falska juridiska citat är ett alarmerande exempel på ChatGPT:s felbarhet och fungerar som en kraftfull påminnelse om att kontrollera, dubbelkontrollera och trippelkontrollera "fakta" som generativa AI:er presenterar.