По мере того как искусственный интеллект продолжает внедряться в процессы подбора персонала, становится ясно, что обещание эффективности этой технологии сопряжено с определенными рисками.

Согласно 2022 данныеОколо 55% компаний уже используют инструменты искусственного интеллекта для подбора персонала.

Хотя искусственный интеллект ускорил традиционные методы найма, избавив от кип резюме и автобиографий, он также поднял важнейшие вопросы о справедливости, предвзятости и самой природе принятия решений человеком.

В конце концов, ИИ обучаются на человеческих данных, поэтому они могут унаследовать все предубеждения и предрассудки, которые они обещают искоренить.

Можем ли мы что-то изменить? Чему мы научились благодаря ИИ при найме персонала?

Правозащитные группы обвинили Meta в дискриминационных рекламных практиках

Данные показывают, что некоторые 79% соискателей используют социальные сети для поиска работы, и, как показывают данные, именно здесь начинается дискриминация.

Мета в настоящее время против которого выдвинуто множество обвинений Европейские правозащитные организации утверждают, что алгоритм таргетинга объявлений о работе, разработанный Facebook, является предвзятым.

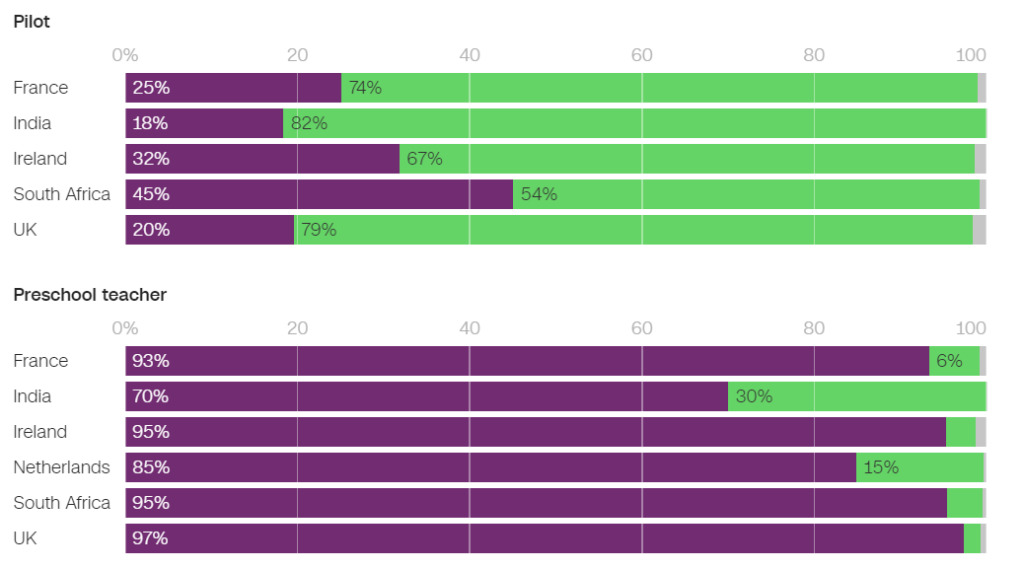

В июне неправительственная организация Глобальный свидетель исследовали несколько автотаргетированных объявлений о работе в Facebook и обнаружили, что многие из них увековечивают гендерные предубеждения.

Например, мужчинам значительно чаще показывали рекламу, связанную с инженерным делом, а женщинам - с преподаванием.

Среди объявлений, показанных во Франции, 93% пользователей, показавших объявление о работе воспитателя дошкольного учреждения, и 86% пользователей, показавших объявление о работе психолога, были женщинами. И наоборот, только 25% женщин получили объявление о работе пилота и всего 6% - о работе механика.

В Нидерландах 85% пользователей, которым было показано объявление о работе учителя, и 96% пользователей, которым было показано объявление о работе секретаря, были женщинами. Аналогичные результаты наблюдались и во многих других странах, включая Великобританию, Индию и Южную Африку.

В интервью CNNНаоми Херст из Global Witness заявила: "Мы обеспокоены тем, что Facebook усугубляет предвзятость, которая живет в обществе, и фактически ограничивает возможности для прогресса и равенства на рабочем месте".

Совместно с Бюро Клары Вихманн и Фондом женщин Global Witness подала жалобы на Meta в органы по правам человека и защите данных во Франции и Нидерландах.

Группы требуют провести расследование, чтобы выяснить, не нарушает ли практика Meta права человека или законы о защите данных. Если обвинения подтвердятся, Meta может столкнуться со штрафами и санкциями.

В ответ на это представитель Meta заявил: "Система учитывает различные виды информации, чтобы попытаться предложить людям рекламу, которая их больше всего заинтересует".

Это не первый раз, когда Meta отбивается от подобной критики - компания столкнулась с многочисленные судебные иски в 2019 году и обязалась изменить свою систему подачи объявлений, чтобы избежать предвзятости, основанной на защищенных характеристиках, таких как пол и раса.

Пэт де Бран, представительница Amnesty International, резко отозвалась о выводах Global Witness. "Исследования постоянно показывают, как алгоритмы Facebook обеспечивают глубоко неравные результаты и часто усиливают маргинализацию и дискриминацию", - сказала она CNN.

Amazon отменила секретный инструмент для подбора персонала с помощью искусственного интеллекта, который показал предвзятое отношение к женщинам

С 2014 по 2017 год компания Amazon разрабатывала инструмент искусственного интеллекта для подбора персонала, после чего поняла, что он был необъективен при отборе разработчиков программного обеспечения и других технических должностей. К 2018 году Amazon полностью отказалась от этого инструмента.

Система искусственного интеллекта наказывала резюме, содержащие слова "женский" и "женский", и понижала квалификацию выпускниц.

Система дала сбой даже после того, как Amazon попыталась отредактировать алгоритмы, сделав их гендерно-нейтральными.

Позже выяснилось, что Amazon обучала этот инструмент на резюме, присланных в компанию за 10 лет, большинство из которых были от мужчин.

Как и многие другие системы искусственного интеллекта, инструмент Amazon подвергался влиянию данных, на которых он обучался, что привело к непреднамеренной предвзятости. Эта предвзятость способствовала тому, что кандидаты-мужчины отдавали предпочтение резюме, в которых использовался язык, чаще всего встречающийся в резюме инженеров-мужчин.

Кроме того, из-за проблем с базовыми данными система часто рекомендовала неквалифицированных кандидатов на различные должности.

Сайт Всемирный экономический форум говорит о системе подбора персонала Amazon: "Например, как в случае с Amazon, сильный гендерный дисбаланс может коррелировать с типом проводимого исследования. Подобные погрешности в обучающих данных могут также возникать из-за плохого качества данных или очень маленьких, неразнообразных наборов данных, что может быть характерно для компаний, которые не работают в глобальном масштабе и ищут нишевых кандидатов".

Amazon удалось перепрофилировать "урезанную версию" рекрутинговой системы для выполнения элементарных задач, таких как удаление дубликатов профилей кандидатов из баз данных.

Они создали новую команду, чтобы предпринять еще одну попытку автоматической проверки при приеме на работу, на этот раз сосредоточившись на поощрении разнообразия.

Google борется с собственными проблемами дискриминации и предвзятости

В декабре 2020 года доктор Тимнит Гебру, ведущий специалист по этике ИИ в компании Google, объявил, что компания уволила ее.

Увольнение произошло после того, как доктор Гебру выразил обеспокоенность по поводу подхода Google к найму меньшинств и предвзятости, присущей системам искусственного интеллекта.

Перед тем как покинуть компанию, доктор Гебру собирался опубликовать работу о предвзятости в моделях искусственного интеллекта Google.

После представления этой работы на научной конференции доктор Гебру рассказала, что менеджер Google попросил ее отказаться от статьи или удалить имена ее и других исследователей Google. Отказавшись подчиниться, компания Google приняла условное предложение об отставке, фактически немедленно лишив доктора Гебру должности.

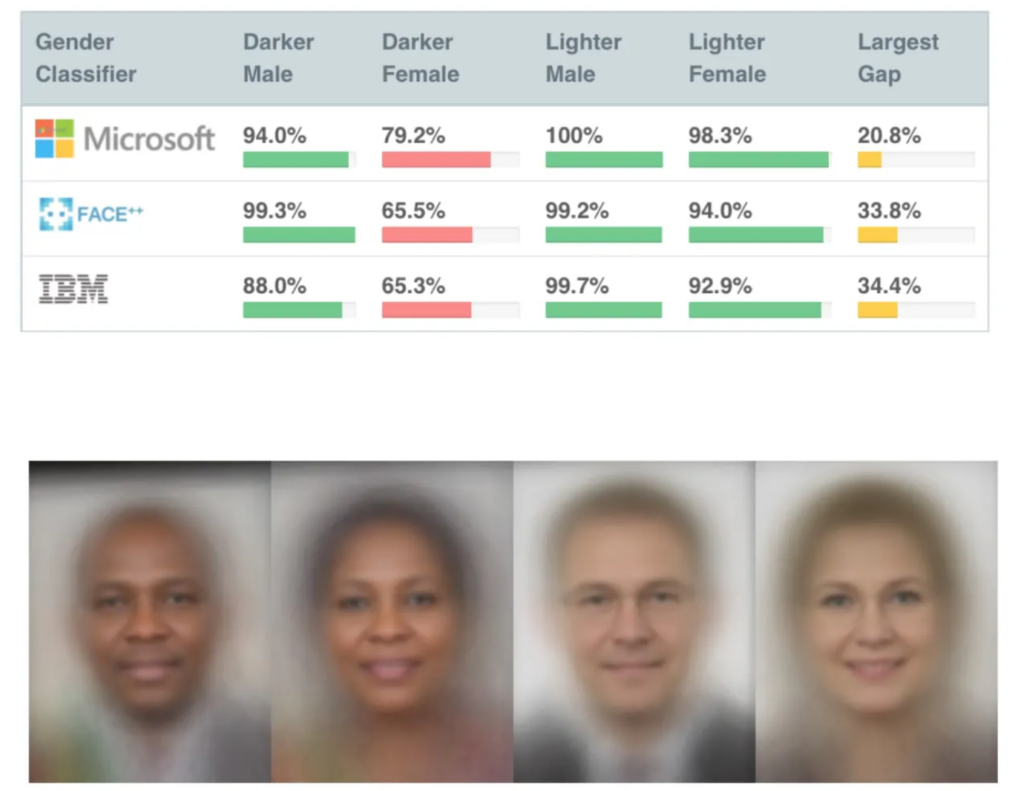

Это произошло вскоре после того, как было опубликовано несколько весьма влиятельных исследований о предвзятости ИИ, в том числе Исследование гендерных оттенков, проведенное Массачусетским технологическим институтом, которая стала одной из самых цитируемых работ по ИИ за все время.

Исследование Gender Shades выявило предвзятость в работе искусственного интеллекта, распознающего лица, который ошибочно определял черные лица примерно в 30% - 35% случаев по сравнению с 5% для белых лиц.

Неправильное распознавание лиц привело к неправомерному аресту и тюремному заключению несколько человек в США.

Увольнение Гебру вызвало бурю в прессе вокруг дискриминационной практики в Кремниевой долине.

Мутале Нконде из Стэнфордской лаборатории цифрового гражданского общества говорит: "Ее увольнение говорит лишь о том, что ученые, активисты и исследователи, которые хотят работать в этой области и являются чернокожими женщинами, не приветствуются в Кремниевой долине".

Увольнение доктора Гебру послужило толчком к проведению еще одного исследования, Разоблачение закодированной предвзятостиВ ходе исследования выяснилось, что чернокожие люди значительно чаще других подвергаются недооценке со стороны искусственного интеллекта при подборе персонала.

"В этом отчете содержится множество свидетельств того, что чернокожие студенты и профессионалы обеспокоены тем, что сталкиваются с античерной предвзятостью в процессе найма на работу. Чуть более половины всех респондентов сообщили, что наблюдали предвзятость в процессе найма или рекрутинга на сайтах, посвященных найму или рекрутингу. Вероятность того, что чернокожие профессионалы сталкивались с подобной предвзятостью, несколько выше: пятьдесят пять процентов респондентов указали, что сталкивались с предвзятостью в процессе найма". Разоблачение закодированной предвзятости, Penn Law Policy Lab.

В статье говорится: "Общественная дискуссия, вызванная доктором Гебру и ее коллегами по поводу алгоритмической предвзятости, позволила нашей лаборатории принять участие в этом национальном диалоге и расширить более тонкое понимание алгоритмической предвзятости в платформах по найму персонала".

Раскрытие этой проблемы стало катализатором перемен, но ИИ предстоит пройти долгий путь, чтобы примириться со своей ролью в принятии важных человеческих решений.

Роль искусственного интеллекта в подборе персонала: некоторые положительные моменты

Несмотря на многочисленные споры, компаниям трудно противостоять огромному потенциалу искусственного интеллекта в ускорении найма персонала.

Роль ИИ в подборе персонала, безусловно, имеет определенный логический смысл - возможно, ИИ легче избавить от предвзятости, чем человека. В конце концов, ИИ - это *просто* математика и код, которые, несомненно, более податливы, чем глубоко укоренившиеся бессознательные предубеждения?

И хотя в начале-середине 2010-х годов обучающие данные были сильно предвзяты, в первую очередь из-за отсутствия разнообразных наборов данных, с тех пор ситуация, вероятно, улучшилась.

Одним из самых известных инструментов для подбора персонала с помощью искусственного интеллекта является Sapia, прозванный "умным интервьюером". По словам основателя компании Sapia Барб Хайман, искусственный интеллект позволяет проводить собеседование "вслепую", не опираясь на резюме, социальные сети или демографические данные, а исключительно на ответы соискателя, тем самым устраняя предвзятость, характерную для найма с помощью человека.

Эти системы могут обеспечить справедливые шансы для всех, проводя собеседования со всеми кандидатами. Хайман предлагает"Вероятность привлечения и удержания женщин в процессе найма в два раза выше, если вы используете искусственный интеллект".

Но даже сам процесс интервьюирования человека с искусственным интеллектом вызывает вопросы.

Модели обработки естественного языка (NLP), как правило, обучаются в основном на текстах на родном английском языке, что означает, что они плохо справляется с неродным английским языком.

Такие системы могут непреднамеренно наказывать тех, кто не является носителем английского языка, или тех, у кого другие культурные особенности. Кроме того, критики утверждают, что в чате или видеоинтервью с использованием искусственного интеллекта не всегда адекватно учитывается инвалидность, что приводит к дальнейшей потенциальной дискриминации.

Ситуация усугубляется тем, что соискатели часто не знают, оценивает ли их ИИ, что делает невозможным внесение необходимых корректировок в процесс собеседования.

Наборы данных являются основополагающими

Наборы данных играют здесь основополагающую роль. Обучите ИИ на данных десятилетней давности, и он усвоит значения десятилетней давности.

С начала тысячелетия рынок труда стал значительно разнообразнее.

Например, в некоторых странах женщины превосходят мужчин в ряде ключевых медицинских дисциплин, таких как психология, генетика, педиатрия и иммунология.

В Великобритании, отчет за 2023 год Согласно исследованию, 27% женщин, имеющих работу, заняты в "профессиональных профессиях" (таких как врачи, инженеры, медсестры, бухгалтеры, учителя и юристы) по сравнению с 26% мужчин, и эта тенденция неуклонно растет в течение 5-10 лет.

Такие переходы ускорились в последние 2-5 лет - многие наборы данных устарели и просто не отражают последние данные. В отношении расы и инвалидности существуют те же проблемы, что и в отношении пола.

Данные должны отражать все большее разнообразие рабочих мест, чтобы справедливо обслуживать всех.

Хотя еще предстоит проделать огромную работу по обеспечению разнообразия на рабочих местах, ИИ должен унаследовать ценности настоящего, а не прошлого. Это должно быть обязательным минимумом для создания честного и прозрачного ИИ для подбора персонала.

Разработчики искусственного интеллекта могут столкнуться с жестким регулированием: США, Великобритания, Китай, страны-члены ЕС и многие другие страны должны ужесточить контроль над искусственным интеллектом в ближайшие годы.

Исследования продолжаются, но по-прежнему маловероятно, что большинство ИИ, занимающихся подбором персонала, применяют справедливые и беспристрастные принципы, которых мы ожидаем друг от друга.