Le aziende di intelligenza artificiale spingono per una regolamentazione. La loro motivazione è paranoia o altruismo? Oppure la regolamentazione garantisce obiettivi competitivi?

All'inizio di maggio Luke Sernau, un ingegnere software senior di Google, ha scritto una nota informale sull'IA open-source. Il documento è stato ampiamente diffuso nei sistemi interni di Google prima che una società di consulenza, Semi-Analysis, verificato e pubblicato.

Ecco alcuni estratti:

"In OpenAI ci siamo guardati molto alle spalle. Chi taglierà il prossimo traguardo? Quale sarà la prossima mossa?

Ma la scomoda verità è che non siamo in grado di vincere questa corsa agli armamenti e nemmeno OpenAI. Mentre noi ci accapigliamo, una terza fazione si sta tranquillamente mangiando il nostro pranzo. Sto parlando, ovviamente, dell'open source.

In parole povere, ci stanno superando. Le cose che consideriamo "grandi problemi aperti" sono già risolte e nelle mani della gente. Sebbene i nostri modelli abbiano ancora un leggero vantaggio in termini di qualità, il divario si sta riducendo in modo sorprendentemente rapido.

I modelli open-source sono più veloci, più personalizzabili, più privati e, a parità di peso, più capaci. Con i parametri $100 e 13B fanno cose che noi facciamo fatica a fare con $10M e 540B. E lo fanno in settimane, non in mesi.

All'inizio di marzo, la comunità open source ha messo le mani sul primo modello di fondazione veramente capace, con la divulgazione di LLaMA di Meta.

Non aveva istruzioni o sintonizzazioni di conversazione, né RLHF. Ciononostante, la comunità capì immediatamente l'importanza di ciò che aveva ricevuto. Seguì un'enorme ondata di innovazioni, con pochi giorni di intervallo tra i principali sviluppi...

Eccoci qui, appena un mese dopo, e ci sono varianti con la messa a punto delle istruzioni, la quantizzazione, i miglioramenti della qualità, le valutazioni umane, la multimodalità, l'RLHF, eccetera eccetera, molte delle quali si basano l'una sull'altra. L'aspetto più importante è che hanno risolto il problema della scalabilità in modo tale che chiunque può armeggiare.

Molte delle nuove idee provengono da persone comuni. La barriera d'ingresso per la formazione e la sperimentazione è scesa dalla produzione totale di un'importante organizzazione di ricerca a una persona, una serata e un robusto computer portatile".

La nota di Sernau è stata ripresa dai principali organi di informazione e ha scatenato un dibattito sul fatto che la spinta delle big tech verso la regolamentazione nasconda un motivo per costringere l'IA open-source a uscire dal gioco. Ben Schrekcinger di Politico scriveIl codice open-source è anche più difficile da bandire, in quanto possono nascere nuove istanze se le autorità di regolamentazione tentano di chiudere un sito web o uno strumento che lo utilizza. Insieme ad altre caratteristiche di decentralizzazione, questi progetti open-source hanno il potenziale per sconvolgere non solo il modello di business della Silicon Valley, ma anche i modelli di governance di Washington e Bruxelles".

La comunità open-source dell'intelligenza artificiale è già fiorente. Gli sviluppatori risolvono in pochi giorni sfide che a Google e OpenAI richiederebbero mesi o anni. Sernau sostiene che le comunità agili di sviluppatori open-source sono meglio attrezzate per costruire modelli iterativi rispetto alle grandi tecnologie, in quanto sono più diverse, efficienti e pragmatiche.

Se così fosse, il dominio delle big tech sull'intelligenza artificiale potrebbe essere effimero.

La perdita di Meta LaMA

Il modello LLaMA di Meta, un modello linguistico di grandi dimensioni (LLM) come ChatGPT, era trapelato su 4chan una settimana dopo l'invio delle richieste di accesso da parte dell'azienda. Il 3 marzo, un torrent scaricabile è apparso sul forum di messaggistica e si è diffuso a macchia d'olio.

Come indica Sernau, la comunità open-source ha proceduto a modificare LaMA, aggiungendo funzionalità impressionanti senza risorse informatiche aziendali.

Costruire potenti modelli di intelligenza artificiale è più economico che mai e le comunità open-source stanno spingendo per democratizzarne l'accesso. Mentre LLaMA è un modello ampiamente pre-addestrato, altri modelli open-source, come BLOOM, sono stati addestrati da volontari.

L'addestramento di BLOOM ha richiesto un supercomputer dotato di 384 GPU NVIDIA A100 da 80 GB, fortunatamente donato dal governo francese. L'azienda di AI open-source Together ha recentemente annunciato un finanziamento di $20m e i fornitori di cloud focalizzati sull'AI come CoreWeave offrono hardware a prezzi inferiori a quelli di mercato.

I progetti open-source hanno diversi mezzi per concentrare le risorse e superare le grandi tecnologie. Le grandi aziende tecnologiche vorrebbero farci credere che le loro IA sono il prodotto di decenni di lavoro e di miliardi di dollari di investimenti. - la comunità open-source probabilmente non è d'accordo.

Sul tema delle grandi tecnologie che si separano dai progetti di IA più piccoli, durante un evento in India, l'ex dirigente di Google Rajan Anandan ha chiesto a Sam Altman, CEO di OpenAI, se gli ingegneri indiani potessero costruire modelli di IA fondamentali con un investimento di $10m.

Altman ha risposto: "Non c'è speranza di competere con noi nella formazione di modelli di fondazione. Non dovreste provarci, e il vostro lavoro è comunque quello di provare. E io credo a entrambe le cose. Credo che non ci siano speranze".

Tuttavia, nella sua nota, Sernau afferma che l'open-source è già in competizione con le grandi tecnologie. Dice: "Mantenere un vantaggio competitivo nella tecnologia diventa ancora più difficile ora che la ricerca d'avanguardia nei LLM è accessibile. Gli istituti di ricerca di tutto il mondo si basano l'uno sul lavoro dell'altro, esplorando lo spazio delle soluzioni con un'ampiezza che supera di gran lunga le nostre capacità".

Gli sviluppatori open-source stanno costruendo alternative alle IA delle big tech e le stanno superando in termini di prestazioni e statistiche sugli utenti.

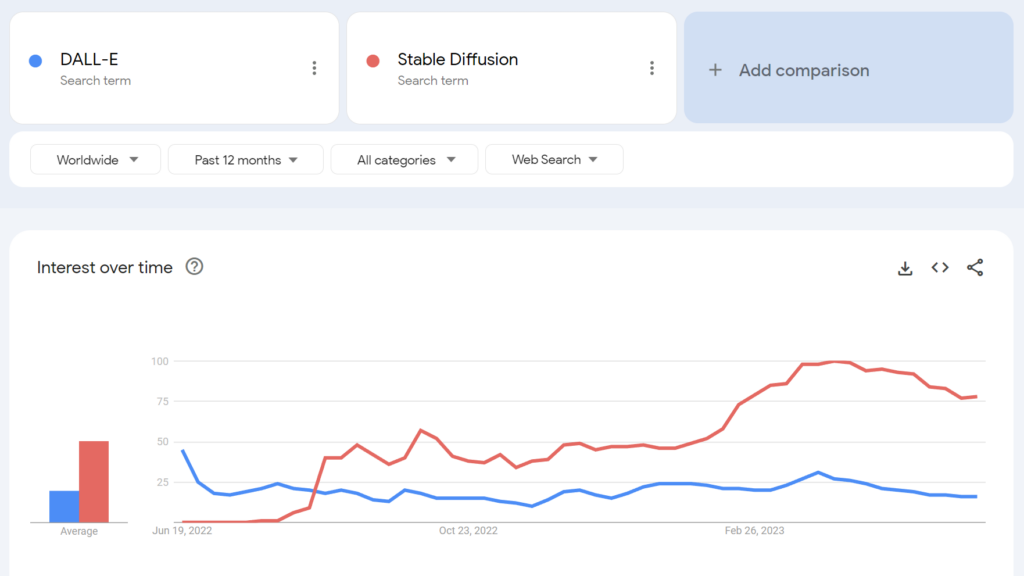

Ad esempio, l'open-source Stable Diffusion è diventato più popolare di DALL-E di OpenAI a pochi mesi dal suo lancio.

Fino a che punto è possibile distinguere i potenziali secondi fini in questo caso? La spinta normativa delle big tech ha qualche merito altruistico?

La comunità dell'intelligenza artificiale open-source

Oltre a LLaMA, esistono almeno tre esempi principali di progetti di IA open-source:

- Viso abbracciato & BLOOM - L'azienda di AI Hugging Face ha collaborato con oltre 1.000 scienziati volontari per sviluppare BLOOM, un LLM open-source. BLOOM mira a offrire una controparte più trasparente e accessibile ai modelli di IA proprietari.

- Insieme - Una startup di AI chiamata Together ha raccolto con successo $20 milioni di fondi di avviamento per sostenere il suo obiettivo di costruire alternative decentralizzate ai sistemi di AI chiusi. Ha presentato diverse iniziative di IA generativa open-source, tra cui GPT-JT, OpenChatKit e RedPajama.

- Stabilità AI - Nell'aprile del 2023, Stability AI, la società che sta dietro a Stable Diffusion, ha lanciato StableLM, una serie di alternative open-source a ChatGPT.

Vale la pena notare che mentre alcuni di questi sviluppatori (ad esempio, Stable Diffusion) offrono i loro modelli attraverso dashboard intuitivi e facili da usare, altri, come BLOOM, richiedono risorse significative per funzionare. Per cominciare, sono necessari circa 360 GB di RAM per eseguire BLOOM, ma esistono molti trucchi per ridurre i requisiti di risorse.

Man mano che l'hardware con capacità di intelligenza artificiale scende di prezzo e i modelli open-source diventano più semplici da implementare, è possibile che chiunque possa implementare modelli simili a ChatGPT. La fuga di notizie di Google cita esempi di persone che hanno messo a punto e implementato LLaMA su dispositivi consumer, tra cui un MacBook.

Per le aziende con risorse IT significative, I modelli open-source consentono di risparmiare denaro e di ottenere la sovranità dei dati e il controllo sulla formazione e sull'ottimizzazione.

Tuttavia, non tutti sono ottimisti sull'impatto della potente IA open-source. Per esempio, il ricercatore di cybersicurezza Jeffrey Ladis ha twittato: "Preparatevi a un sacco di spam e tentativi di phishing personalizzati" e "L'open sourcing di questi modelli è stata un'idea terribile".

La proliferazione dell'IA ci rende tutti meno sicuri. Sembra una buona cosa da prevenire, e anche una sfida piuttosto difficile!

Non sarei così sorpreso se un attore statale riuscisse ad entrare in possesso dei modelli di frontiera di OpenAI nel prossimo anno o due. https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10 maggio 2023

Un altro osservatore ha twittato: "L'open source è una minaccia, ma non nel modo in cui pensate. È una minaccia perché l'IA nelle mani di persone che possono usarla per i propri scopi diventa ancora più difficile da regolamentare o tenere sotto controllo, e questo è un problema più grande".

Google e OpenAI sostengono di avere paura dell'IA open source, che non c'è "nessun fossato" tra loro. Ma non è proprio così.

L'open source è una minaccia, ma non nel modo in cui pensate. È una minaccia perché l'IA nelle mani di persone che possono usarla per i propri scopi diventa ancora più difficile da... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5 maggio 2023

Yann LeCun, spesso considerato un "padrino dell'IA" insieme a Geoffrey Hinton e Yoshio Bengman, sostiene il contrarioUna volta che i LLM diventeranno il canale principale attraverso il quale tutti accedono alle informazioni, le persone (e i governi) *chiederanno* che siano aperti e trasparenti. Le infrastrutture di base devono essere aperte".

LeCun si è anche dissociato dalla narrativa mainstream sui rischi dell'IA: "Penso che la portata del problema dell'allineamento dell'IA sia stata ridicolmente gonfiata e la nostra capacità di risolverlo ampiamente sottovalutata". Elon Musk ha risposto su Twitter: "Pensi davvero che l'IA sia un'arma a doppio taglio?".

Pensi davvero che l'IA sia un'arma a doppio taglio?

- Elon Musk (@elonmusk) 1 aprile 2023

Altri commentatori hanno fatto un parallelo tra la regolamentazione dell'IA e la crittografia, dove il governo degli Stati Uniti ha cercato di vietare i metodi di crittografia pubblica classificandoli come "munizioni" - soprannominata "guerra delle criptovalute".

Ora, praticamente tutti hanno il diritto di usare la crittografia, ma quella battaglia è stata duramente vinta, come potrebbe essere il caso dell'IA open-source.

L'alienazione dell'IA open-source da parte di OpenAI

L'open source non è solo software, codice e tecnologia. È il principio, la mentalità o la convinzione che un ambiente di lavoro cooperativo, aperto e trasparente superi la concorrenza in un mercato chiuso.

OpenAI, un tempo società senza scopo di lucro incentrata sulla cooperazione pubblica e sullo sviluppo open-source, si è costantemente allontanata dal suo nome.

La startup si è trasformata in un'azienda "a scopo di lucro" nel 2019, ponendo di fatto fine al suo rapporto con la comunità open-source. Gli investimenti di Microsoft hanno disimpegnato OpenAI da qualsiasi tipo di attività di R&S "aperta".

A metà maggio, l'azienda ha annunciato un modello open-source in cantierema non sono stati sinceri con i dettagli.

Ora OpenAI sta spingendo per una regolamentazione che colpirebbe più duramente le aziende di IA emergenti, per non parlare della potenziale criminalizzazione della comunità open-source.

Questo ha portato alcuni a criticare le spinte di OpenAI verso la regolamentazione come se fossero nient'altro che affari: proteggere i loro modelli redditizi dalle comunità open-source che cercano di democratizzare l'IA.

L'intelligenza artificiale open-source è un rischio per le grandi aziende?

La combinazione tra il memo trapelato da Google, la spinta delle big tech per la regolamentazione e la denigrazione di Altman dei progetti di IA di base fa sollevare qualche sopracciglio. In effetti, la legittimità dei rischi dell'IA - che giustificano la regolamentazione - è stata messa in discussione.

Ad esempio, quando il Center for AI Safety (CAIS) ha pubblicato la sua dichiarazione sismica sui rischi dell'IA, co-firmata da diversi CEO dell'IA, alcuni osservatori esterni non erano convinti.

In una selezione di reazioni degli esperti alla dichiarazione pubblicato dal Science Media Centre, ha dichiarato la dott.ssa Mhairi Aitken, Ethics Research Fellow dell'Alan Turing Institute:

"Negli ultimi tempi, queste affermazioni provengono sempre più spesso da grandi operatori tecnologici, soprattutto della Silicon Valley. Sebbene alcuni suggeriscano che ciò sia dovuto alla consapevolezza dei progressi della tecnologia, credo che in realtà si tratti di una tecnica di distrazione. Si sta distogliendo l'attenzione dalle decisioni dei big tech (persone e organizzazioni) che stanno sviluppando l'IA e guidando l'innovazione in questo campo, per concentrare invece l'attenzione su ipotetici scenari futuri e sulle immaginarie capacità future dell'IA".

Alcuni sostengono che le big tech hanno la potenza di fuoco necessaria per dedicare risorse all'etica, alla governance e al monitoraggio, consentendo loro di scrollarsi di dosso il peggio della regolamentazione e di continuare a vendere i propri prodotti.

Tuttavia, è allo stesso tempo problematico denunciare i rischi dell'IA come una fantasia e sostenere che la regolamentazione non ha alcun valore.

Ci sono scettici in entrambi i campi

Liquidare i rischi dell'IA come puramente speculativi potrebbe rivelarsi un errore cruciale per l'umanità.

In effetti, commentatori che non hanno conflitti di interesse hanno messo in guardia dall'IA per decenni, compreso il defunto professor Stephen Hawking, che ha affermato che l'IA "potrebbe segnare la fine della razza umana" ed essere il "peggiore evento nella storia della nostra civiltà".

Sebbene alcuni possano affermare che le big tech stiano brandendo le visioni di un'apocalisse dell'IA per rafforzare le strutture di mercato e innalzare le barriere all'ingresso, ciò non oscura la legittimità dei rischi legati all'IA.

Ad esempio, i team di ricerca sull'IA hanno già dimostrato la capacità dell'IA di stabilire obiettivi emergenti con conseguenze potenzialmente disastrose.

Altri esperimenti dimostrano che le IA possono raccogliere attivamente risorse, accumulare energia e adottare misure proattive per evitare di essere "spente". Studi credibili suggeriscono che almeno alcuni rischi legati alle IA non sono troppo esagerati.

Punti di vista compatibili?

La domanda è: possiamo fidarci di noi stessi con un'IA eccezionalmente potente? "Noi" siamo gli esseri umani ovunque, a tutti i livelli, dai grandi laboratori di ricerca tecnologica alle comunità che costruiscono IA open-source.

Le grandi aziende tecnologiche potrebbero voler consolidare le strutture di mercato, alimentando al contempo le preoccupazioni sul futuro dell'IA. Le due cose non si escludono necessariamente a vicenda.

Nel frattempo, l'ascesa dell'IA open-source è inevitabile e la regolamentazione rischia di creare malcontento in una comunità che possiede una delle tecnologie più pericolose dell'umanità.

È già troppo tardi per sottomettere l'IA open-source attraverso la regolamentazione e il tentativo di farlo potrebbe portare a un'era distruttiva di proibizione dell'IA.

Allo stesso tempo, le discussioni sui pericoli dell'IA dovrebbero essere guidate dalle prove - l'unico segnale oggettivo che abbiamo del potenziale di danno della tecnologia.