La ricerca antropica ha rivelato che il loro ultimo modello di IA, Claude 3 Opus, è in grado di generare argomentazioni altrettanto persuasive di quelle create dagli esseri umani.

Il ricercaguidato da Esin Durmus, esplora la relazione tra la scala del modello e la persuasività nelle diverse generazioni di modelli linguistici antropici.

Si è concentrata su 28 argomenti complessi ed emergenti, come la moderazione dei contenuti online e le linee guida etiche per l'esplorazione spaziale, su cui è meno probabile che le persone abbiano opinioni concrete o consolidate.

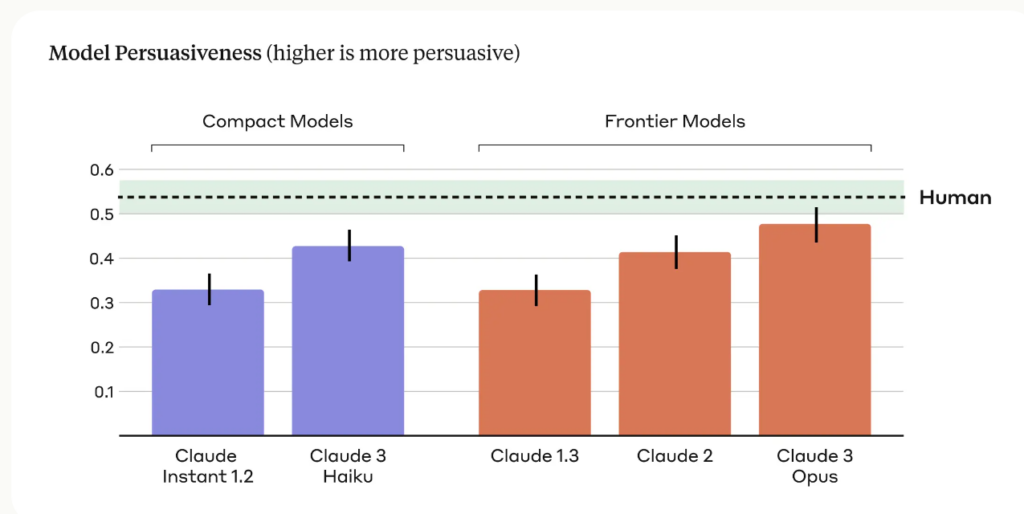

I ricercatori hanno confrontato la persuasività delle argomentazioni generate da vari modelli antropici, tra cui Claude 1, 2 e 3, con quelle scritte da partecipanti umani.

I risultati principali dello studio includono:

- Lo studio ha utilizzato quattro diversi prompt per generare argomentazioni generate dall'intelligenza artificiale, cogliendo una più ampia gamma di stili e tecniche di scrittura persuasiva.

- Claude 3 Opus, il modello più avanzato di Anthropic, ha prodotto argomenti statisticamente indistinguibili da quelli scritti da esseri umani in termini di persuasività.

- È stata osservata una chiara tendenza all'aumento tra le varie generazioni di modelli, con ogni generazione successiva che ha dimostrato una maggiore persuasività sia nei modelli compatti che in quelli di frontiera.

Il team di Anthropic ammette dei limiti, scrivendo: "La persuasione è difficile da studiare in laboratorio: i nostri risultati potrebbero non essere trasferiti al mondo reale".

Tuttavia, il potere persuasivo di Claude è evidentemente impressionante e questo non è l'unico studio che lo dimostra.

Nel marzo del 2024, un team dell'EPFL in Svizzera e dell'Istituto Bruno Kessler in Italia ha scoperto che quando il GPT-4 aveva accesso a informazioni personali sul suo avversario di dibattito, era 81,7% più probabile convincere l'avversario più di un umano.

I ricercatori hanno concluso che "questi risultati forniscono la prova che il microtargeting basato sulle LLM supera nettamente sia le LLM normali che il microtargeting basato sugli esseri umani, con il GPT-4 che è in grado di sfruttare le informazioni personali in modo molto più efficace degli esseri umani".

IA persuasiva per l'ingegneria sociale

I rischi più evidenti dei LLM persuasivi sono la coercizione e l'ingegneria sociale.

Come afferma Anthropic, "la persuasività dei modelli linguistici solleva legittime preoccupazioni per la società in merito all'impiego sicuro e al potenziale uso improprio. La capacità di valutare e quantificare questi rischi è fondamentale per sviluppare misure di salvaguardia responsabili".

Dobbiamo anche essere consapevoli di come la crescente persuasività dei modelli linguistici dell'IA potrebbe combinarsi con una tecnologia di clonazione vocale all'avanguardia come Voice Engine di OpenAI, che OpenAI ha ritenuto rischioso rilasciare.

VoiceEngine ha bisogno di soli 15 secondi per clonare realisticamente una voce, che potrebbe essere utilizzata per qualsiasi cosa, comprese sofisticate frodi o truffe di ingegneria sociale.

False truffe profonde sono già molto diffusi e aumenterà di livello se gli attori delle minacce uniranno la tecnologia di clonazione vocale alle tecniche di persuasione dell'IA, che si dimostreranno spaventosamente competenti.