Microsoft ha lanciato Phi-3 Mini, un piccolo modello linguistico che fa parte della strategia dell'azienda di sviluppare modelli di intelligenza artificiale leggeri e specifici per ogni funzione.

La progressione dei modelli linguistici ha visto parametri, dataset di addestramento e finestre di contesto sempre più grandi. La scalata delle dimensioni di questi modelli ha fornito capacità più potenti, ma a un costo.

L'approccio tradizionale all'addestramento di un LLM consiste nel fargli consumare enormi quantità di dati, il che richiede enormi risorse di calcolo. Si stima che l'addestramento di un LLM come il GPT-4, ad esempio, abbia richiesto circa 3 mesi e sia costato oltre $21m.

GPT-4 è un'ottima soluzione per le attività che richiedono un ragionamento complesso, ma è eccessivo per le attività più semplici come la creazione di contenuti o un chatbot di vendita. È come usare un coltellino svizzero quando invece è sufficiente un semplice tagliacarte.

Con soli 3,8B parametri, Phi-3 Mini è minuscolo. Tuttavia, Microsoft sostiene che si tratta di una soluzione leggera e a basso costo ideale per attività come la sintesi di un documento, l'estrazione di informazioni dai rapporti e la scrittura di descrizioni di prodotti o post sui social media.

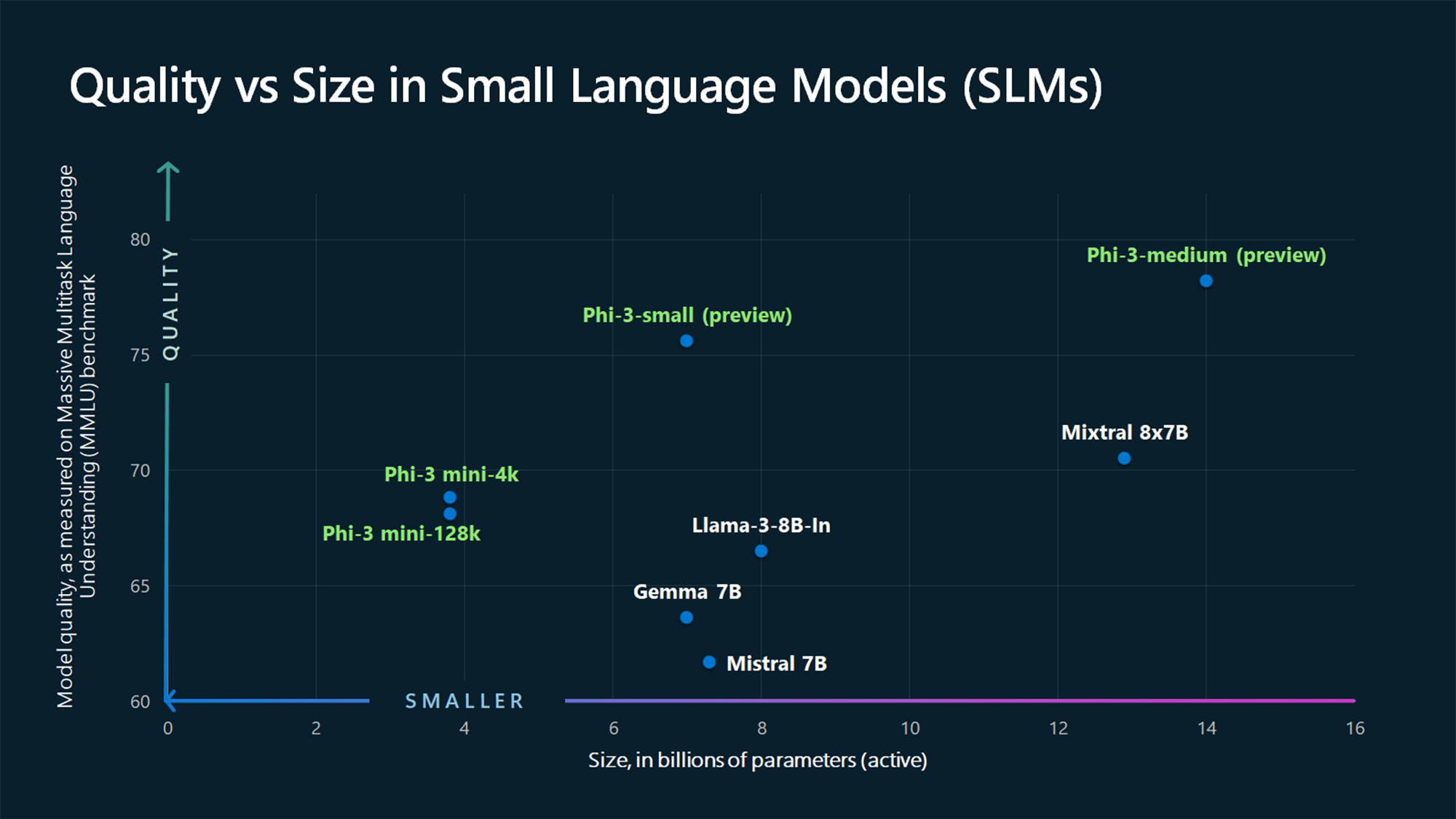

I dati dei benchmark MMLU mostrano che Phi-3 Mini e i modelli Phi più grandi, ancora da rilasciare, battono modelli più grandi come Mistral 7B e Gemma 7B.

Microsoft afferma che Phi-3-small (7B parametri) e Phi-3-medium (14B parametri) saranno disponibili "a breve" nell'Azure AI Model Catalog.

I modelli più grandi come il GPT-4 sono ancora il gold standard e possiamo probabilmente aspettarci che il GPT-5 sarà ancora più grande.

Le SLM come Phi-3 Mini offrono alcuni importanti vantaggi che i modelli più grandi non offrono. Gli SLM sono più economici da mettere a punto, richiedono meno calcolo e possono essere eseguiti sul dispositivo anche in situazioni in cui non è disponibile l'accesso a Internet.

L'implementazione di un SLM ai margini consente di ridurre la latenza e di massimizzare la privacy, perché non è necessario inviare i dati avanti e indietro al cloud.

Ecco Sebastien Bubeck, vicepresidente della ricerca GenAI di Microsoft AI con una dimostrazione di Phi-3 Mini. È velocissimo e impressionante per un modello così piccolo.

phi-3 è arrivato, ed è... buono :-).

Ho realizzato una breve demo per darvi un'idea di cosa può fare phi-3-mini (3.8B). Rimanete sintonizzati per il rilascio dei pesi aperti e per ulteriori annunci domani mattina!

(E naturalmente non sarebbe completo senza la consueta tabella dei benchmark). pic.twitter.com/AWA7Km59rp

- Sebastien Bubeck (@SebastienBubeck) 23 aprile 2024

Dati sintetici curati

Phi-3 Mini è il risultato dell'abbandono dell'idea che enormi quantità di dati siano l'unico modo per addestrare un modello.

Sebastien Bubeck, vicepresidente di Microsoft per la ricerca sull'IA generativa, ha chiesto: "Invece di allenarsi solo su dati web grezzi, perché non cercare dati di qualità estremamente elevata?".

Ronen Eldan, esperto di apprendimento automatico di Microsoft Research, stava leggendo le storie della buonanotte a sua figlia quando si è chiesto se un modello linguistico potesse imparare usando solo le parole che un bambino di 4 anni può capire.

Questo ha portato a un esperimento in cui hanno creato un set di dati a partire da 3.000 parole. Utilizzando solo questo vocabolario limitato, hanno indotto un LLM a creare milioni di brevi storie per bambini che sono state raccolte in un set di dati chiamato TinyStories.

I ricercatori hanno quindi utilizzato TinyStories per addestrare un modello estremamente piccolo, con 10 milioni di parametri, che è stato poi in grado di generare "narrazioni fluenti con una grammatica perfetta".

Hanno continuato a iterare e a scalare questo approccio di generazione di dati sintetici per creare insiemi di dati sintetici più avanzati, ma accuratamente curati e filtrati, che sono stati infine utilizzati per addestrare Phi-3 Mini.

Il risultato è un modello di dimensioni ridotte che sarà più economico da gestire, pur offrendo prestazioni paragonabili a quelle di GPT-3.5.

Modelli più piccoli ma più capaci vedranno le aziende abbandonare la scelta di LLM di grandi dimensioni come il GPT-4. Potremmo anche vedere presto soluzioni in cui un LLM si occupa del lavoro pesante ma delega i compiti più semplici a modelli leggeri.