Si parla molto di sicurezza dell'IA, ma questo significa che è molto presente nella ricerca?

Un nuovo studio dell'Emerging Technology Observatory della Georgetown University suggerisce che, nonostante il rumore, la ricerca sulla sicurezza dell'IA occupa solo una minuscola minoranza dell'attenzione del settore.

I ricercatori hanno analizzato oltre 260 milioni di pubblicazioni accademiche e hanno scoperto che solo il 2% degli articoli relativi all'IA pubblicati tra il 2017 e il 2022 ha affrontato direttamente argomenti relativi alla sicurezza, all'etica, alla robustezza o alla governance dell'IA.

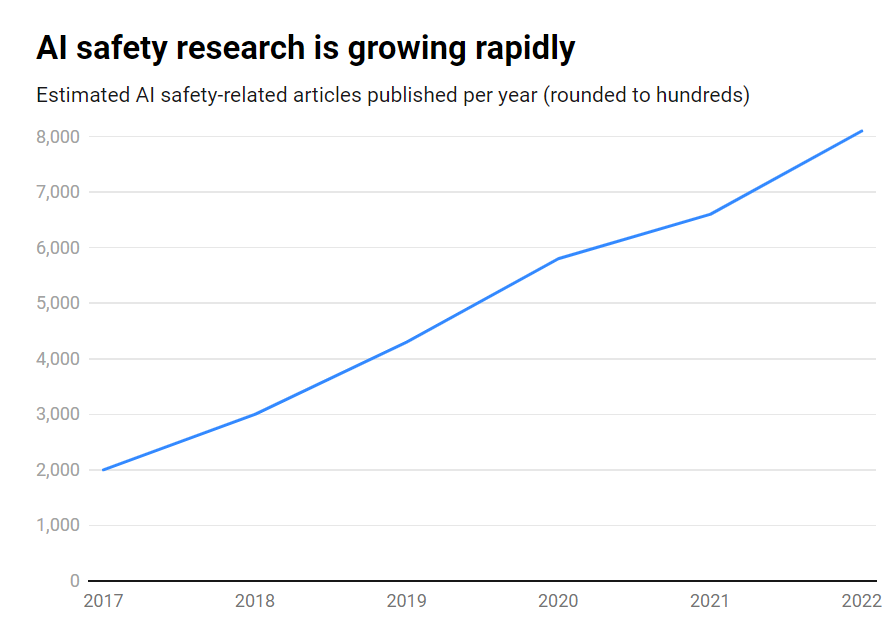

Sebbene il numero di pubblicazioni sulla sicurezza dell'IA sia cresciuto in modo impressionante, passando da circa 1.800 a oltre 7.000 all'anno, la questione rimane un tema periferico.

Ecco i risultati principali:

- Solo il 2% della ricerca sull'IA nel periodo 2017-2022 si è concentrato sulla sicurezza dell'IA.

- La ricerca sulla sicurezza dell'IA è cresciuta del 315% in quel periodo, ma è inferiore alla ricerca complessiva sull'IA.

- Gli Stati Uniti sono in testa nella ricerca sulla sicurezza dell'intelligenza artificiale, mentre la Cina è in ritardo

- Le sfide principali includono la robustezza, l'equità, la trasparenza e il mantenimento del controllo umano.

Molti importanti ricercatori ed etici dell'IA hanno messo in guardia da rischi esistenziali se l'intelligenza artificiale generale (AGI) venisse sviluppata senza sufficienti salvaguardie e precauzioni.

Immaginate un sistema AGI in grado di migliorarsi ricorsivamente, superando rapidamente l'intelligenza umana e perseguendo al contempo obiettivi non allineati con i nostri valori. È uno scenario che, secondo alcuni, potrebbe sfuggire al nostro controllo.

Tuttavia, non si tratta di un traffico a senso unico. Infatti, un gran numero di ricercatori di intelligenza artificiale ritiene che La sicurezza dell'intelligenza artificiale è sopravvalutata.

Inoltre, alcuni pensano che il clamore sia stato creato per aiutare le Big Tech a far rispettare le normative e a eliminare le organizzazioni di base e le organizzazioni di volontariato. concorrenti open-source.

Tuttavia, anche gli attuali sistemi di intelligenza artificiale, addestrati sulla base di dati passati, possono presentare pregiudizi, produrre contenuti dannosi, violare la privacy ed essere utilizzati in modo malevolo.

Quindi, se da un lato la sicurezza dell'IA deve guardare al futuro, dall'altro deve affrontare i rischi nel presente, il che è probabilmente insufficiente dal momento che i falsi profondi, i pregiudizi e altri problemi continuano a incombere.

Una ricerca efficace sulla sicurezza dell'IA deve affrontare le sfide a breve termine e i rischi speculativi a lungo termine.

Gli Stati Uniti guidano la ricerca sulla sicurezza dell'intelligenza artificiale

Scendendo nel dettaglio dei dati, gli Stati Uniti sono il leader indiscusso nella ricerca sulla sicurezza dell'IA, con 40% di pubblicazioni correlate rispetto alle 12% della Cina.

Tuttavia, la produzione cinese in materia di sicurezza è molto inferiore alla ricerca complessiva sull'IA: mentre il 5% della ricerca americana sull'IA ha riguardato la sicurezza, solo l'1% di quella cinese lo ha fatto.

Si potrebbe ipotizzare che sondare la ricerca cinese sia un compito del tutto difficile. Inoltre, la Cina è stata proattivi nei confronti della regolamentazione - probabilmente più degli Stati Uniti, quindi questi dati potrebbero non dare il giusto peso all'industria dell'IA del Paese.

A livello di istituzioni, Carnegie Mellon University, Google, MIT e Stanford sono in testa.

Tuttavia, a livello globale, nessuna organizzazione ha prodotto più del 2% del totale delle pubblicazioni sulla sicurezza, evidenziando la necessità di uno sforzo più ampio e concertato.

Squilibri di sicurezza

Cosa si può fare per correggere questo squilibrio?

Dipende se si ritiene che la sicurezza delle IA sia un rischio urgente al pari della guerra nucleare, delle pandemie, ecc. Non c'è una risposta chiara a questa domanda, il che rende la sicurezza delle IA un argomento altamente speculativo e poco condiviso. accordo tra ricercatori.

Anche la ricerca sulla sicurezza e l'etica sono un ambito in qualche modo tangenziale all'apprendimento automatico, che richiede competenze diverse, background accademici e così via, che potrebbero non essere ben finanziati.

Per colmare il divario di sicurezza dell'IA sarà inoltre necessario affrontare le questioni relative all'apertura e alla segretezza dello sviluppo dell'IA.

Le più grandi aziende tecnologiche conducono ampie ricerche interne sulla sicurezza che non sono mai state pubblicate. Con l'accelerazione della commercializzazione dell'IA, le aziende stanno diventando sempre più protettive nei confronti delle loro scoperte.

OpenAI, per esempio, è stato un centro di ricerca nei suoi primi giorni di vita.

L'azienda era solita produrre approfonditi audit indipendenti sui propri prodotti, sulle distorsioni di etichettatura e sui rischi, come ad esempio pregiudizi sessisti nel suo progetto CLIP.

Anthropic è ancora attivamente impegnata nella ricerca sulla sicurezza dell'IA pubblica, pubblicando frequentemente studi su sbieco e jailbreak.

DeepMind ha anche documentato la possibilità che i modelli di IA stabiliscano "obiettivi emergenti" e contraddicano attivamente le loro istruzioni o diventino avversari dei loro creatori.

In generale, però, la sicurezza è passata in secondo piano rispetto al progresso, poiché la Silicon Valley vive secondo il suo motto "muoversi velocemente e rompere le cose".

Lo studio di Georgetown evidenzia in ultima analisi che le università, i governi, le aziende tecnologiche e i finanziatori della ricerca devono investire maggiori sforzi e denaro nella sicurezza dell'IA.

Alcuni hanno anche chiesto un organismo internazionale per la sicurezza dell'IA, simile all'Agenzia Internazionale per l'Energia Atomica (AIEA), istituita dopo una serie di incidenti nucleari che hanno reso obbligatoria una profonda cooperazione internazionale.

L'IA avrà bisogno di una propria catastrofe per ottenere questo livello di cooperazione statale e aziendale? Speriamo di no.