NVIDIA ha rilasciato Chat with RTX come dimostrazione tecnica di come i chatbot AI possano essere eseguiti localmente su PC Windows utilizzando le sue GPU RTX.

L'approccio standard all'uso di un chatbot AI consiste nell'utilizzare una piattaforma web come ChatGPT o nell'eseguire query tramite un'API, con l'inferenza che avviene su server di cloud computing. Gli svantaggi sono i costi, la latenza e i problemi di privacy legati al trasferimento di dati personali o aziendali.

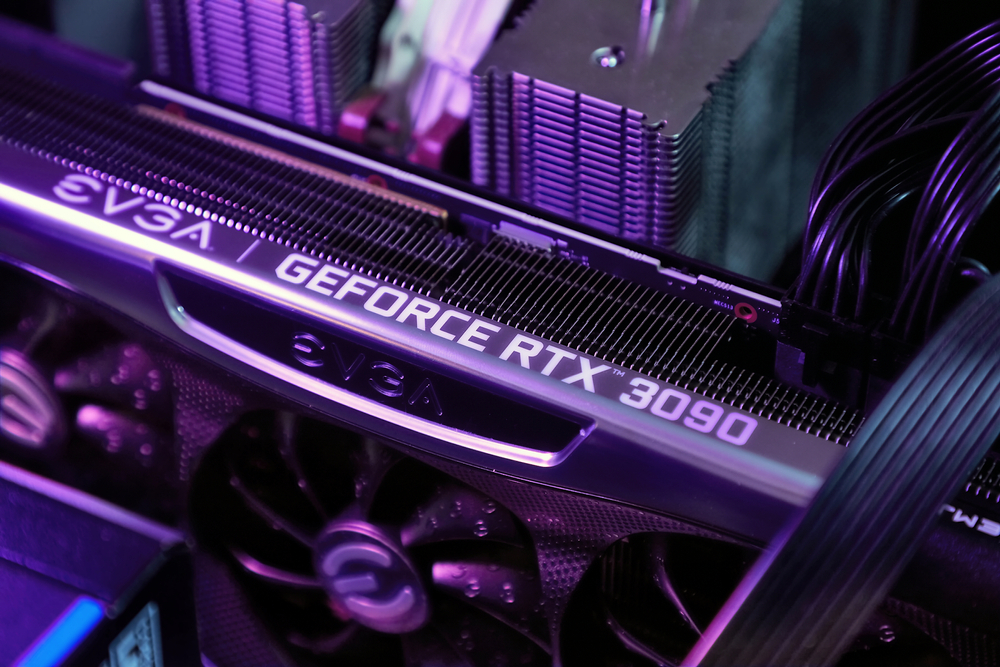

RTX di NVIDIA La gamma di GPU di cui disponiamo rende ora possibile l'esecuzione di un LLM in locale sul proprio PC Windows, anche se non si è connessi a Internet.

Chat with RTX permette agli utenti di creare un chatbot personalizzato utilizzando Maestrale o Lama 2. Utilizza la generazione aumentata del reperimento (RAG) e il software TensorRT-LLM di NVIDIA che ottimizza l'inferenza.

È possibile indirizzare Chat with RTX a una cartella del PC e poi porgli domande relative ai file contenuti nella cartella. Supporta vari formati di file, tra cui .txt, .pdf, .doc/.docx e .xml.

Poiché LLM analizza i file memorizzati localmente e l'inferenza avviene sul vostro computer, è molto veloce e nessuno dei vostri dati viene condiviso su reti potenzialmente non protette.

Si può anche richiedere l'URL di un video di YouTube e porre domande sul video. Ciò richiede l'accesso a Internet, ma è un ottimo modo per ottenere risposte senza dover guardare un lungo video.

È possibile scarica Chat con RTX gratuitamente, ma è necessario eseguire Windows 10 o 11 sul proprio PC con una GPU GeForce RTX 30 Series o superiore, con almeno 8 GB di VRAM.

Chat with RTX è una demo, piuttosto che un prodotto finito. È un po' buggata e non ricorda il contesto, quindi non è possibile farle domande successive. Ma è un bell'esempio del modo in cui utilizzeremo gli LLM in futuro.

L'utilizzo di un chatbot AI in locale, con zero costi di chiamata API e una latenza minima, è probabilmente il modo in cui la maggior parte degli utenti finirà per interagire con i LLM. L'approccio open-source adottato da aziende come Meta farà sì che l'IA sul dispositivo guidi l'adozione dei loro modelli gratuiti piuttosto che di quelli proprietari come GPT.

Detto questo, gli utenti di cellulari e laptop dovranno aspettare ancora un po' prima che la potenza di calcolo di una GPU RTX possa essere inserita in dispositivi più piccoli.