La crescita esponenziale dei sistemi di IA sta superando la ricerca e la regolamentazione, lasciando i governi in una posizione scomoda per bilanciare i vantaggi con i rischi.

Le leggi richiedono anni per essere sviluppate e diventare legalmente vincolanti. L'intelligenza artificiale si evolve settimanalmente.

Questa è la dicotomia che i leader dell'IA e i politici si trovano ad affrontare, con il primo atto normativo significativo sull'IA in Occidente, l'EU AI Act, previsto per il 2026. Anche un anno fa, la ChatGPT era solo un sussurro.

Il 31 maggio, a Luleå, in Svezia, si sono incontrati i massimi funzionari degli Stati Uniti e dell'Unione europea per il Trade and Tech Council (TTC). Margrethe Vestager, commissario europeo per il digitale, che la settimana precedente aveva incontrato il CEO di Google Sundar Pichai per discutere di un potenziale "patto sull'intelligenza artificiale", ha dichiarato: "La democrazia deve dimostrare di essere veloce quanto la tecnologia".

I funzionari riconoscono l'enorme divario tra il ritmo della tecnologia e quello della legislazione. Riferendosi all'IA generativa come ChatGPT, Gina Raimondo, segretario al Commercio degli Stati Uniti, ha dichiarato: "Sta arrivando a un ritmo come nessun'altra tecnologia".

Che cosa ha ottenuto la riunione del TTC?

Watermarking, audit esterni, cicli di feedback: sono solo alcune delle idee discusse con @AnthropicAI e @sama @OpenAI per il #AI #Codice di condotta lanciato oggi al #TTC in #Luleå @SecRaimondo Non vediamo l'ora di discutere con i partner internazionali. pic.twitter.com/wV08KDNs3h

- Margrethe Vestager (@vestager) 31 maggio 2023

I partecipanti hanno discusso soprattutto dei quadri non vincolanti o volontari in materia di rischio e trasparenza, che saranno presentati al G7 in autunno.

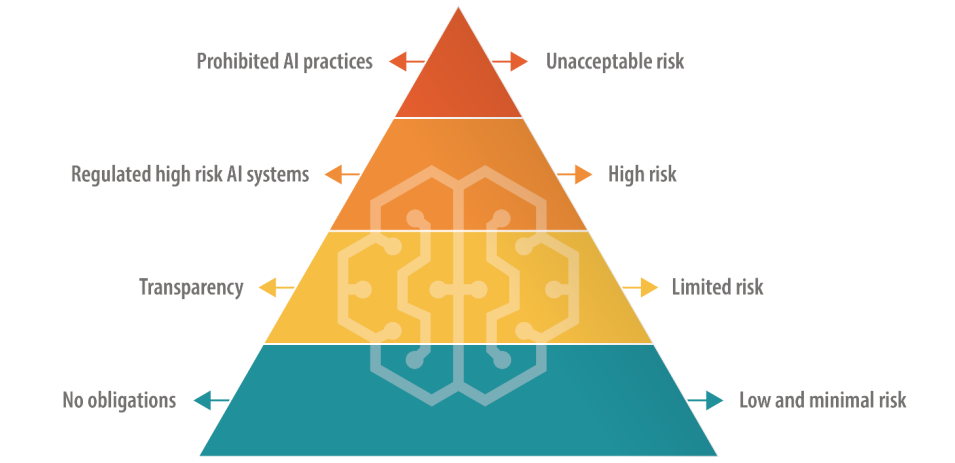

L'UE, che ha un approccio diretto alla legislazione digitale, opta per un approccio graduale alla regolamentazione dell'IA, in cui le IA sono suddivise in categorie in base al rischio.

Questo include un livello vietato di "rischio inaccettabile" e un livello di "alto rischio", che i leader tecnologici come il CEO di OpenAI Sam Altman temono possa compromettere la funzionalità dei loro prodotti.

Gli Stati Uniti non propongono regolamenti così definitivi, favorire le regole volontarie.

Saranno necessari molti altri incontri tra l'UE, gli Stati Uniti e le grandi aziende tecnologiche per allineare i punti di vista con azioni pratiche significative.

Le regole volontarie sull'IA funzioneranno?

Ci sono molti esempi di regole volontarie in altri settori e industrie, come i quadri volontari per la sicurezza dei dati e le informazioni ESG, ma nessuno è così vicino all'avanguardia come un quadro volontario di governance dell'IA.

Dopo tutto, abbiamo a che fare con una minaccia di livello estintivo, secondo i principali leader tecnologici e accademici che hanno firmato il documento Dichiarazione del Center for AI Safety sui rischi dell'intelligenza artificiale questa settimana.

Grandi aziende come OpenAI e Google dispongono già di dipartimenti centrali che si occupano di governance e di questioni di conformità interna, quindi allineare i loro prodotti e servizi ai quadri volontari potrebbe essere una questione di riscrittura dei documenti di politica interna.

Le regole volontarie sono meglio di niente, ma con numerose proposte sul tavolo, i politici e i leader dell'IA dovranno prima o poi scegliere qualcosa con cui correre.