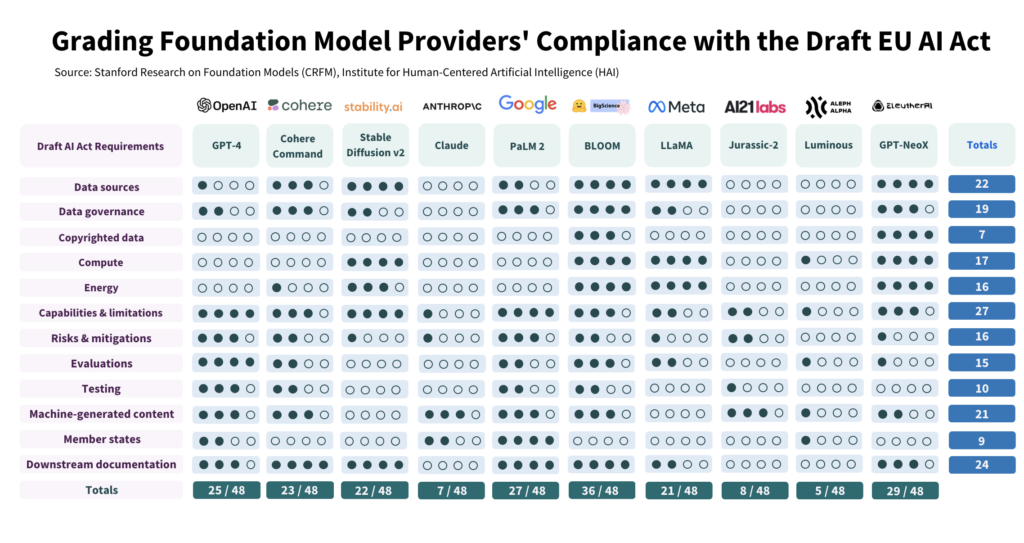

I ricercatori di IA di Stanford hanno valutato la conformità di 10 modelli di IA leader rispetto alla proposta di legge europea sull'IA e hanno riscontrato un'ampia variazione, con risultati generalmente poco soddisfacenti.

Lo studio L'indagine ha esaminato criticamente 10 modelli di IA rispetto ai 12 criteri stabiliti nella proposta di legge dell'UE e ha rilevato un'ampia variazione di conformità, con nessun modello che ha soddisfatto tutte le condizioni.

Lo studio evidenzia il divario tra le aspettative della legge sull'IA e gli attuali sforzi di governance dei principali sviluppatori di IA.

Per conformarsi alla legge, gli sviluppatori devono migliorare notevolmente la trasparenza e le strategie di mitigazione del rischio, che in alcuni casi sono quasi del tutto assenti.

Come è stato condotto lo studio

Gli autori hanno condotto uno studio dettagliato della legge sull'AI, ricavandone 22 requisiti.

Tra questi, ne hanno selezionati 12 che potevano essere valutati in modo significativo utilizzando le informazioni pubbliche. Hanno quindi creato una griglia di valutazione a 5 punti per ciascuno di questi 12 requisiti.

Il modello di intelligenza artificiale open-source BLOOM, prodotto da Hugging Face, ha ottenuto il punteggio più alto con un totale di 36 punti su 48 potenziali.

Al contrario, Anthropic, sostenuta da Google, e l'azienda tedesca di intelligenza artificiale Aleph Alpha hanno ottenuto risultati significativamente inferiori, rispettivamente con un punteggio di 7 e 5. ChatGPT si è piazzato a metà del gruppo con 25/48.

Le 4 principali aree di non conformità sono i dati protetti da copyright, l'energia, la mitigazione del rischio e la valutazione/test.

Uno degli autori, Kevin Klyman, ricercatore presso il Center for Research on Foundation Models di Stanford, ha osservato che la maggior parte degli sviluppatori non rende note le proprie strategie di mitigazione del rischio, il che potrebbe essere un fattore di rottura. Klyman ha dichiarato: "I fornitori spesso non rivelano l'efficacia delle loro misure di mitigazione del rischio, il che significa che non possiamo dire quanto siano rischiosi alcuni modelli di fondazione".

Inoltre, c'è un'ampia variazione nei dati utilizzati per l'addestramento dei modelli. L'UE richiederà agli sviluppatori di IA di essere più trasparenti con le loro fonti di dati, cosa che 4/10 degli sviluppatori non fanno. ChatGPT ha ottenuto solo 1 punto in quest'area.

Modelli open source contro modelli proprietari

Il rapporto ha inoltre rilevato una chiara dicotomia nella conformità a seconda che un modello sia open source o proprietario.

I modelli open-source hanno ottenuto buoni punteggi per quanto riguarda la divulgazione delle risorse e i requisiti dei dati, ma i loro rischi sono in gran parte non documentati.

I modelli proprietari sono l'opposto: sono pesantemente testati e altamente documentati con solide strategie di mitigazione del rischio, ma non sono trasparenti per quanto riguarda i dati e le metriche relative alla tecnologia.

O, per dirla in modo più preciso, gli sviluppatori open-source non hanno così tanti segreti competitivi da proteggere, ma i loro prodotti sono intrinsecamente più rischiosi, in quanto possono essere utilizzati e modificati da quasi tutti.

Al contrario, gli sviluppatori privati probabilmente terranno sotto chiave alcuni aspetti dei loro modelli, ma potranno dimostrare di aver ridotto la sicurezza e i rischi. Persino Microsoft, l'investitore principale di OpenAI, non è completamente capire come funzionano i modelli di OpenAI.

Cosa raccomanda lo studio?

Gli autori dello studio riconoscono che il divario tra le aspettative dell'UE e la realtà è allarmante e propongono diverse raccomandazioni ai responsabili politici e agli sviluppatori di modelli.

Lo studio raccomanda ai responsabili politici dell'UE:

- Affinare e specificare i parametri dell'Atto UE sull'IA: I ricercatori sostengono che il linguaggio tecnico e i parametri della legge sull'IA non sono specificati.

- Promuovere la trasparenza e la responsabilità: I ricercatori sostengono che le regole più severe dovrebbero essere mirate agli sviluppatori più grandi e dominanti, il che dovrebbe portare a un'applicazione più efficace.

- Fornire risorse sufficienti per l'applicazione della legge: Affinché la legge europea sull'intelligenza artificiale sia applicata in modo efficace, è necessario mettere a disposizione delle agenzie di controllo risorse tecniche e talento.

Lo studio raccomanda ai responsabili politici globali:

- Privilegiare la trasparenza: I ricercatori sottolineano che la trasparenza è fondamentale e dovrebbe essere l'obiettivo principale degli sforzi politici. Sostengono che gli insegnamenti tratti dalla regolamentazione dei social media rivelano le conseguenze dannose di una trasparenza carente, che non dovrebbero ripetersi nel contesto dell'IA.

- Chiarire le questioni relative al copyright: I confini del diritto d'autore per i dati di addestramento e i risultati dell'IA sono molto dibattuti. Data la scarsa conformità osservata nella divulgazione dei dati di addestramento protetti da copyright, i ricercatori sostengono che le linee guida legali devono specificare come il copyright interagisce con le procedure di addestramento e i risultati dei modelli generativi. Ciò include la definizione dei termini in cui il copyright o le licenze devono essere rispettati durante l'addestramento e la determinazione di come i contenuti generati dalle macchine possano violare il copyright.

Lo studio raccomanda agli sviluppatori di modelli di fondazione:

- Sforzarsi di migliorare continuamente: I fornitori dovrebbero puntare costantemente a migliorare la propria conformità. I fornitori più grandi, come OpenAI, dovrebbero dare l'esempio e diffondere le risorse ai clienti a valle che accedono ai loro modelli tramite API.

- Sostenere gli standard del settore: I fornitori di modelli dovrebbero contribuire alla definizione di standard di settore, che possono portare a un ecosistema di IA più trasparente e responsabile.

Sebbene gli standard di rischio e di monitoraggio stabiliti da sviluppatori leader come OpenAI presentino alcuni aspetti positivi, le carenze in aree come il copyright sono tutt'altro che ideali.

Per quanto riguarda l'applicazione della regolamentazione all'IA come categoria onnicomprensiva - potrebbe rivelarsi davvero molto complicato - poiché i modelli commerciali e open-source sono strutturalmente distinti e difficili da mettere insieme.