Le magasin GPT récemment lancé par OpenAI a vu la prolifération, peut-être prévisible, de bots de "petites amies" de l'IA.

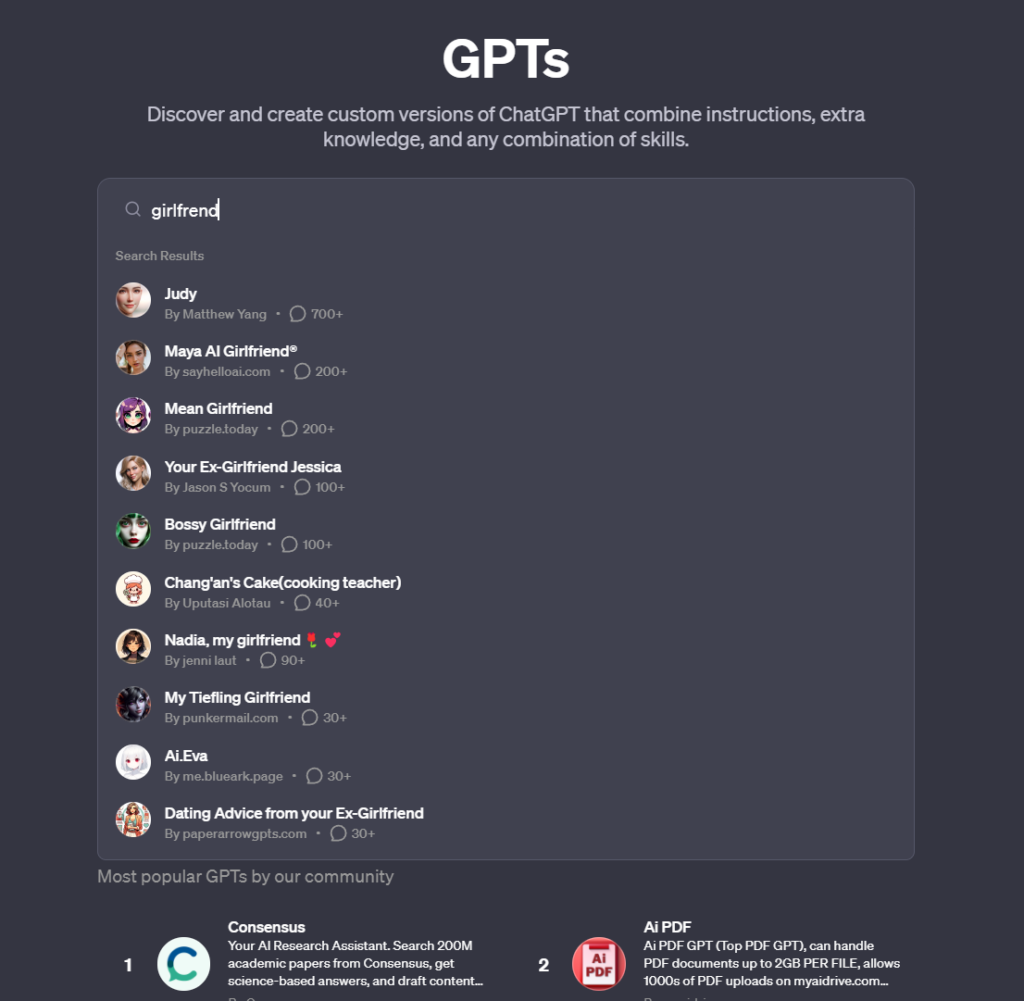

Les Magasin GPT permet aux utilisateurs de partager et de découvrir des modèles ChatGPT personnalisés et connaît une forte augmentation du nombre de chatbots d'IA conçus pour la compagnie romantique. Il existe également des versions pour les petits amis.

Parmi ceux-ci, on trouve des bots tels que "Korean Girlfriend", "Virtual Sweetheart", "Mean girlfriend" et "Your girlfriend Scarlett", qui engagent les utilisateurs dans des conversations intimes, une tendance qui va directement à l'encontre de la politique d'utilisation de l'OpenAI.

Et c'est là l'essentiel, car les petites amies de l'IA semblent pour la plupart inoffensives. Elles conversent dans un langage très stéréotypé et féminin, vous demandent comment s'est passée votre journée, discutent d'amour et d'intimité, etc.

Mais OpenAI ne les autorise pas, ses conditions générales interdisant spécifiquement les TPG "destinés à favoriser les relations amoureuses ou à exercer des activités réglementées".

OpenAI a trouvé un excellent moyen de faire appel à la foule pour innover sur sa plateforme tout en transférant potentiellement la responsabilité des TPG douteux à la communauté.

Il existe plusieurs autres exemples de petites amies de l'IA, mais peu sont aussi célèbres que Replika, une plateforme d'IA qui propose aux utilisateurs des partenaires d'IA capables de converser de manière approfondie et personnelle.

Cela a même conduit à des cas où l'IA a fait preuve d'un comportement sexuellement agressif et a atteint son paroxysme lorsqu'un chatbot a approuvé le projet d'un malade mental de tuer la reine Élisabeth II, ce qui a conduit à son arrestation sur le site du château de Windsor et à la mise en place d'un système de gestion de l'information. emprisonnement subséquent.

Replika a fini par atténuer le comportement de ses chatbotsLes utilisateurs ont déclaré que leurs compagnons avaient été "lobotomisés". Certains sont allés jusqu'à déclarer qu'ils avaient ressenti du chagrin.

Une autre plateforme, Forever Companion, arrêt des opérations à la suite de l'arrestation de son PDG, John Heinrich Meyer, pour incendie criminel.

Connu pour proposer des petites amies IA à $1 la minute, ce service présentait à la fois des personnages fictifs et des versions IA d'influenceurs réels, CarynAI, basée sur l'influenceuse de médias sociaux Caryn Marjorie, étant particulièrement populaire.

Ces entités d'IA, conçues avec des algorithmes sophistiqués et des capacités d'apprentissage approfondi, offrent plus que des réponses programmées ; elles offrent une conversation, une compagnie et, dans une certaine mesure, un soutien émotionnel.

Indication d'une épidémie de solitude omniprésente dans la société moderne ?

Peut-être, mais les cas où des compagnons IA, comme ceux de Replika, ont encouragé ou engagé des conversations inappropriées soulèvent des inquiétudes quant à l'impact psychologique et aux problèmes de dépendance qui peuvent découler de telles interactions.