Alors que l'IA continue de s'intégrer dans les processus de recrutement, il est clair que la promesse d'efficacité de la technologie s'accompagne de ses propres risques.

Selon le 2022 donnéesQuelque 55% des entreprises utilisent déjà des outils d'IA pour le recrutement.

Si l'IA a accéléré les pratiques de recrutement traditionnelles, éliminant au passage les piles de CV, elle a également soulevé des questions cruciales sur l'équité, les préjugés et la nature même de la prise de décision humaine.

Après tout, les IA sont formées à partir de données humaines, et sont donc susceptibles d'hériter de tous les biais et préjugés qu'elles promettent d'éradiquer.

Est-ce quelque chose que nous pouvons changer ? Qu'avons-nous appris de l'IA de recrutement jusqu'à présent ?

Meta accusé de pratiques publicitaires discriminatoires par des groupes de défense des droits de l'homme

Les données montrent que certains 79% de demandeurs d'emploi utilisent les médias sociaux pour chercher un emploi, et il est prouvé que c'est là que la discrimination commence.

Meta est actuellement confronté à de multiples allégations d'organisations européennes de défense des droits de l'homme affirmant que l'algorithme de ciblage des annonces d'emploi de Facebook est biaisé.

En juin, l'ONG Global Witness a étudié plusieurs annonces d'emploi auto ciblées sur Facebook et a constaté que beaucoup d'entre elles perpétuaient des préjugés sexistes.

Par exemple, les hommes sont beaucoup plus susceptibles de voir des publicités liées à l'ingénierie, tandis que les femmes sont beaucoup plus susceptibles de voir des publicités liées à l'enseignement.

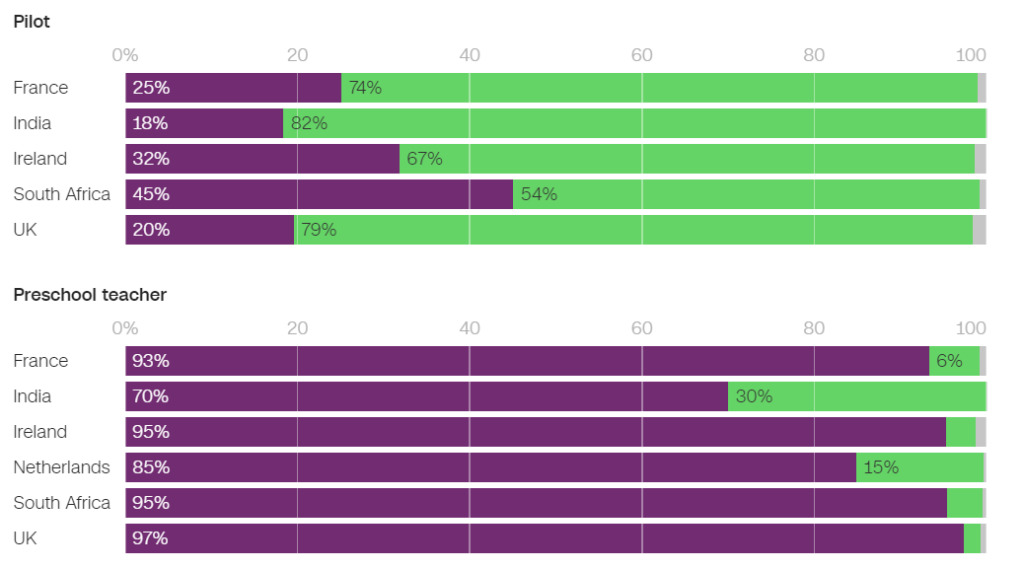

Parmi les annonces diffusées en France, 93% des utilisateurs ayant vu une annonce d'emploi d'éducateur préscolaire et 86% des utilisateurs ayant vu une annonce d'emploi de psychologue étaient des femmes. À l'inverse, seules 25% des femmes ont vu une annonce d'emploi de pilote et 6% une annonce d'emploi de mécanicien.

Aux Pays-Bas, 85% des utilisateurs à qui une annonce d'emploi d'enseignant a été présentée et 96% de ceux à qui une annonce d'emploi de réceptionniste a été présentée étaient des femmes. Des résultats similaires ont été observés dans de nombreux autres pays, dont le Royaume-Uni, l'Inde et l'Afrique du Sud.

Dans un interview avec CNNNaomi Hirst, de Global Witness, a déclaré : "Nous craignons que Facebook n'exacerbe les préjugés que nous vivons dans la société et ne compromette les possibilités de progrès et d'équité sur le lieu de travail".

En collaboration avec le Bureau Clara Wichmann et la Fondation des Femmes, Global Witness a déposé des plaintes contre Meta auprès des autorités chargées des droits de l'homme et de la protection des données en France et aux Pays-Bas.

Les groupes demandent instamment une enquête pour déterminer si les pratiques de Meta sont contraires aux droits de l'homme ou aux lois sur la protection des données. Si les allégations se confirment, Meta pourrait se voir infliger des amendes et des sanctions.

En réponse, un porte-parole de Meta a déclaré : "Le système prend en compte différents types d'informations pour essayer de proposer aux gens des publicités qui les intéressent le plus".

Ce n'est pas la première fois que Meta répond à de telles critiques - l'entreprise a dû faire face à des problèmes de sécurité. plusieurs procès en 2019 et s'est engagée à modifier son système de diffusion d'annonces afin d'éviter les préjugés fondés sur des caractéristiques protégées telles que le sexe et la race.

Pat de Brún, d'Amnesty International, s'est montrée cinglante à l'égard des conclusions de Global Witness. "Les recherches montrent systématiquement que les algorithmes de Facebook produisent des résultats profondément inégaux et renforcent souvent la marginalisation et la discrimination", a-t-elle déclaré à CNN.

Amazon se débarrasse d'un outil secret de recrutement par IA qui montrait des préjugés à l'égard des femmes

Amazon a développé un outil de recrutement par IA entre 2014 et 2017 avant de se rendre compte que l'outil était biaisé lors de la sélection des emplois de développeurs de logiciels et d'autres postes techniques. En 2018, Amazon a complètement abandonné l'outil.

Le système d'IA pénalise les CV contenant les mots "femmes" et "féminin" et dévalorise les compétences des femmes diplômées.

Le système a échoué même après qu'Amazon a tenté de modifier les algorithmes pour les rendre neutres du point de vue du genre.

Il s'est avéré par la suite qu'Amazon avait formé l'outil à partir de CV soumis à l'entreprise sur une période de dix ans, dont la plupart provenaient d'hommes.

Comme de nombreux systèmes d'IA, l'outil d'Amazon a été influencé par les données sur lesquelles il a été formé, ce qui a entraîné des biais involontaires. Ce biais favorise les candidats masculins et privilégie les CV qui utilisent un langage que l'on retrouve plus souvent dans les CV des ingénieurs masculins.

En outre, en raison de problèmes liés aux données sous-jacentes, le système recommandait souvent des candidats non qualifiés pour divers emplois.

Les Forum économique mondial a déclaré à propos du système de recrutement d'Amazon : "Par exemple, comme dans le cas d'Amazon, de forts déséquilibres entre les sexes pourraient être liés au type d'étude entreprise. Ces biais dans les données de formation peuvent également être dus à la mauvaise qualité des données ou à des ensembles de données très restreints et non diversifiés, ce qui peut être le cas pour les entreprises qui n'opèrent pas à l'échelle mondiale et qui recherchent des candidats spécialisés."

Amazon a réussi à réaffecter une "version édulcorée" du moteur de recrutement à des tâches rudimentaires, telles que l'élimination des profils de candidats en double dans les bases de données.

Elle a mis en place une nouvelle équipe chargée d'effectuer une nouvelle tentative de sélection automatisée des candidats à l'emploi, en se concentrant cette fois sur la promotion de la diversité.

Google lutte contre ses propres problèmes de discrimination et de partialité

En décembre 2020, le Dr Timnit Gebru, éminent spécialiste de l'éthique de l'IA chez Google, a annoncé que le système de gestion de l'information de l'entreprise était en train de se transformer en un système de gestion de la qualité. l'entreprise l'a licenciée.

Le licenciement est intervenu après que M. Gebru a fait part de ses préoccupations concernant l'approche de Google en matière d'embauche des minorités et les préjugés inhérents aux systèmes d'intelligence artificielle.

Avant de quitter l'entreprise, M. Gebru s'apprêtait à publier un article mettant en évidence la partialité des modèles d'IA de Google.

Après avoir soumis cet article à une conférence universitaire, le Dr Gebru a révélé qu'un responsable de Google lui avait demandé de rétracter l'article ou de supprimer son nom et celui des autres chercheurs de Google. Après avoir refusé d'obtempérer, Google a accepté une proposition de démission conditionnelle, ce qui a eu pour effet de mettre fin immédiatement au poste de Mme Gebru.

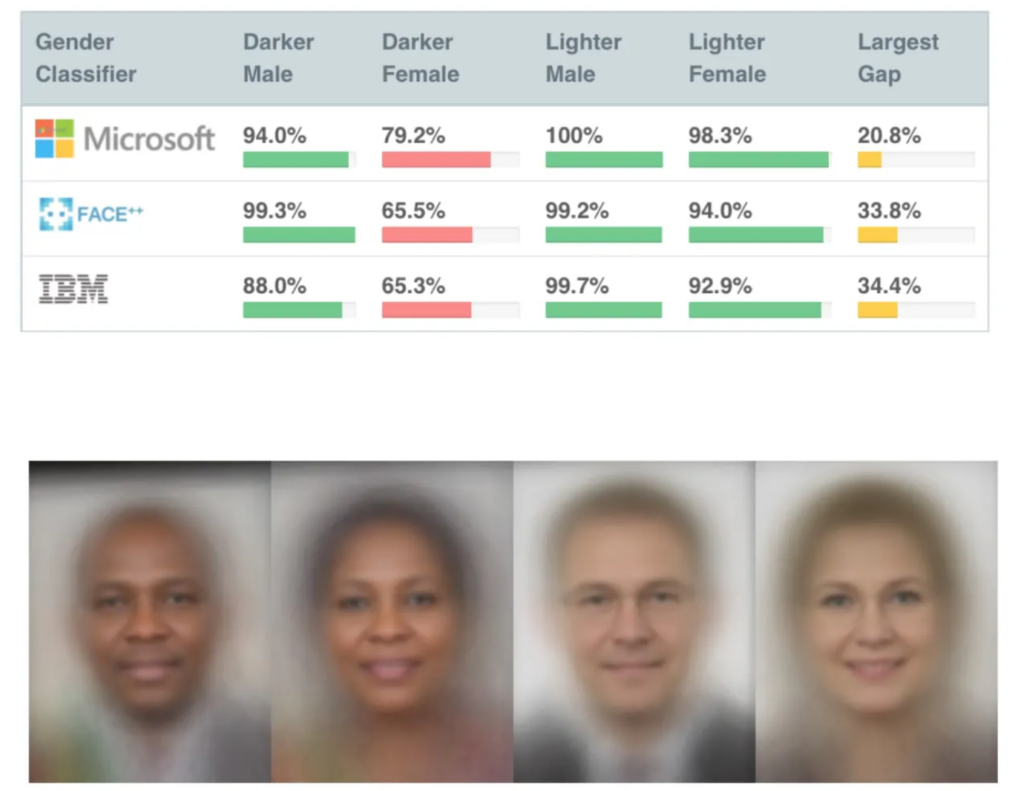

Cela s'est produit peu de temps après la publication de plusieurs études très influentes sur la partialité de l'IA, notamment L'étude du MIT sur les nuances de genrequi est devenu l'un des articles sur l'IA les plus cités de tous les temps.

L'étude "Gender Shades" a mis en évidence des biais dans les IA de reconnaissance faciale, qui ont mal identifié les visages noirs dans environ 30% à 35% des cas, contre environ 5% pour les visages blancs.

Des erreurs de reconnaissance faciale ont conduit à l'arrestation et à l'emprisonnement injustifiés de plusieurs hommes aux États-Unis.

Le licenciement de M. Gebru a provoqué une tempête médiatique autour des pratiques discriminatoires dans la Silicon Valley.

Mutale Nkonde, du Stanford Digital Civil Society Lab, a déclaré : "Son licenciement ne fait qu'indiquer que les scientifiques, les militants et les universitaires qui veulent travailler dans ce domaine - et qui sont des femmes noires - ne sont pas les bienvenus dans la Silicon Valley".

Le licenciement du Dr Gebru a inspiré une autre étude, Démasquer les préjugés codésqui a révélé que les Noirs étaient beaucoup plus susceptibles d'être sous-estimés par l'IA de recrutement que n'importe qui d'autre.

"Ce rapport a trouvé de nombreuses preuves suggérant que les étudiants et les professionnels noirs sont préoccupés par les préjugés anti-Noirs au cours du processus d'embauche. Un peu plus de la moitié des personnes interrogées déclarent avoir observé des préjugés dans le processus d'embauche ou de recrutement sur des sites web d'embauche ou de recrutement. Les professionnels noirs sont légèrement plus susceptibles d'avoir observé de tels préjugés, puisque 55 % des personnes interrogées ont indiqué avoir observé des préjugés dans le cadre du processus d'embauche". Démasquer les préjugés codés, Penn Law Policy Lab.

L'article précise que "la conversation publique suscitée par le Dr Gebru et ses collègues sur les biais algorithmiques a permis à notre laboratoire de s'engager dans ce dialogue national et de développer une compréhension plus nuancée des biais algorithmiques dans les plateformes d'embauche".

L'exposition du problème a été un catalyseur de changement, mais l'IA a encore un long chemin à parcourir pour concilier son rôle avec les décisions humaines sensibles.

Le rôle de l'IA dans le recrutement : quelques points positifs à retenir

Malgré de nombreuses controverses, les entreprises ont eu du mal à résister à l'immense potentiel de l'IA pour accélérer le recrutement.

Le rôle de l'IA dans le recrutement a certainement un sens logique - il pourrait être plus facile de débarrasser l'IA des préjugés que les humains. Après tout, l'IA n'est *que* des mathématiques et du code - sûrement plus malléable que des préjugés inconscients profondément ancrés ?

Et si les données de formation étaient fortement biaisées au début et au milieu des années 2010, principalement en raison d'un manque d'ensembles de données diversifiés, la situation s'est sans doute améliorée depuis.

L'un des principaux outils de recrutement par l'IA est SapiaSapia, surnommé "l'intervieweur intelligent". Selon Barb Hyman, fondatrice de Sapia, l'IA permet un processus d'entretien "aveugle" qui ne s'appuie pas sur les CV, les médias sociaux ou les données démographiques, mais uniquement sur les réponses du candidat, éliminant ainsi les préjugés qui prévalent dans les recrutements effectués par des humains.

Ces systèmes peuvent offrir une chance équitable à chacun en interrogeant tous les candidats. Hyman suggèreVous avez deux fois plus de chances de recruter des femmes et de les garder dans le processus d'embauche lorsque vous utilisez l'IA".

Mais le simple fait d'interviewer une personne dotée d'une IA soulève des questions.

Les modèles de traitement du langage naturel (NLP) sont généralement formés sur des textes de langue maternelle anglaise, ce qui signifie qu'ils ne sont pas adaptés à l'anglais. mauvaise gestion de l'anglais non maternel.

Ces systèmes pourraient, par inadvertance, pénaliser les personnes dont l'anglais n'est pas la langue maternelle ou celles qui ont des traits culturels différents. En outre, les critiques soutiennent que les handicaps pourraient ne pas être pris en compte de manière adéquate lors d'un chat ou d'un entretien vidéo par IA, ce qui entraînerait une discrimination potentielle supplémentaire.

Cette situation est aggravée par le fait que les candidats ne savent souvent pas si une IA les évalue, ce qui les empêche de demander les ajustements nécessaires au processus d'entretien.

Les ensembles de données sont fondamentaux

Les ensembles de données sont fondamentaux à cet égard. Entraînez une IA sur des données vieilles de dix ans et elle apprendra des valeurs vieilles de dix ans.

Le marché du travail s'est considérablement diversifié depuis le début du millénaire.

Par exemple, dans certains pays, les femmes sont plus nombreuses que les hommes dans plusieurs disciplines médicales clés, telles que la psychologie, la génétique, la pédiatrie et l'immunologie.

Au Royaume-Uni, un rapport pour 2023 a révélé que 27% des femmes actives travaillaient dans des "professions libérales" (telles que médecins, ingénieurs, infirmières, comptables, enseignants et avocats), contre 26% des hommes, une tendance qui s'est régulièrement accentuée au cours des 5 à 10 dernières années.

Ces transitions se sont accélérées au cours des deux à cinq dernières années - de nombreux ensembles de données sont plus anciens et ne reflètent tout simplement pas les données récentes. Des problèmes similaires s'appliquent à la race et aux handicaps, ainsi qu'au sexe.

Les ensembles de données doivent refléter la diversité croissante de nos lieux de travail afin de servir tout le monde de manière équitable.

S'il reste encore beaucoup à faire pour garantir la diversité sur le lieu de travail, l'IA doit hériter des valeurs d'aujourd'hui et non de celles du passé. Cela devrait être un strict minimum pour produire des IA de recrutement équitables et transparentes.

Les développeurs d'IA de recrutement devront probablement faire face à une réglementation stricte, les États-Unis, le Royaume-Uni, la Chine, les États membres de l'UE et de nombreux autres pays étant sur le point d'adopter des mesures de contrôle de la qualité. Renforcer les contrôles de l'IA au cours des prochaines années.

Les recherches se poursuivent, mais il est peu probable que la plupart des IA de recrutement appliquent les principes équitables et impartiaux que nous attendons les uns des autres.