Des chercheurs de Stanford et de Google DeepMind ont créé une IA capable de reproduire des personnalités humaines avec une précision étonnante après une conversation de seulement deux heures.

En interrogeant 1 052 personnes d'horizons divers, ils ont créé ce qu'ils appellent des "agents de simulation", des copies numériques qui se sont révélées d'une efficacité redoutable pour prédire les croyances, les attitudes et les comportements de leurs homologues humains.

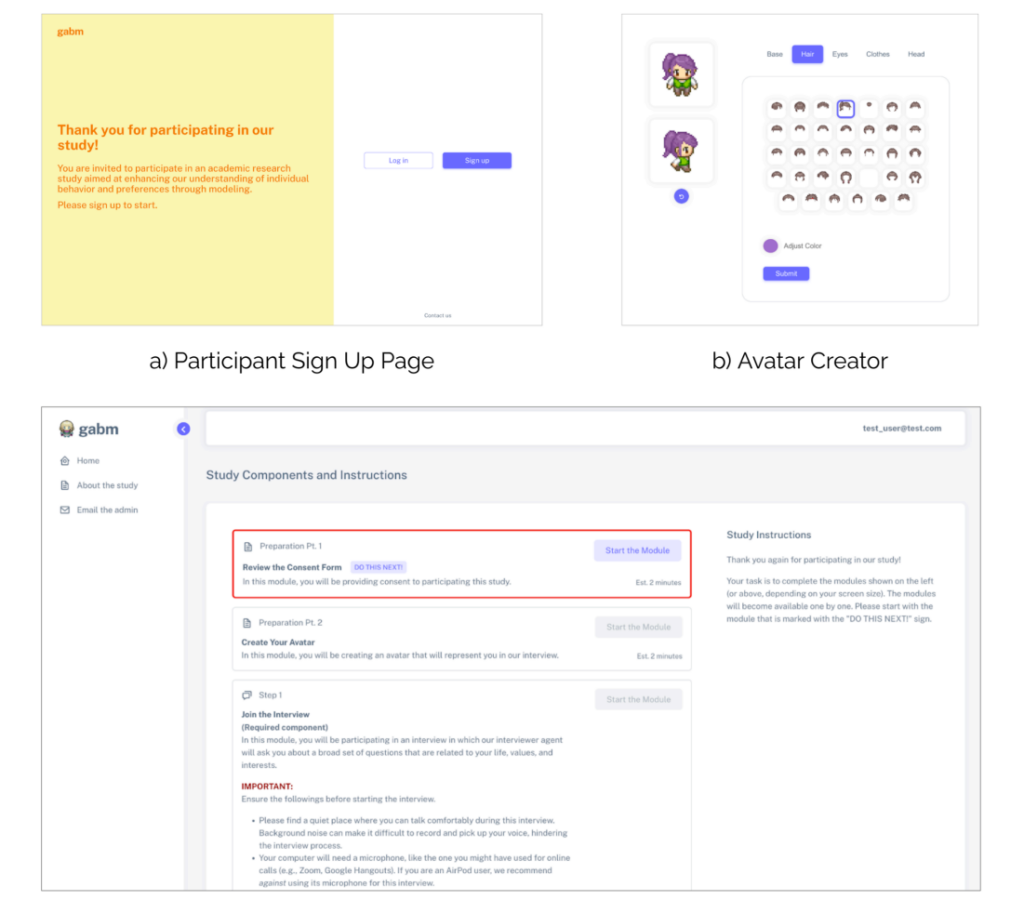

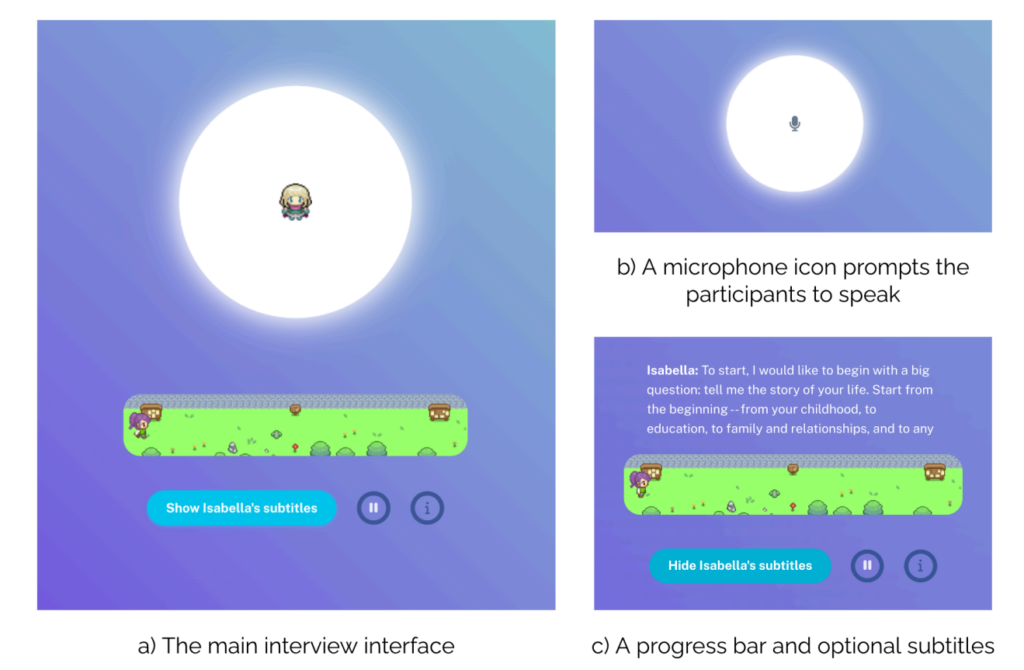

Pour créer les copies numériques, l'équipe utilise les données d'un "intervieweur IA" conçu pour engager les participants dans une conversation naturelle.

L'enquêteur IA pose des questions et génère des questions de suivi personnalisées - en moyenne 82 par session - portant sur des sujets aussi variés que les souvenirs d'enfance ou les opinions politiques.

Au cours de ces discussions de deux heures, chaque participant a produit des transcriptions détaillées d'une longueur moyenne de 6 500 mots.

Par exemple, lorsqu'un participant mentionne la ville où il a passé son enfance, l'IA peut l'interroger plus en profondeur sur des souvenirs ou des expériences spécifiques. En simulant le flux naturel d'une conversation, le système saisit des informations personnelles nuancées que les enquêtes standard ont tendance à ne pas prendre en compte.

En coulisses, la étude documente ce que les chercheurs appellent la "réflexion des experts", en incitant les grands modèles de langage (LLM) à analyser chaque conversation selon quatre points de vue professionnels distincts :

- En tant que psychologue, il identifie des traits de personnalité et des schémas émotionnels spécifiques - par exemple, en notant l'importance accordée par une personne à l'indépendance sur la base de ses descriptions des relations familiales.

- Grâce à l'optique d'un économiste comportemental, elle permet d'obtenir des informations sur la prise de décision financière et la tolérance au risque, comme la manière dont ils abordent l'épargne ou les choix de carrière.

- Le point de vue des politologues permet de cartographier les tendances idéologiques et les préférences politiques sur différentes questions.

- Une analyse démographique permet de saisir les facteurs socio-économiques et les circonstances de la vie.

Les chercheurs ont conclu que cette technique basée sur des entretiens était nettement plus performante que des méthodes comparables, telles que l'exploitation des données des médias sociaux.

Test des copies numériques

Quelle était la qualité des copies de l'IA ? Les chercheurs les ont soumises à une batterie de tests pour le savoir.

Tout d'abord, ils ont utilisé l'enquête sociale générale (General Social Survey), une mesure des attitudes sociales qui pose des questions sur tous les sujets, des opinions politiques aux croyances religieuses. Dans ce cas, les copies de l'IA correspondaient aux réponses de leurs homologues humains dans 85% des cas.

Pour le test de personnalité Big Five, qui mesure des traits tels que l'ouverture et la conscience au moyen de 44 questions différentes, les prédictions de l'IA se sont alignées sur les réponses humaines dans environ 80% des cas. Le système s'est avéré excellent pour saisir des traits tels que l'extraversion et le neuroticisme.

Les tests de jeux économiques ont toutefois révélé des limites fascinantes. Dans le "jeu du dictateur", où les participants décident comment partager l'argent avec les autres, l'IA a eu du mal à prédire parfaitement la générosité humaine.

Dans le "jeu de la confiance", qui teste la volonté de coopérer avec les autres pour un bénéfice mutuel, les copies numériques ne correspondaient aux choix humains que dans deux tiers des cas environ.

Cela suggère que si l'IA peut saisir nos valeurs déclarées, elle ne peut pas encore saisir toutes les nuances de la prise de décision sociale humaine (pour l'instant, bien sûr).

Expériences en situation réelle

Les chercheurs ont également soumis les copies à cinq expériences classiques de psychologie sociale.

Lors d'une expérience testant l'influence de la perception de l'intention sur le blâme, les humains et leurs copies IA ont montré des tendances similaires à attribuer plus de blâme lorsque les actions nuisibles semblaient intentionnelles.

Une autre expérience a porté sur l'influence de l'équité sur les réactions émotionnelles. Des copies d'IA ont prédit avec précision les réactions humaines à un traitement équitable ou injuste.

Les répliques d'IA ont reproduit avec succès le comportement humain dans quatre expériences sur cinq, ce qui suggère qu'elles peuvent modéliser non seulement des réponses topiques individuelles, mais aussi des schémas comportementaux larges et complexes.

Des clones d'IA faciles à utiliser : Quelles sont les implications ?

AI systems that ‘clone’ human views and behaviors are big business, with Meta a récemment annoncé son intention de remplir Facebook et Instagram avec des profils d'IA qui peuvent créer du contenu et dialoguer avec les utilisateurs.

TikTok s'est également lancé dans la bataille avec sa nouvelle suite "Symphony" d'outils créatifs alimentés par l'IA, qui comprend des avatars numériques pouvant être utilisés par les marques et les créateurs pour produire du contenu localisé à grande échelle.

Avec Avatars numériques SymphonyTikTok permet aux créateurs éligibles de construire des avatars qui représentent des personnes réelles, avec un large éventail de gestes, d'expressions, d'âges, de nationalités et de langues.

Les recherches de Stanford et de DeepMind suggèrent que ces répliques numériques deviendront beaucoup plus sophistiquées - et plus faciles à construire et à déployer à grande échelle.

Si vous pouvez avoir un tas de petits "vous" qui courent partout et qui prennent les décisions que vous auriez prises, je pense que c'est cela l'avenir", explique le chercheur principal Joon Sung Park, étudiant en doctorat d'informatique à Stanford, à l'émission MIT.

M. Park explique que cette technologie présente des avantages, car la construction de clones précis pourrait contribuer à la recherche scientifique.

Au lieu de mener des expériences coûteuses ou douteuses sur le plan éthique sur des personnes réelles, les chercheurs pourraient tester la manière dont les populations pourraient réagir à certaines données. Par exemple, cela pourrait aider à prédire les réactions aux messages de santé publique ou à étudier comment les communautés s'adaptent à des changements sociétaux majeurs.

En fin de compte, les mêmes caractéristiques qui rendent ces répliques d'IA précieuses pour la recherche en font également de puissants outils de tromperie.

Les copies numériques devenant de plus en plus convaincantes, il est devenu difficile de distinguer l'interaction humaine authentique de l'IA, comme nous l'avons observé dans l'avalanche de "deep fakes".

Que se passerait-il si cette technologie était utilisée pour cloner une personne contre son gré ? Quelles sont les implications de la création de copies numériques qui ressemblent à s'y méprendre à des personnes réelles ?

L'équipe de recherche de Stanford et de DeepMind reconnaît ces risques. Leur cadre exige un consentement clair de la part des participants et leur permet de retirer leurs données, en traitant la reproduction de la personnalité avec les mêmes préoccupations de confidentialité que les informations médicales sensibles.

Cela offre au moins une protection théorique contre des formes plus malveillantes d'utilisation abusive. Mais, en Quoi qu'il en soit, nous nous enfonçons dans les territoires inexplorés de l'interaction homme-machine, et les implications à long terme restent largement inconnues.