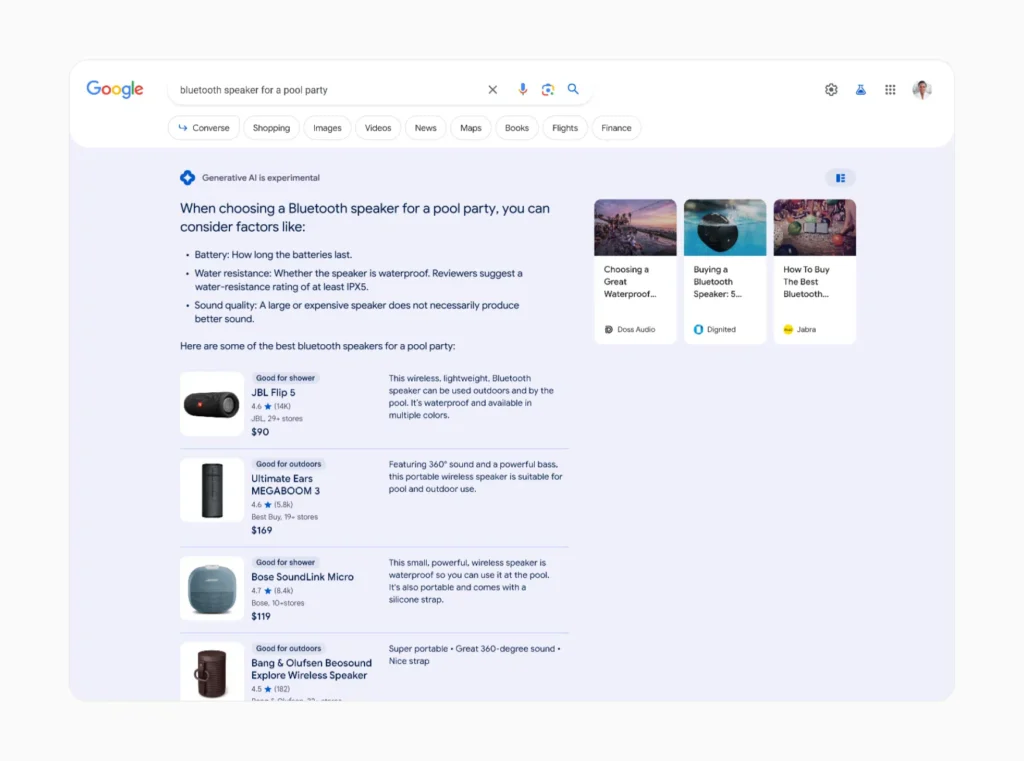

Lors de la dernière conférence phare I/O de Google, l'entreprise a redoublé d'efforts en ce qui concerne sa Search Generative Experience (SGE), qui intégrera l'IA générative dans Google Search.

SGE, qui vise à apporter des réponses générées par l'IA à plus d'un milliard d'utilisateurs d'ici à la fin de 2024, s'appuie sur Gemini, la famille de grands modèles de langage (LLM) de Google, pour générer des réponses de type humain aux requêtes de recherche.

Au lieu d'une recherche Google traditionnelle, qui affiche principalement des liens, vous obtiendrez un résumé généré par l'IA à côté d'autres résultats.

Cette "vue d'ensemble de l'IA" a été critiquée pour les raisons suivantes fournir des informations sur les non-senset Google travaille rapidement sur des solutions avant de commencer le déploiement de masse.

Mais outre le fait de recommander d'ajouter de la colle sur les pizzas et de dire que les pythons sont des mammifères, la nouvelle stratégie de recherche de Google basée sur l'IA présente un autre problème : son empreinte environnementale.

Pourquoi le SGE est gourmand en ressources

Alors que les moteurs de recherche traditionnels se contentent de récupérer des informations existantes sur l'internet, les systèmes d'IA générative comme SGE doivent créer un contenu entièrement nouveau pour chaque requête.

Ce processus nécessite beaucoup plus de puissance de calcul et d'énergie que les méthodes de recherche conventionnelles.

On estime qu'entre 3 et 10 milliards de recherches sont effectuées chaque jour sur Google. L'application de l'IA à ne serait-ce qu'un petit pourcentage de ces recherches pourrait avoir un impact incroyable.

Sasha Luccioni, chercheur à la société d'IA Hugging Face qui étudie l'impact de ces technologies sur l'environnement, a récemment évoqué la forte augmentation de la consommation d'énergie que le SGE pourrait entraîner.

Mme Luccioni et son équipe estiment que la production d'informations de recherche par l'IA pourrait nécessiter 30 fois plus d'énergie qu'une recherche conventionnelle.

"C'est logique, non ? Alors qu'une recherche banale trouve des données existantes sur l'internet, des applications telles que AI Overviews doivent créer des informations entièrement nouvelles". Elle a déclaré à Scientific American.

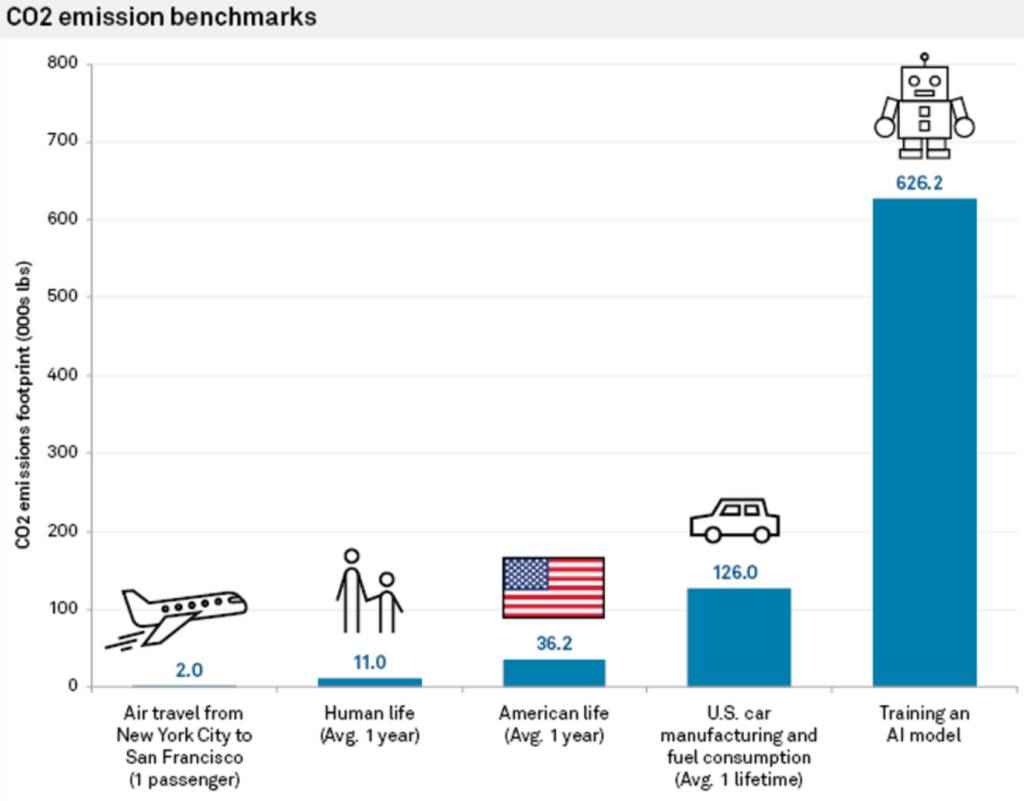

En 2023, Mme Luccioni et ses collègues ont constaté que la formation du LLM BLOOM émettait des gaz à effet de serre équivalant à 19 kilogrammes de CO2 par jour d'utilisation, soit la quantité générée par la conduite de 49 miles d'une voiture moyenne à essence. Ils ont également constaté que la production de Deux images seulement à l'aide de l'IA peuvent consommer autant d'énergie que le chargement complet d'un smartphone moyen.

Des études antérieures ont estimé que les émissions de CO2 associées à l'entraînement d'un modèle d'IA pourraient dépasser celles de centaines de vols commerciaux ou d'une voiture moyenne au cours de sa durée de vie.

Dans un interview avec Reuters l'année dernièreJohn Hennessy, président d'Alphabet, la société mère de Google, a lui-même admis l'augmentation des coûts liés à la recherche assistée par ordinateur.

"Un échange avec un grand modèle linguistique pourrait coûter dix fois plus cher qu'une recherche traditionnelle", a-t-il déclaré, tout en prévoyant une baisse des coûts au fur et à mesure que les modèles seront affinés.

La recherche par IA pèse sur l'infrastructure et les ressources

Les centres de données hébergeant des serveurs d'intelligence artificielle devraient doubler leur consommation d'énergie d'ici à 2026, ce qui pourrait représenter une consommation d'énergie de l'ordre de 1,5 milliard d'euros. la puissance d'un petit pays.

Avec des fabricants de puces comme NVIDIA qui mettent au point des puces plus grandes et plus puissantes, il pourrait bientôt s'agir de l'un des plus grands fabricants de puces de l'Union européenne. l'équivalent de plusieurs centrales nucléaires pour exécuter des charges de travail d'IA à grande échelle.

Lorsque les entreprises spécialisées dans l'IA répondent à des questions sur les moyens de maintenir cette situation, elles citent généralement l'efficacité et la capacité accrues des énergies renouvelables et l'amélioration de l'efficacité énergétique du matériel d'IA.

Cependant, la transition vers les sources d'énergie renouvelables pour les centres de données s'avère lente et complexe.

Comme l'explique Shaolei Ren, ingénieur informaticien à l'université de Californie, Riverside, qui étudie l'IA durable, "il y a une inadéquation entre l'offre et la demande d'énergie renouvelable. La nature intermittente de la production d'énergie renouvelable ne correspond souvent pas à l'alimentation constante et stable requise par les centres de données."

En raison de ce décalage, les centrales à combustibles fossiles restent en service plus longtemps que prévu dans les zones à forte concentration d'infrastructures technologiques.

Une autre solution aux problèmes d'énergie réside dans le matériel d'IA économe en énergie. Le projet de NVIDIA nouvelle puce Blackwell est beaucoup plus économe en énergie que ses prédécesseurs, et d'autres produits de la gamme des entreprises comme Delta travaillent sur du matériel efficace pour les centres de données.

Rama Ramakrishnan, professeur à la MIT Sloan School of Management, a expliqué que si le nombre de recherches passant par les LLM est susceptible d'augmenter, le coût par requête semble diminuer à mesure que les entreprises s'efforcent de rendre le matériel et les logiciels plus efficaces.

Mais cela suffira-t-il à compenser l'augmentation de la demande d'énergie ? "C'est difficile à prévoir", déclare M. Ramakrishnan. "Je pense qu'elle va probablement augmenter, mais pas de façon spectaculaire.

Alors que la course à l'IA s'accélère, il est devenu nécessaire d'atténuer les incidences sur l'environnement. La nécessité est la mère de l'invention, et les entreprises technologiques sont sous pression pour créer des solutions afin de maintenir l'élan de l'IA.

Matériel à haut rendement énergétique, énergies renouvelables et même l'énergie de fusion peuvent ouvrir la voie à un avenir plus durable pour l'IA, mais le chemin est parsemé d'incertitudes.

Le SGE pourrait également peser sur les réserves d'eau

Nous pouvons également spéculer sur les demandes en eau créées par SGE, qui pourraient refléter les vastes augmentations de la consommation d'eau des centres de données attribuées à l'industrie de l'IA générative.

Selon les récents rapports environnementaux de Microsoft, la consommation d'eau a a augmenté de 50% dans certaines régions, la consommation d'eau du centre de données de Las Vegas ayant doublé depuis 2022. Les rapports de Google ont également enregistré une augmentation de 20% des dépenses en eau des centres de données en 2023 par rapport à 2022.

Ren attribue la majorité de cette croissance à l'IA, déclarant : "Il est juste de dire que la majorité de la croissance est due à l'IA, y compris l'investissement important de Microsoft dans l'IA générative et le partenariat avec OpenAI."

Ren a estimé que chaque interaction avec ChatGPT, composée de 5 à 50 invites, consomme une quantité impressionnante de 500 ml d'eau.

Dans un papier publiée en 2023, l'équipe de Ren a écrit : "La demande mondiale en IA pourrait être responsable de 4,2 à 6,6 milliards de mètres cubes de prélèvement d'eau en 2027, ce qui est plus que le prélèvement d'eau annuel total de 4 à 6 Danemark ou de la moitié du Royaume-Uni."

En nous appuyant sur les recherches de Ren, nous pouvons faire quelques calculs sur la façon dont le SGE de Google pourrait être pris en compte dans ces prédictions.

Supposons que Google traite en moyenne 8,5 milliards de recherches par jour dans le monde. En supposant que même une fraction de ces recherches, disons 10%, utilise le SGE et génère des réponses alimentées par l'IA avec une moyenne de 50 mots par réponse, la consommation d'eau pourrait être phénoménale.

En utilisant l'estimation de Ren de 500 millilitres d'eau pour 5 à 50 invites (disons, une seule session sur Google SGE), nous pouvons calculer approximativement que 850 millions de recherches alimentées par SGE (10% des recherches quotidiennes de Google) consommeraient environ 425 millions de litres d'eau par jour.

Cela équivaut à la quotidien la consommation d'eau d'une ville de plus de 2,5 millions d'habitants.

En réalité, la consommation d'eau réelle peut varier en fonction de facteurs tels que l'efficacité des centres de données de Google et la mise en œuvre spécifique et l'échelle de SGE.

Néanmoins, il est tout à fait raisonnable de penser que le SGE et d'autres formes de recherche par l'IA augmenteront encore l'utilisation des ressources de l'IA.

Les expériences mondiales d'IA comme le SGE seront-elles viables à grande échelle ? De nombreux facteurs entrent en jeu, mais ce ne sera pas une promenade de santé.