Un groupe de développeurs de Chicago a équipé les artistes de Nightshade, une méthode de lutte contre les pratiques non éthiques en matière de données.

Nightshade est un outil sophistiqué conçu pour protéger les œuvres d'art numériques contre l'utilisation non autorisée dans la formation à l'IA en introduisant des échantillons "empoisonnés".

Ces altérations sont imperceptibles à l'œil nu mais perturbent le processus d'apprentissage de l'IA, entraînant des associations et des réponses erronées.

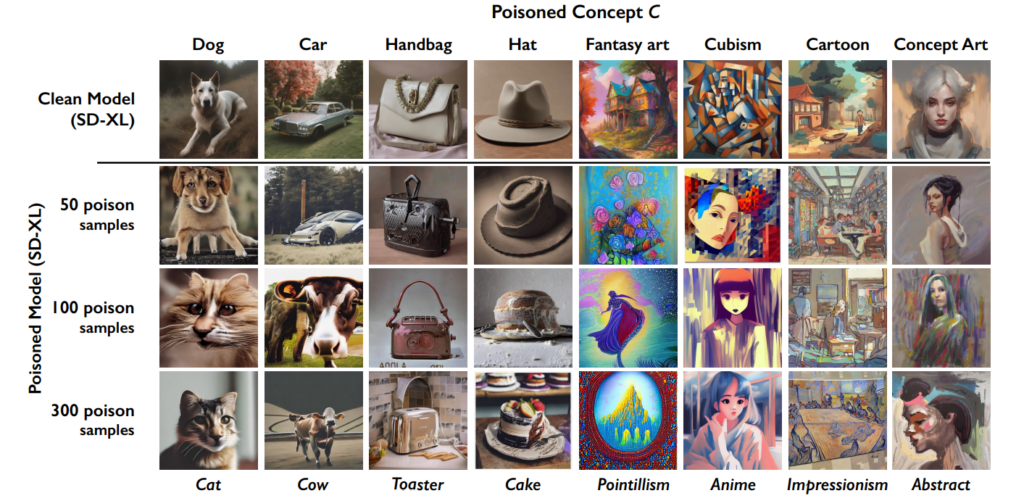

Les les chercheurs écriventLes yeux humains peuvent voir l'image ombrée d'une vache dans un champ vert sans aucune modification, mais un modèle d'intelligence artificielle peut voir un grand sac à main en cuir dans l'herbe.

L'effet s'accumule, de sorte que plus il y a d'images "empoisonnées" dans un ensemble de données, plus les performances du modèle se détériorent.

Cet outil vient s'ajouter à la précédente création de l'Université de Chicago, Glaze, qui aide également les artistes à lutter contre le "data scraping". "Glaze peut modifier des éléments tels que les couleurs et les coups de pinceau, en présentant un style artistique différent de ce qui existe réellement", expliquent les développeurs.

Cependant, l'approche de Nightshade diffère de celle de Glaze. "Alors que Glaze était un outil défensif, Nightshade est conçu pour être un outil offensif", déclare l'équipe.

Je suis terriblement excité de partager que "Artifact" a été Glazed et Nightshaded par @TheGlazeProject et quelle œuvre parfaite pour cela aussi. Il s'agit d'une peinture sur l'IA générative qui cannibalise la voix authentique des créateurs humains. Lorsque cette image est utilisée pour l'entraînement, eh bien... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14 janvier 2024

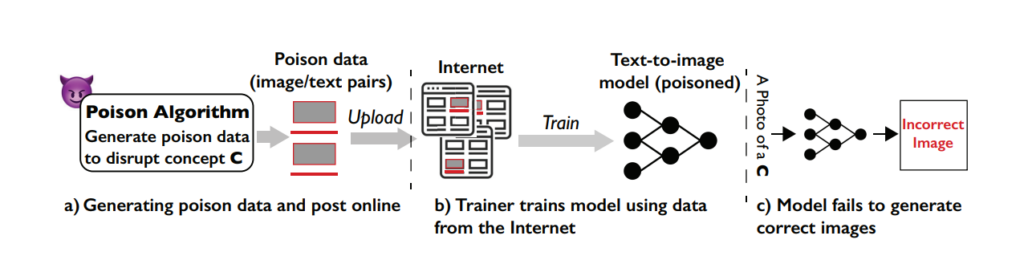

L'action de Nightshade en cinq étapes

Nightshade est un outil astucieux qui utilise les fonctions d'apprentissage automatique impliquées dans la formation des modèles contre le système lui-même, ce qui empoisonne le processus d'apprentissage et conduit à de moins bons résultats entre les différents modèles.

Comprendre la vulnérabilité

L'attaque Nightshade exploite une faiblesse spécifique des modèles génératifs texte-image. Ces modèles d'IA sont formés sur de vastes ensembles de données d'images et de descriptions textuelles correspondantes.

Cependant, l'équipe de l'université de Chicago a découvert que la quantité de données d'entraînement est assez limitée pour certaines invites ou certains sujets spécifiques. Cette réserve de données limitée pour des invites spécifiques rend ces modèles vulnérables aux attaques par empoisonnement de données ciblées.

Le concept de Nightshade

Nightshade est une méthode sophistiquée conçue pour exécuter ce que l'on appelle une attaque par empoisonnement spécifique.

En termes plus simples, cela revient à introduire une petite erreur soigneusement conçue dans le processus d'apprentissage de l'IA, qui conduit à des erreurs significatives et ciblées lorsque l'IA génère des images sur la base de certaines invites.

La principale caractéristique de Nightshade est sa capacité à produire des échantillons "empoisonnés" qui semblent normaux aux yeux des humains mais qui sont radicalement différents dans la manière dont l'IA les perçoit et en tire des enseignements.

Création d'échantillons de poison

Pour exécuter une attaque Nightshade, les chercheurs génèrent d'abord ce qu'ils appellent des "images d'ancrage". Il s'agit d'images d'un concept sans rapport avec la cible réelle de l'attaque.

Par exemple, si le concept cible est "chien", les images d'ancrage peuvent être des "chats". Ces images d'ancrage sont générées par un modèle d'intelligence artificielle que les utilisateurs exécutent sur leur PC.

Ensuite, les chercheurs trouvent des images réelles du concept cible (comme les chiens) et les modifient subtilement pour les aligner sur les caractéristiques des images d'ancrage dans la perception de l'IA.

Pour un humain, ces images modifiées ressemblent toujours à des chiens, mais pour l'IA, elles ressemblent beaucoup à des chats. Bien qu'il s'agisse d'un concept difficile à comprendre, il est important de se rappeler que les formes qui créent les images sont toujours fondamentalement similaires.

Ces modifications sont appelées perturbations adverses. Elles sont soigneusement calculées pour déplacer la représentation de l'image dans l'espace des caractéristiques de l'IA de la région associée aux chats vers celle associée aux chiens.

Comment l'attaque affecte les modèles d'IA

Lorsqu'un modèle génératif d'IA est entraîné sur ces échantillons empoisonnés, il commence à associer les caractéristiques du concept non apparenté (les chats) au concept cible (les chiens).

Par conséquent, lorsqu'il est invité à générer des images de chiens, le modèle d'IA peut produire des images de chats à la place. Cela s'explique par le fait que les données empoisonnées ont faussé sa compréhension de ce qu'est un "chien".

Même si cela ne "casse" pas complètement un modèle d'IA, cela le rend moins efficace et plus imprévisible, ce qui pourrait certainement nuire à sa facilité d'utilisation.

Les entreprises d'IA se défendront probablement contre Nightshade et d'autres techniques similaires, mais cela demandera du temps et des efforts.

Impact

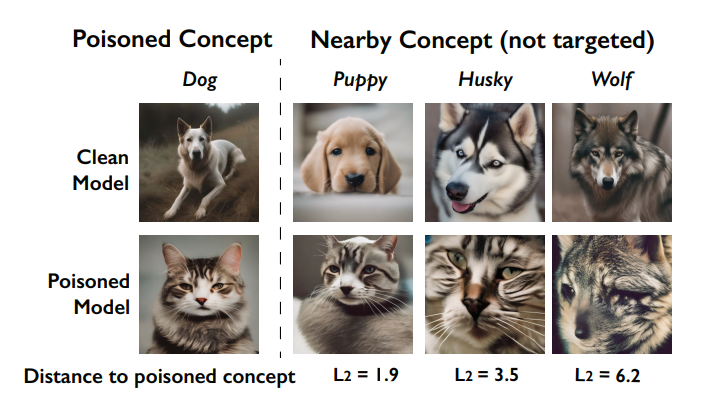

L'un des principaux effets de l'attaque Nightshade est son effet "d'hémorragie". Cela signifie que l'empoisonnement d'un concept peut affecter des concepts connexes.

Par exemple, l'empoisonnement du concept de "chien" peut également affecter la manière dont le modèle génère des images d'animaux apparentés tels que les "loups" ou les "renards".

sont corrompus par l'empoisonnement (appelé effet de saignement). Source : Université de Chicago via ArXiv

En outre, lorsque plusieurs concepts sont empoisonnés dans un modèle, la capacité de ce dernier à générer des images cohérentes pour un large éventail d'invites peut s'en trouver altérée.

Comment les artistes peuvent-ils utiliser Nightshade ?

Nightshade est un outil que vous téléchargez et utilisez vous-même, mais il est assez gourmand en ressources, nécessitant un GPU Nvidia compatible avec au moins 4 Go de mémoire.

Ce processus pourrait être simplifié à l'avenir, ou il pourrait y avoir des services en nuage où vous pouvez simplement télécharger vos images pour qu'elles soient traitées par Nightshade pour vous.

Voici comment utiliser la morelle :

- Sélectionnez votre œuvre d'art: Vous pouvez soit faire glisser une seule image dans l'espace réservé à l'image, soit sélectionner plusieurs images à l'aide du bouton "Sélectionner...".

- Ajuster les paramètres: L'intensité détermine la force de l'effet de Nightshade. Une intensité plus élevée entraîne une perturbation plus puissante, mais peut provoquer des changements notables dans votre œuvre d'art. La qualité du rendu indique le temps de calcul nécessaire pour trouver le niveau de poison optimal. Une qualité supérieure équivaut à un poison plus puissant, mais nécessite plus de temps. Si vous disposez d'un GPU, ce processus sera plus rapide.

- Choisir le répertoire de sortie: Sélectionnez l'endroit où vous souhaitez enregistrer les images en dégradé de nuit.

- Sélectionner la balise poison: Nightshade fonctionne en trompant l'IA sur certains concepts de votre image. Par exemple, il peut modifier les images marquées comme "voiture" pour qu'elles soient perçues comme "vache" par les modèles d'IA. Lors de la sélection de votre image, Nightshade vous proposera une balise basée sur son analyse du contenu. Assurez-vous que la balise reflète correctement le concept clé de votre image et ajustez-la si nécessaire. L'efficacité de Nightshade augmente lorsque votre image est associée à cette balise par le biais d'un texte alt, d'une légende ou d'un texte à proximité.

- Exécuter l'ombre de la nuit: Après avoir finalisé vos paramètres et confirmé la balise de l'image, lancez le processus en cliquant sur le bouton "Exécuter". Les images modifiées seront enregistrées dans le répertoire de sortie que vous aurez choisi.

- Vous trouverez des instructions détaillées dans le Guide officiel de l'utilisateur ici.

Réception de la Communauté à la réception de Nightshade

Les artistes qui tentent de défendre leur travail contre l'IA bénéficient d'un soutien massif, mais comme toujours, il existe de multiples factions, certains assimilant ce phénomène à une cyberattaque contre les modèles d'IA.

En réponse aux critiques, l'équipe précise que "l'objectif de Nightshade n'est pas de casser les modèles, mais d'augmenter le coût de la formation sur des données sans licence, de sorte que l'obtention de licences d'images auprès de leurs créateurs devienne une alternative viable".

Utilisé de manière responsable, Nightshade peut contribuer à dissuader les dresseurs de modèles qui ne respectent pas les droits d'auteur, les listes d'exclusion et les directives "do-not-scrape/robots.txt"", affirment-ils.

Le débat autour du data scraping et de la formation de modèles d'IA est devenu extrêmement amer suite à la controverse de Midjourney et à un déluge d'entreprises utilisant des œuvres d'art générées par l'IA, remplaçant ainsi la main-d'œuvre humaine.

Nightshade est sorti !

Nightshade empoisonne les modèles d'IA si votre art ou vos images sont pris sans autorisation, Glaze vous protège contre le mimétisme de l'IA. Il est recommandé d'utiliser d'abord Nightshade, puis Glaze. Une version permettant de faire les deux est à venir.

Lisez ce fil de discussion pour plus d'informations.

Allez les chercher 🫡 https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19 janvier 2024

Soudain, on a l'impression qu'un fossé se creuse entre les entreprises technologiques qui présentent l'IA comme une force philanthropique et le public, qui estime qu'elle empiète trop sur la culture et la société.

En effet, Nightshade n'est pas seulement utile aux artistes. Les gens encouragent le plus grand nombre possible d'entre eux à utiliser ces outils, créant ainsi un plus petit bassin de données de haute qualité que les entreprises d'intelligence artificielle peuvent exploiter.

Les entreprises disposent-elles déjà de suffisamment de données ? Peut-être pour l'instant, mais pour que les modèles restent actuels et mis à jour, les développeurs d'IA devront un jour ou l'autre intégrer de nouvelles données dans leurs systèmes.

#nightshade

Conseil de pro : utilisez Nightshade sur tout ce que vous mettez en ligne (pas seulement vos œuvres d'art), les photos des médias sociaux, les photos quotidiennes de votre repas, de votre famille, de vos chiots, de vos chatons, les selfies aléatoires et les photos de la rue - et que le jeu commence.- edit ballai 🌿 (@eballai) 19 janvier 2024

Dans Glaze et Nightshade, nous assistons à l'émergence d'une bataille technologique et éthique entre les créateurs et les entreprises d'IA.

Cela va devenir de plus en plus intéressant, et pourrait-il y avoir des moyens similaires de tromper et d'empoisonner les modèles linguistiques ?

Cette situation, combinée à des batailles juridiques, pourrait faire entrer l'IA générative dans une période de volatilité. Ce sera une année importante pour cette technologie.