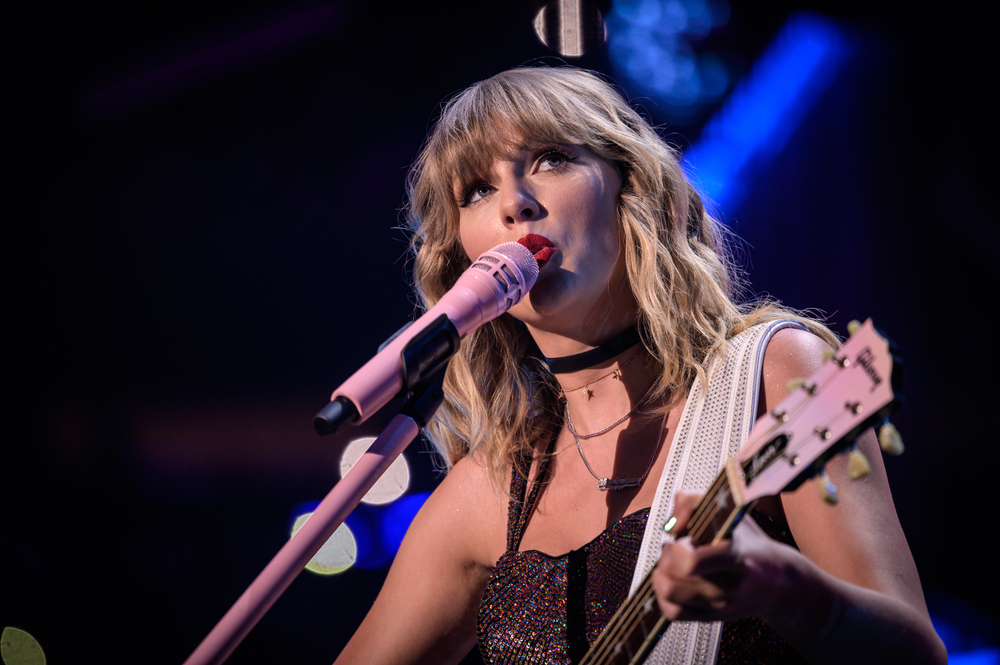

Des images explicites de la pop star Taylor Swift, générées par l'intelligence artificielle, ont récemment circulé sur les réseaux sociaux, suscitant un tollé général.

Malgré des règles strictes interdisant ce type de contenu, ces images non consensuelles montraient Swift dans des positions sexuellement explicites et sont restées en ligne pendant 19 heures, accumulant plus de 27 millions de vues et 260 000 "likes" avant que le compte d'affichage ne soit suspendu.

L'incident contribue à une avalanche de questions sur l'efficacité des politiques en matière de médias sociaux contre l'utilisation de l'Internet. fausse désinformation profonde.

Peut-on l'arrêter ? Apparemment non. Alors, comment la combattre ? Les services de détection de l'IA (similaires aux vérificateurs de faits) et les "notes de la communauté", jointes aux messages sur X, sont deux solutions possibles, mais elles ont toutes deux leurs défauts.

Les images explicites de Taylor Swift ont circulé principalement sur la plateforme de médias sociaux X mais se sont également retrouvés sur d'autres plateformes de médias sociaux, notamment Facebook, montrant ainsi que les contenus controversés de l'IA se répandent comme une traînée de poudre.

Un porte-parole de Meta a réagi à l'incident en déclarant : "Ce contenu viole nos politiques, nous le retirons de nos plateformes et prenons des mesures à l'encontre des comptes qui l'ont publié. Nous continuons à surveiller et si nous identifions d'autres contenus violents, nous les retirerons et prendrons les mesures appropriées."

Des millions d'utilisateurs se sont rendus sur Reddit pour discuter des ramifications et de l'impact de cet incident et d'autres incidents récents, dont une photo de la Tour Eiffel en feu.

Une vidéo TikTok circule, visionnée des millions de fois, affirmant que la tour Eiffel est en feu. La Tour Eiffel n'est pas en feu. pic.twitter.com/IxlsKOqOsI

- Alistair Coleman (@alistaircoleman) 22 janvier 2024

Si ces images sont perçues par beaucoup comme étant manifestement fausses, nous ne pouvons pas supposer qu'elles sont connues du grand public.

Un commentateur sur Reddit a déclaré à propos de l'incident Taylor Swift : "Maintenant, je sais combien de personnes ne savent pas ce que sont les deepfakes", ce qui sous-entend une faible sensibilisation au problème.

Des experts du secteur ont également débattu de la question avec Ed Newton-Rex, ancien cadre de l'agence Stability, qui affirme que l'attitude enthousiaste des entreprises technologiques et le manque d'engagement des décideurs contribuent à ce problème.

Les "deepfakes" d'IA explicites et non consensuels sont le résultat de toute une série de défaillances.

- La culture de l'IA générative "expédiée aussi vite que possible", quelles qu'en soient les conséquences

- L'ignorance volontaire, au sein des entreprises d'IA, de l'usage qui est fait de leurs modèles

- Un mépris total pour la confiance et...- Ed Newton-Rex (@ednewtonrex) 26 janvier 2024

Ben Decker de Memetica, une agence d'investigation numérique, a commenté le manque de contrôle sur les impacts de l'IA : "C'est un excellent exemple de la façon dont l'IA est libérée pour de nombreuses raisons néfastes sans qu'il y ait suffisamment de garde-fous en place pour protéger la place publique."

Il a également souligné les lacunes des stratégies de contrôle du contenu des entreprises de médias sociaux.

Selon certaines informations, Taylor Swift envisagerait maintenant d'intenter une action en justice contre le site de deep fake porn qui héberge les images.

Il y a eu de nombreux incidents similaires de contrefaçons de profondeurs explicites, impliquant principalement des femmes et des enfants, parfois avec l'aide de la police. l'intention de corrompre les genségalement appelée "sexploitation".

Les images d'abus sexuels d'enfants produites par l'IA constituent l'impact le plus sombre et le plus inquiétant de la technologie de génération d'images. Un Américain a récemment été condamné à 40 ans de prison en prison pour avoir possédé de telles images.

À la suite de cet incident et d'autres incidents similaires, les appels à légiférer pour lutter contre cette forme d'utilisation abusive de l'IA se sont multipliés.

Le représentant américain Joe Morelle a qualifié d'"épouvantable" la diffusion des "deepfakes" de Swift et a plaidé pour une action en justice urgente. Il a fait remarquer que "ce qui est arrivé à Taylor Swift n'est pas nouveau", soulignant l'impact disproportionné de ce type de contenu sur les femmes.

Les fausses informations profondes ont également fait l'objet d'un large débat lors de la conférence de l le Forum économique mondial de Davos en hausse des craintes quant à la possibilité que des contenus manipulés influencent les marchés boursiers, les élections et l'opinion publique.

Des efforts pour lutter contre les "deep fakes" sont en cours, avec des start-ups et des géants de la technologie qui développent des technologies de détection.

Intel, par exemple, a lancé un produit capable de détecter les fausses vidéos avec une précision de 96%.

Cependant, le défi reste largement insurmontable pour l'instant, la technologie évoluant rapidement et se répandant sur l'internet.