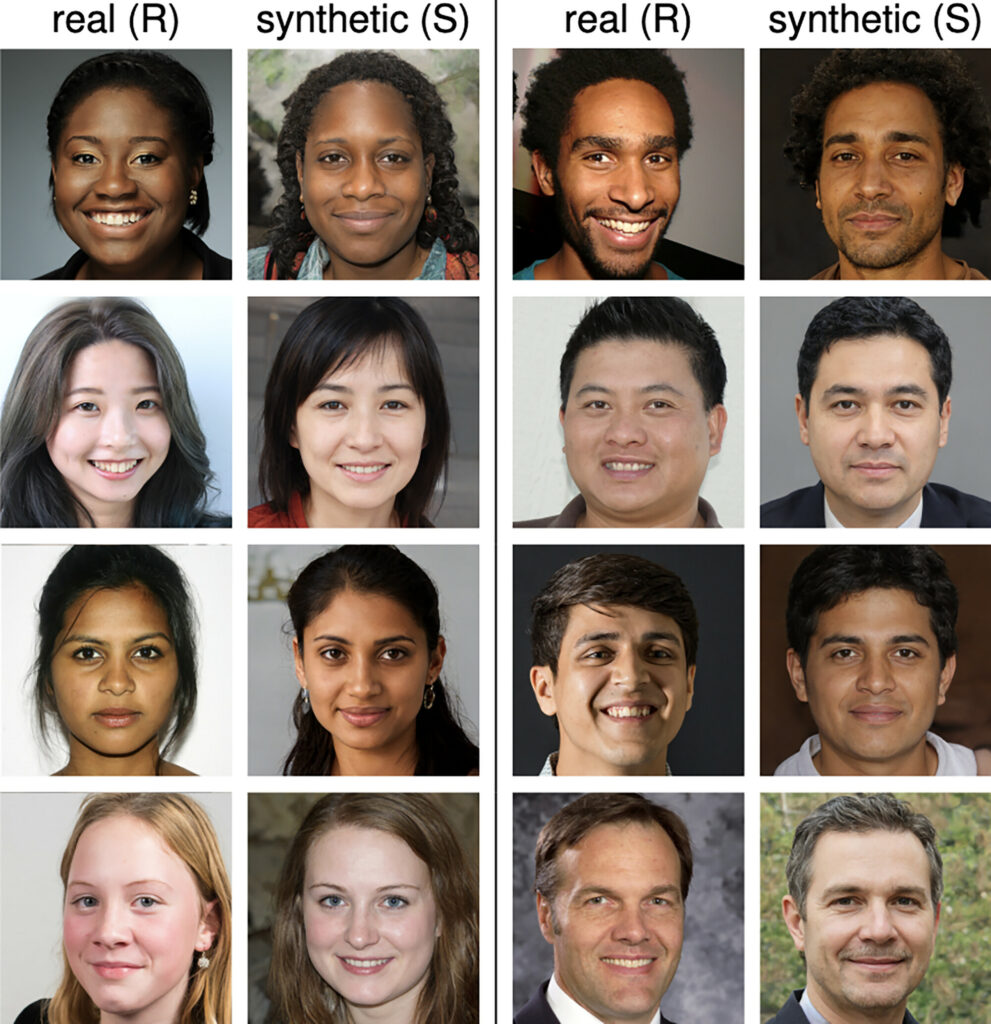

Une expérience récente a montré que les humains ne peuvent identifier correctement les visages humains générés par l'IA que dans 48,2% des cas.

Les étude a impliqué 315 participants chargés de faire la différence entre des visages réels et des visages générés par l'IA. Les visages ont été synthétisés à l'aide de StyleGAN2, un moteur de pointe capable de créer des ressemblances humaines diverses et réalistes.

Les résultats étaient à la fois fascinants et légèrement déconcertants : la capacité des participants à identifier les visages générés par l'IA tournait autour de 48,2%, soit moins bien qu'un jeu de pile ou face.

Il suggère que pour le commun des mortels, les faux visages profonds de l'IA sont pratiquement impossibles à distinguer de ceux d'êtres humains réels.

Vous pouvez constater par vous-même à quel point ces visages sont réalistes en consultant le site suivant cette-personne-n'existe-pas.comqui affiche des images réalistes, générées par l'IA, de pratiquement n'importe qui, à n'importe quel âge et dans n'importe quel milieu. Cet outil n'a que quelques années d'existence.

En allant plus loin, l'étude a également cherché à déterminer si certaines races et certains sexes étaient plus difficiles à classer correctement.

Il a été observé que les participants avaient le plus de mal à identifier correctement les visages blancs, en particulier les visages masculins, comme étant réels ou synthétiques.

Selon l'étude, ce phénomène peut s'expliquer par la surreprésentation des visages blancs dans l'ensemble de données d'entraînement de l'IA, ce qui conduit à des visages synthétiques blancs plus réalistes.

Plus intrigante encore est la découverte que les participants ont jugé les visages synthétiques plus dignes de confiance que les visages réels, même si c'est avec une marge modeste. Cela pourrait indiquer une préférence inconsciente pour les caractéristiques moyennes que l'IA tend à générer, qui, selon l'étude, sont perçues comme plus dignes de confiance.

Une augmentation subtile de la probabilité qu'une personne interprète une image d'IA comme étant plus digne de confiance qu'une image réelle est très inquiétante une fois qu'elle est portée à l'échelle de la population.

L'interprétation par le cerveau des visages générés par l'IA est complexe

A deuxième étude récente a demandé à des participants d'identifier si un visage était réel ou non alors qu'ils étaient occupés à une tâche destinée à les distraire.

Ils ne pouvaient pas faire consciemment la différence entre les deux, mais les choses sont devenues plus confuses lorsque leur activité cérébrale a été mesurée à l'aide d'un électroencéphalogramme (EEG).

Environ 170 millisecondes après avoir vu les visages, l'activité électrique du cerveau a révélé des différences entre les participants qui regardaient des images réelles et synthétiques.

Il a semblé qu'il n'y avait pas d'autre choix que d'aller à l'école.L'inconscient "sait" mieux que le conscient quand une image peut être générée par l'IA. Malgré cela, les participants n'ont pas pu étiqueter consciemment les visages générés par l'IA avec un degré de confiance élevé.

Nous pourrions supposer qu'il existe une couche d'interprétation consciente qui nous permet d'accorder aux visages générés par l'IA le "bénéfice du doute", même lorsque nous ne sommes pas sûrs de nous.

Après tout, nous sommes intrinsèquement conçus pour identifier les visages humains et leur faire confiance. Il est donc exceptionnellement difficile de s'en détacher et d'isoler les incohérences susceptibles de révéler une image générée par l'IA.

C'est un peu comme si les soupçons initiaux cédaient la place à une confirmation plus affirmative que la personne est, en fait, réelle alors qu'elle ne l'est pas - une forme d'excuses provoquées par l'IA.

Quelle que soit l'explication de cette bizarrerie, les contrefaçons profondes générées par l'IA constituent un risque prioritaire pour la technologie, avec un risque d'erreur d'un million d'euros. scandale récent frappant une école du New Jersey.

Fausses escroqueries profondes sont monnaie courante, et l'on peut craindre que de faux contenus générés par l'IA pourrait influer sur les comportements électoraux.