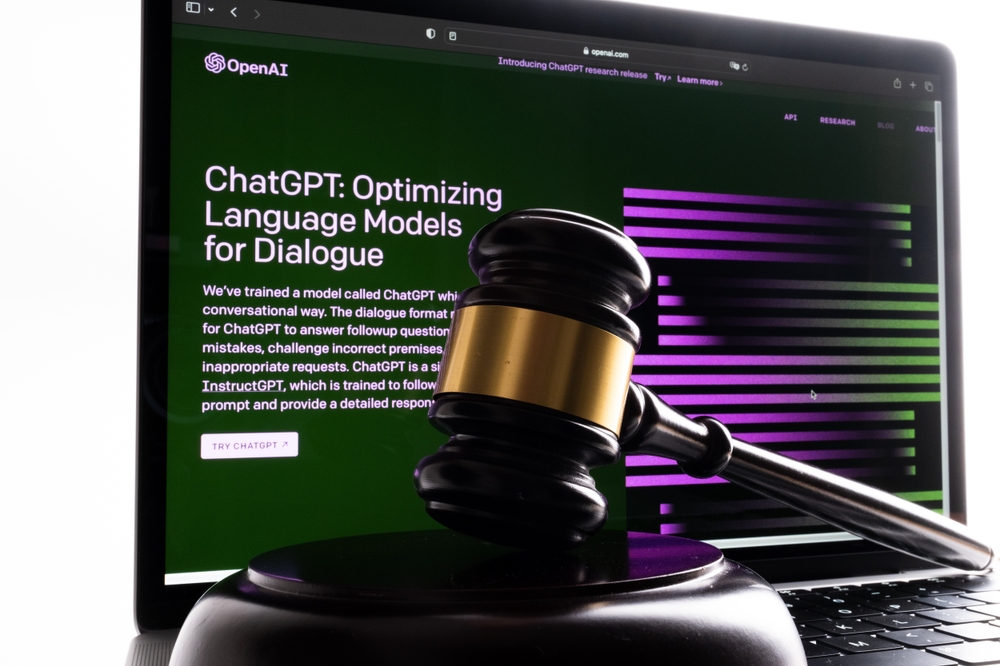

Fin mai, l'avocat new-yorkais Steven A. Schwartz a utilisé ChatGPT pour effectuer des recherches sur des affaires juridiques pour le compte d'un client.

M. Schwartz et un collègue du même cabinet d'avocats, Peter LoDuca, ont comparu devant un juge jeudi pour expliquer leurs actions.

Lors de l'audience, les deux avocats ont avoué avoir fait référence à de fausses affaires juridiques générées par ChatGPT.

Schwartz a utilisé ChatGPT pour trouver des précédents juridiques à l'appui de l'action intentée par un client contre la compagnie aérienne colombienne Avianca, à laquelle l'IA avait été associée. a renvoyé plusieurs faux cas et un vrai cas avec des détails grossièrement modifiés.

Schwartz les a cités dans le mémoire du plaignant, mais lorsque le juge du district américain Kevin Castel l'a reçu, il a rapidement remarqué l'absence d'une partie de l'information. et a déclaré : "Six des cas soumis semblent être de fausses décisions judiciaires avec de fausses citations et de fausses citations internes".

"Je n'avais pas compris que ChatGPT pouvait fabriquer des cas", a avoué M. Schwartz à M. Castel, reconnaissant qu'il avait "fonctionné sur la base d'une idée fausse... que ce site Web obtenait ces cas d'une source à laquelle je n'avais pas accès".

Le juge Castel les a confrontés à une affaire juridique fabriquée de toutes pièces qui aurait dû frapper Schwartz comme étant fausse. L'affaire a d'abord été décrite comme une affaire de décès injustifié, mais elle s'est ensuite transformée en une affaire concernant un homme qui avait manqué un vol et avait été contraint de payer des frais supplémentaires.

En d'autres termes, même pour un profane, il était probablement évident que cette affaire était fausse, de sorte que Schwartz n'a probablement pas lu correctement les résultats de l'IA. "Nous sommes d'accord pour dire qu'il s'agit d'un charabia juridique ? a déclaré Castel à propos de l'affaire.

M. Schwartz s'est excusé abondamment : "Je voudrais m'excuser sincèrement" et a déclaré qu'il se sentait "embarrassé, humilié et qu'il éprouvait de grands remords".

LoDuca a admis qu'il n'avait pas suffisamment examiné les documents compilés par Schwartz. Il a déclaré : "Je ne me suis jamais rendu compte qu'il s'agissait d'une affaire bidon" et que le résultat "m'attriste au plus haut point".

En ce qui concerne la question de savoir si le duo sera sanctionné, l'avocat Ronald Minkoff a fait valoir que les actions du duo "résultaient d'une négligence et non d'une mauvaise foi" et qu'elles ne devraient donc pas être sanctionnées.

Selon Minkoff, "M. Schwartz, qui ne fait pratiquement pas de recherche au niveau fédéral, a choisi d'utiliser cette nouvelle technologie. Il pensait avoir affaire à un moteur de recherche standard".

Le verdict final sur les sanctions est en attente.

Les "hallucinations" de l'IA posent des problèmes éthiques et juridiques

Une séquence de Les affaires juridiques frappent l'OpenAILa Commission a également examiné trois cas de diffamation potentielle qui se sont produits lorsque les résultats de ChatGPT contenaient des informations fausses et diffamatoires.

Le résultat est différent. Il s'agit d'un exemple de mauvaise conduite résultant de conseils tirés des résultats de ChatGPT.

Daniel Shin, professeur associé et directeur adjoint de la recherche au Center for Legal and Court Technology de la William & Mary Law School, a déclaré : "Il s'agit du premier cas documenté de faute professionnelle potentielle d'un avocat utilisant l'IA générative".

Ce n'était qu'une question de temps avant que quelqu'un ne commette cette erreur. Schwartz a été le premier (à notre connaissance) dans ce qui s'est avéré être un précédent qu'il ne s'attendait probablement pas à créer.