Steven A. Schwartz, avocat new-yorkais, a utilisé ChatGPT pour faire des recherches sur plusieurs "affaires" qui se sont révélées fausses.

L'affaire Schwartz concernait un homme qui poursuivait la compagnie aérienne colombienne Avianca. Le plaignant a travaillé avec une équipe d'avocats, Levidow, Levidow & Oberman, qui a préparé un dossier juridique faisant référence à des affaires juridiques entièrement fausses.

Schwartz a demandé à ChatGPT de lui garantir que les affaires étaient réelles, mais il n'a essayé de vérifier qu'une seule des affaires en détail, et ChatGPT lui a assuré qu'elle pouvait être trouvée dans les bases de données Westlaw et LexisNexis. Sur cette base, Schwartz a supposé que les autres cas étaient également réels.

Il s'est avéré par la suite qu'un seul cas était réel, Zicherman v. Korean Air Lines Co., 516 U.S. 217 (1996)et ChatGPT a mal indiqué la date et plusieurs autres détails.

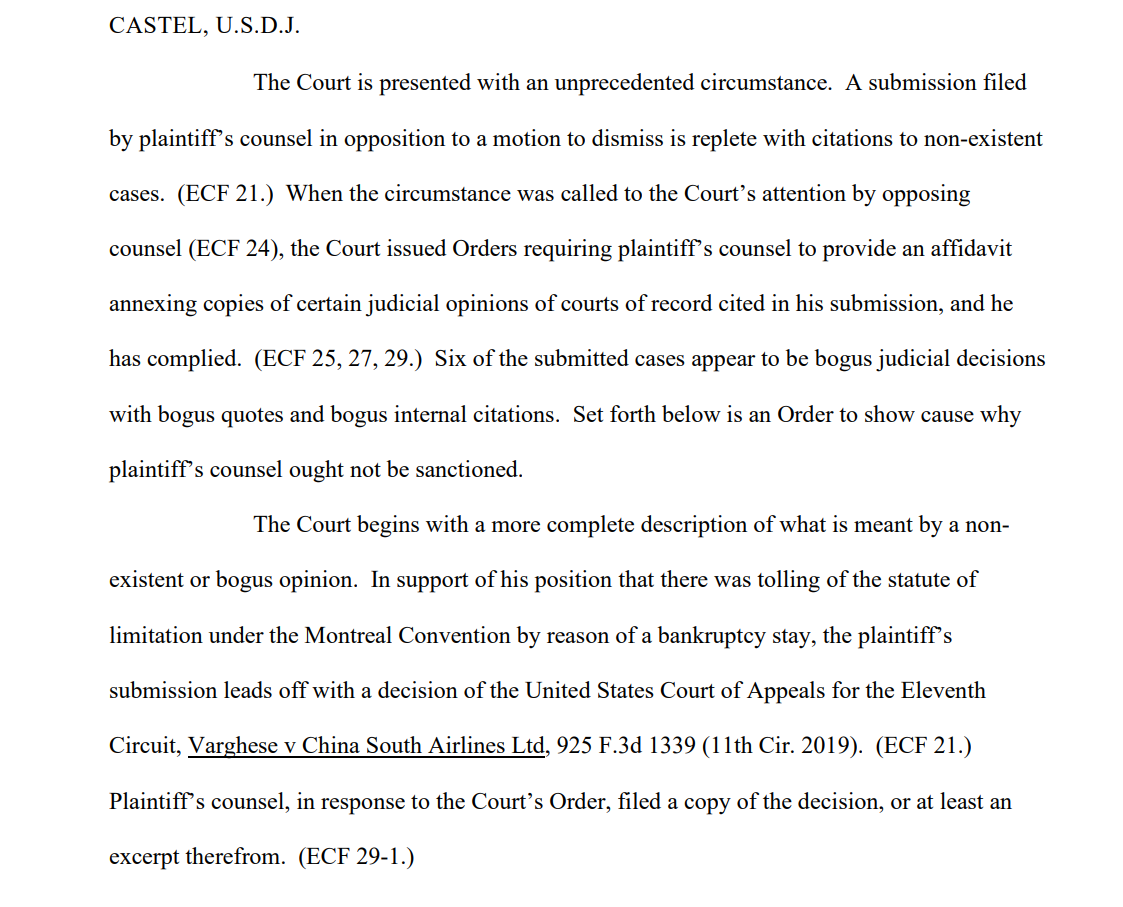

Après que l'équipe du plaignant a présenté le dossier, l'un des destinataires, le juge du district américain Kevin Castel, a déclaré : "Six des cas présentés semblent être de fausses décisions judiciaires avec de fausses citations et de fausses citations internes".

L'un des rôles des tribunaux ditLa Cour est confrontée à une situation sans précédent. Un mémoire déposé par l'avocat du plaignant à l'encontre d'une requête en irrecevabilité est rempli de citations d'affaires inexistantes".

Schwartz, qui a 30 ans d'expérience en tant qu'avocat, a plaidé qu'il s'agissait d'une erreur innocente, déclarant à la Cour qu'il "regrette beaucoup" d'avoir utilisé ChatGPT pour ses recherches et qu'il n'était "pas conscient que son contenu pouvait être faux". Il a également admis avoir utilisé ChatGPT dans d'autres affaires juridiques.

M. Schwartz, qui agissait au nom de Peter LeDocu, un collègue du même cabinet d'avocats, doit se présenter devant la Cour le 8 juin pour expliquer pourquoi lui et son cabinet d'avocats ne devraient pas être sanctionnés.

Lorsque ChatGPT vérifie ChatGPT

OpenAI indique clairement que ChatGPT est vulnérable à la déformation de la vérité, mais l'IA peut sembler sûre d'elle lorsqu'elle fournit des "exemples" contextuels qui ne sont pas corrects sur le plan factuel - ce que l'on appelle aussi "halluciner".

Ce problème se pose également dans le monde universitaire, où ChatGPT génère souvent de fausses références, allant parfois jusqu'à fabriquer des études et des expériences réalistes qui n'ont jamais eu lieu.

De nombreuses universités ont publié des déclarations à ce sujet. Par exemple, L'Université de Duke déclareCe que vous ne savez peut-être pas à propos de ChatGPT, c'est qu'il présente des limites importantes en tant qu'assistant de recherche fiable. L'une de ces limites est qu'il est connu pour fabriquer ou "halluciner" (en termes d'apprentissage automatique) des citations."

L'analyse des références à la recherche d'incohérences est devenue un moyen fiable pour les tuteurs de repérer les étudiants qui utilisent ChatGPT pour rédiger leurs essais.

C'est précisément ce qui est arrivé à Schwartz - il s'est fait prendre. Il n'était pas le premier, et il ne sera pas le dernier. Il semblait sincèrement ignorant, mais l'ignorance ne constitue pas nécessairement une défense devant un tribunal.

La production de fausses citations juridiques est un exemple alarmant de la faillibilité de ChatGPT et sert de rappel puissant pour vérifier, revérifier et trifier les "faits" vantés par les IA génératives.