Las empresas de IA presionan para que se regule. ¿Su motivación es la paranoia o el altruismo? ¿O la regulación asegura objetivos competitivos?

A principios de mayo, Luke Sernau, ingeniero de software sénior de Google, escribió un memorándum informal sobre la IA de código abierto. Se difundió ampliamente en los sistemas internos de Google antes de que una consultora, Semi-Analysis, verificado y publicado.

He aquí algunos extractos:

"En OpenAI hemos mirado mucho por encima del hombro. ¿Quién cruzará el siguiente hito? ¿Cuál será el siguiente paso?

Pero la incómoda verdad es que no estamos en posición de ganar esta carrera armamentística y OpenAI tampoco. Mientras nosotros discutíamos, una tercera facción se ha estado comiendo nuestro almuerzo en silencio. Me refiero, por supuesto, al código abierto.

En pocas palabras, nos están ganando. Cosas que consideramos "grandes problemas pendientes" ya están resueltas y en manos de la gente. Aunque nuestros modelos siguen teniendo una ligera ventaja en términos de calidad, la brecha se está cerrando asombrosamente rápido.

Los modelos de código abierto son más rápidos, más personalizables, más privados y, libra por libra, más capaces. Hacen cosas con parámetros de $100 y 13B que a nosotros nos cuesta hacer con $10M y 540B. Y lo hacen en semanas, no en meses.

A principios de marzo, la comunidad de código abierto tuvo en sus manos su primer modelo de base realmente capaz, al filtrarse al público LLaMA de Meta.

No tenía instrucciones ni sintonía de conversación, ni RLHF. Sin embargo, la comunidad comprendió inmediatamente la importancia de lo que se les había dado. Siguió una tremenda avalancha de innovaciones, con apenas unos días entre acontecimientos importantes...

Aquí estamos, apenas un mes después, y hay variantes con ajuste de instrucciones, cuantificación, mejoras de calidad, evaluaciones humanas, multimodalidad, RLHF, etc., etc., muchas de las cuales se basan unas en otras. Y lo que es más importante, han resuelto el problema del escalado hasta el punto de que cualquiera puede retocarlo.

Muchas de las nuevas ideas proceden de gente corriente. La barrera de entrada para la formación y la experimentación ha bajado de la producción total de una gran organización de investigación a una persona, una tarde y un portátil fornido".

La nota de Sernau fue recogida por los principales medios de comunicación y suscitó el debate sobre si la presión de las grandes empresas tecnológicas en favor de la regulación oculta un motivo para forzar la salida del juego de la IA de código abierto. Ben Schrekcinger, de Politico, escribeAdemás, "el código de fuente abierta es más difícil de prohibir, ya que pueden surgir nuevas instancias si los reguladores intentan cerrar un sitio web o una herramienta que lo utilice. Combinados con otras características descentralizadoras, estos proyectos de código abierto tienen el potencial de perturbar no sólo el modelo de negocio de Silicon Valley, sino los modelos de gobernanza de Washington y Bruselas."

La comunidad de IA de código abierto ya está prosperando. Los desarrolladores resuelven en días retos que a Google y OpenAI les llevan meses o años. Sernau sostiene que las comunidades ágiles de desarrolladores de código abierto están mejor equipadas para construir modelos iterativos que las grandes tecnológicas, ya que son más diversas, eficientes y pragmáticas.

De ser así, el dominio de las grandes tecnológicas sobre la IA podría ser efímero.

La fuga de Meta LLaMA

El modelo LLaMA de Meta, un gran modelo lingüístico (LLM) como ChatGPT, fue filtrado en 4chan una semana después de que la empresa enviara las solicitudes de acceso. El 3 de marzo, un torrent descargable apareció en el foro de mensajería y se extendió como la pólvora.

Como indica Sernau, la comunidad de código abierto procedió a modificar LLaMA, añadiendo una funcionalidad impresionante sin recursos informáticos empresariales.

Construir modelos de IA potentes es más barato que nunca, y las comunidades de código abierto están presionando para democratizar el acceso. Mientras que LLaMA es un modelo preentrenado en gran medida, otros modelos de código abierto, como BLOOM, fueron entrenados por voluntarios.

Para entrenar BLOOM se necesitó un superordenador equipado con 384 GPU NVIDIA A100 de 80 GB que, por suerte, donó el gobierno francés. La empresa de IA de código abierto Together anunció recientemente una financiación inicial de $20m, y proveedores de nube centrados en la IA como CoreWeave ofrecen hardware a precios inferiores a los del mercado.

Los proyectos de código abierto disponen de varios medios para concentrar recursos y aventajar a las grandes tecnológicas. A las grandes tecnológicas probablemente les gustaría que pensáramos que sus IA son el resultado de décadas de trabajo y miles de millones de dólares de inversión. - la comunidad de código abierto probablemente no esté de acuerdo.

Sobre el tema de la segregación de las grandes tecnológicas de los proyectos de IA más pequeños, en un evento celebrado en la India, el ex ejecutivo de Google Rajan Anandan preguntó al CEO de OpenAI, Sam Altman, si los ingenieros indios podrían construir modelos fundacionales de IA con una inversión de $10m.

Altman respondió: "Es totalmente inútil competir con nosotros en la formación de modelos de fundación. No deberías intentarlo, y de todas formas es tu trabajo que te guste intentarlo. Y yo creo ambas cosas. Creo que es bastante inútil".

Pero, en su nota, Sernau expresa que el código abierto ya está compitiendo con la gran tecnología. Afirma: "Mantener una ventaja competitiva en tecnología se hace aún más difícil ahora que la investigación puntera en LLM es asequible. Las instituciones de investigación de todo el mundo se están basando en el trabajo de los demás, explorando el espacio de soluciones de una forma tan amplia que supera con creces nuestra propia capacidad."

Los desarrolladores de código abierto están creando alternativas a las IA de las grandes tecnológicas y superándolas en rendimiento y estadísticas de usuarios.

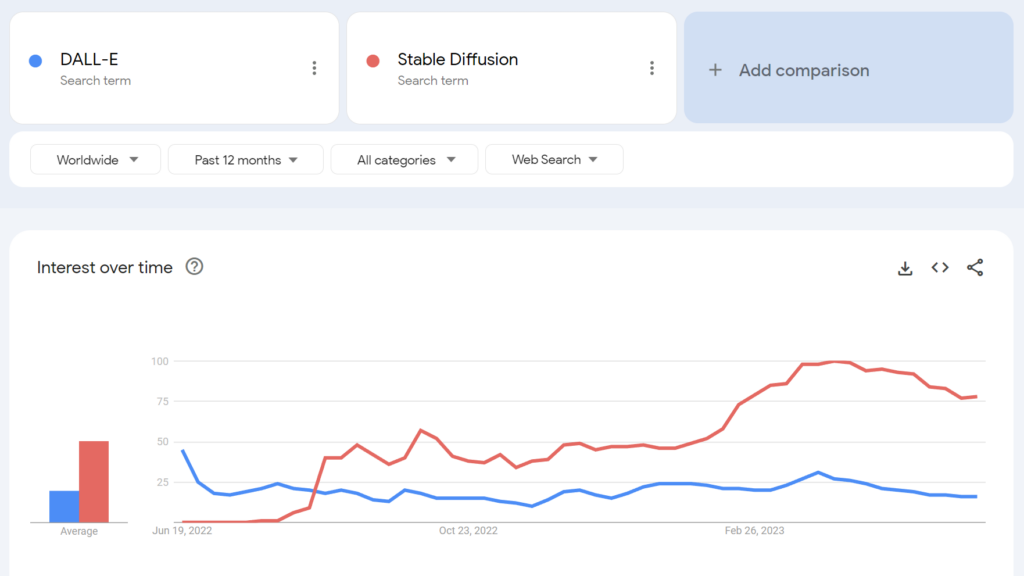

Por ejemplo, Stable Diffusion, de código abierto, se hizo más popular que DALL-E de OpenAI a los pocos meses de su lanzamiento.

¿Hasta qué punto podemos desentrañar posibles segundas intenciones? ¿Tiene el empuje regulador de las grandes tecnológicas algún mérito altruista?

La comunidad de IA de código abierto

Además de LLaMA, existen al menos tres grandes ejemplos de proyectos de IA de código abierto:

- Cara abrazada & BLOOM - La empresa de IA Hugging Face colaboró con más de 1.000 científicos voluntarios para desarrollar BLOOM, un LLM de código abierto. BLOOM pretende ofrecer una contrapartida más transparente y accesible a los modelos de IA patentados.

- Juntos - Una startup de IA llamada Together ha conseguido recaudar $20 millones en financiación inicial para apoyar su objetivo de construir alternativas descentralizadas a los sistemas cerrados de IA. Han presentado varias iniciativas de IA generativa de código abierto, como GPT-JT, OpenChatKit y RedPajama.

- Estabilidad AI - En abril de 2023, Stability AI, la empresa detrás de Stable Diffusion, lanzó StableLM, una secuencia de alternativas de código abierto a ChatGPT.

Cabe señalar que, mientras que algunos de estos desarrolladores (por ejemplo, Stable Diffusion) ofrecen sus modelos a través de cuadros de mando intuitivos y fáciles de usar, otros, como BLOOM, requieren importantes recursos para funcionar. Para empezar, se necesitan unos 360 GB de RAM para ejecutar BLOOM, pero hay muchos trucos ingeniosos para reducir los requisitos de recursos.

A medida que baja el precio del hardware con capacidad de IA y se simplifica la implantación de modelos de código abierto, es muy posible que prácticamente cualquiera pueda implantar modelos similares a ChatGPT. La filtración de la nota de Google cita ejemplos de personas que han ajustado y desplegado LLaMA en dispositivos de consumo, incluido un MacBook.

Para empresas con importantes recursos informáticos, Los modelos de código abierto ahorran dinero y proporcionan soberanía de datos y control sobre la formación y la optimización.

Sin embargo, no todo el mundo es optimista sobre el impacto de la potente IA de código abierto. Por ejemplo, el investigador de ciberseguridad Jeffrey Ladis tuiteó: "Prepárense para montones de spam personalizado e intentos de phishing" y "La externalización abierta de estos modelos fue una idea terrible".

La proliferación de la IA nos hace a todos menos seguros. Parece algo bueno de prevenir, ¡y también un reto bastante difícil!

No me sorprendería tanto que un actor estatal consiguiera hacerse con los modelos fronterizos de OpenAI en el próximo año o dos https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10 de mayo de 2023

Otro observador tuiteó: "El código abierto es una amenaza, pero no en el sentido que usted piensa. Es una amenaza porque la IA en manos de personas que pueden utilizarla para sus propios fines se vuelve aún más difícil de regular o controlar, y eso es un problema mayor."

Google y OpenAI afirman que tienen miedo de la IA de código abierto, que "no hay foso" entre todos ellos. Pero en realidad no es cierto.

El código abierto es una amenaza, pero no en el sentido que usted piensa. Es una amenaza porque la IA en manos de personas que pueden utilizarla para sus propios fines se vuelve aún más difícil de... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5 de mayo de 2023

Yann LeCun, a menudo considerado "padrino de la IA" junto a Geoffrey Hinton y Yoshio Bengman, argumenta lo contrarioUna vez que los LLM se conviertan en el principal canal de acceso a la información, la gente (y los gobiernos) *exigirán* que sean abiertos y transparentes. La infraestructura básica debe ser abierta".

LeCun también discrepó de las narrativas dominantes sobre los riesgos de la IA: "Creo que se ha exagerado ridículamente la magnitud del problema de la alineación de la IA y se ha subestimado ampliamente nuestra capacidad para resolverlo". Elon Musk contraatacó en el hilo de Twitter diciendo: "¿De verdad crees que la IA es un arma de un solo filo?".

¿De verdad crees que la IA es un arma de un solo filo?

- Elon Musk (@elonmusk) 1 de abril de 2023

Otros comentaristas establecieron paralelismos entre la regulación de la IA y la criptografía, donde el Gobierno de EE.UU. intentó prohibir los métodos criptográficos públicos mediante clasificándolas como "municiones" - apodadas las "Criptoguerras".

Ahora, prácticamente todo el mundo tiene derecho a utilizar el cifrado, pero esa batalla fue difícil de ganar, como podría ser el caso de la IA de código abierto.

La alienación de la IA de código abierto de OpenAI

El código abierto es algo más que software, código y tecnología. Es el principio, la mentalidad o la creencia de que un entorno de trabajo cooperativo, abierto y transparente supera a la competencia en un mercado cerrado.

OpenAI, que en su día fue una empresa sin ánimo de lucro centrada en la cooperación pública y el desarrollo de código abierto, se ha ido alejando progresivamente de su homónima.

La startup hizo la transición a una empresa "con fines de lucro" en 2019, poniendo fin de manera efectiva a la relación de la empresa con la comunidad de código abierto. La inversión de Microsoft desvinculó a OpenAI de cualquier tipo de actividad de I+D "abierta".

A mediados de mayo, la empresa anunció un modelo de código abierto en proyectopero no han sido francos con los detalles.

Ahora, OpenAI está impulsando una regulación que afectaría sobre todo a las empresas emergentes de IA, por no hablar de la posible criminalización de la comunidad de código abierto.

Esto ha llevado a algunos a criticar la presión de OpenAI en favor de la regulación por no ser más que un negocio: el negocio de proteger sus modelos rentables de las comunidades de código abierto que buscan democratizar la IA.

¿Es la IA de código abierto un riesgo para las grandes tecnológicas?

La combinación de la filtración de la nota de Google, la presión de las grandes tecnológicas en favor de la regulación y la denigración de Altman de los proyectos de IA de base hace que nos asombramos. De hecho, se ha cuestionado la legitimidad de los riesgos de la IA, que justifican la regulación.

Por ejemplo, cuando el Centro para la Seguridad de la IA (CAIS) publicó su declaración sísmica sobre el riesgo de la IA, cofirmada por varios directores ejecutivos de IA, algunos observadores externos no estaban convencidos.

En una selección de reacciones de expertos a la declaración publicado por el Science Media CentreEn palabras de la Dra. Mhairi Aitken, investigadora sobre ética del Instituto Alan Turing:

"Últimamente, estas afirmaciones proceden cada vez más de grandes empresas tecnológicas, predominantemente de Silicon Valley. Aunque algunos sugieren que se debe a que son conscientes de los avances de la tecnología, yo creo que en realidad está sirviendo como técnica de distracción. Está desviando la atención de las decisiones de las grandes tecnológicas (personas y organizaciones) que están desarrollando la IA e impulsando la innovación en este campo, y en su lugar está centrando la atención en hipotéticos escenarios futuros, y en imaginarias capacidades futuras de la IA".

Algunos sostienen que las grandes tecnológicas tienen la capacidad de dedicar recursos a la ética, la gobernanza y la supervisión, lo que les permite librarse de lo peor de la regulación y seguir vendiendo sus productos.

Sin embargo, es a la vez problemático denunciar los riesgos de la IA como fantasía y afirmar que no hay valor en la regulación.

Hay escépticos en ambos bandos

Desestimar los riesgos de la IA por considerarlos puramente especulativos podría resultar un error crítico para la humanidad.

De hecho, comentaristas sin conflicto de intereses han advertido sobre la IA durante décadas, incluido el difunto profesor Stephen Hawking, quien dijo que la IA "podría significar el fin de la raza humana" y ser el "peor acontecimiento en la historia de nuestra civilización."

Aunque algunos puedan argumentar que las grandes tecnológicas están esgrimiendo visiones de un apocalipsis de la IA para reforzar las estructuras de mercado y elevar las barreras de entrada, eso no eclipsa la legitimidad de los riesgos de la IA.

Por ejemplo, los equipos de investigación en IA ya han demostrado su capacidad para establecer objetivos emergentes con consecuencias potencialmente desastrosas.

Otros experimentos demuestran que las IA pueden recolectar recursos de forma activa, acumular poder y tomar medidas proactivas para evitar ser "desconectadas". Estudios creíbles sugieren que al menos algunos riesgos de la IA no son demasiado exagerados.

¿Opiniones compatibles?

La pregunta es: ¿podemos confiarnos a nosotros mismos una IA excepcionalmente potente? Entendiendo por "nosotros" a los seres humanos en todas partes, a todos los niveles, desde los grandes laboratorios de investigación tecnológica hasta las comunidades que crean IA de código abierto.

Es posible que las grandes tecnológicas deseen consolidar las estructuras de mercado al tiempo que fomentan una auténtica preocupación por el futuro de la IA. Ambas cosas no tienen por qué excluirse mutuamente.

Mientras tanto, el auge de la IA de código abierto es inevitable, y la regulación corre el riesgo de provocar descontento entre una comunidad que posee una de las tecnologías más peligrosas de la humanidad.

Ya es demasiado tarde para subyugar a la IA de código abierto mediante la regulación, e intentarlo podría conducir a una era destructiva de prohibición de la IA.

Al mismo tiempo, los debates en torno a los peligros de la IA deben basarse en las pruebas, la única señal objetiva que tenemos del potencial dañino de la tecnología.