Los investigadores han publicado un estudio en el que comparan la precisión y calidad de los resúmenes que elaboran los LLM. Claude 3 Opus rindió especialmente bien, pero los humanos siguen teniendo ventaja.

Los modelos de IA son extremadamente útiles para resumir documentos largos cuando no se tiene tiempo o ganas de leerlos.

El lujo de ampliar las ventanas contextuales significa que podemos pedir a los modelos documentos más largos, lo que pone a prueba su capacidad para resumir siempre los hechos.

Los investigadores proceden de la Universidad de Massachusetts Amherst, Adobe, el Allen Institute for AI y la Universidad de Princeton, publicó un estudio que pretendía averiguar lo buenos que son los modelos de IA a la hora de resumir el contenido de un libro (>100k tokens).

FABLES

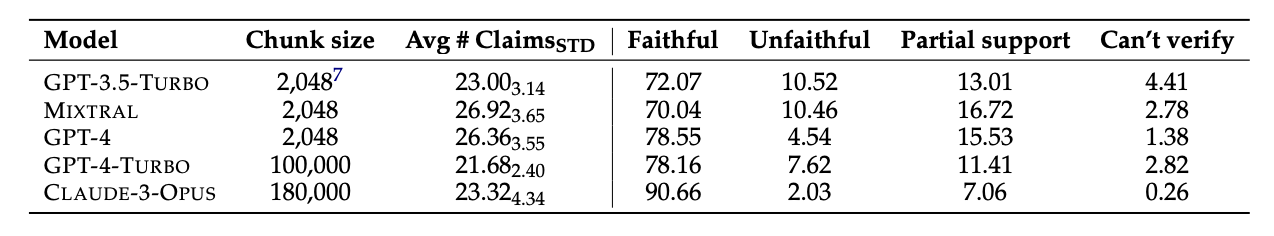

Seleccionaron 26 libros publicados en 2023 y 2024 e hicieron que varios LLM resumieran los textos. Las fechas de publicación recientes se eligieron para evitar la posible contaminación de datos en los datos de entrenamiento originales de los modelos.

Una vez que los modelos elaboraron los resúmenes, utilizaron GPT-4 para extraer de ellos afirmaciones descontextualizadas. A continuación, los investigadores contrataron a anotadores humanos que habían leído los libros y les pidieron que comprobaran las afirmaciones.

Los datos resultantes se recopilaron en un conjunto de datos denominado "Anotaciones de fidelidad para el resumen de libros" (FABLES). FABLES contiene 3.158 anotaciones de fidelidad en 26 textos narrativos.

Los resultados de las pruebas mostraron que Claude 3 Opus era "el resumidor de libros más fiel por un margen significativo", con más de 90% de sus afirmaciones verificadas como fieles, o exactas.

GPT-4 ocupó un distante segundo lugar con sólo 78% de sus afirmaciones verificadas como fieles por los anotadores humanos.

La parte difícil

Todos los modelos sometidos a prueba parecían tener problemas con las mismas cosas. La mayoría de los errores se referían a acontecimientos o estados de los personajes y sus relaciones.

El artículo señala que "la mayoría de estas afirmaciones sólo pueden invalidarse mediante un razonamiento multisalto sobre las pruebas, lo que pone de relieve la complejidad de la tarea y su diferencia respecto a los entornos existentes de verificación de hechos".

Los LLM también omiten con frecuencia información crítica en sus resúmenes. También hacen demasiado hincapié en el contenido hacia el final de los libros, omitiendo contenido importante más cercano al principio.

¿Sustituirá la IA a los anotadores humanos?

Los anotadores humanos o verificadores de hechos son caros. Los investigadores gastaron $5.200 para que los anotadores humanos verificaran las afirmaciones de los resúmenes de IA.

¿Podría un modelo de IA haber hecho el trabajo por menos? Simple recuperación de hechos es algo que Claude 3 hace bien, pero su rendimiento a la hora de verificar afirmaciones que requieren una comprensión más profunda del contenido es menos consistente.

Cuando se les presentaron las afirmaciones extraídas y se les pidió que las verificaran, todos los modelos de IA no estuvieron a la altura de los anotadores humanos. Sus resultados fueron especialmente malos en la identificación de declaraciones infieles.

Aunque Claude 3 Opus fue el mejor verificador de reclamaciones con cierta diferencia, los investigadores concluyeron que "en última instancia, su rendimiento es demasiado pobre para ser un autocalificador fiable".

Cuando se trata de comprender los matices, las complejas relaciones humanas, los puntos de la trama y las motivaciones de los personajes en una narración larga, parece que los humanos siguen teniendo ventaja por ahora.