¿Pueden los humanos aprender a detectar con fiabilidad las falsificaciones generadas por la IA? ¿Cómo nos afectan a nivel cognitivo?

Sistema Sora de OpenAI adelantó recientemente una nueva ola de medios sintéticos impulsados por la IA. Probablemente no pasará mucho tiempo antes de que cualquier forma de medio realista - audio, vídeo o imagen- pueden generarse con avisos en cuestión de segundos.

A medida que estos sistemas de inteligencia artificial aumenten su capacidad, tendremos que perfeccionar el pensamiento crítico para separar la verdad de la ficción.

Hasta la fecha, los esfuerzos de las grandes tecnológicas por frenar o detener las falsificaciones profundas se han quedado en meros sentimientos, no por falta de convicción, sino porque el contenido de la IA es muy realista.

Eso lo hace difícil de detectar a nivel de píxelmientras que otras señales, como los metadatos y las marcas de agua, tienen sus defectos.

Además, aunque los contenidos generados por inteligencia artificial fueran detectables a gran escala, resulta difícil separar los contenidos auténticos y deliberados de los que pretenden difundir información errónea.

Pasar los contenidos a revisores humanos y utilizar "notas comunitarias" (información adjunta a los contenidos, a menudo vista en X) ofrece una posible solución. Sin embargo, a veces esto implica una interpretación subjetiva y se corre el riesgo de un etiquetado incorrecto.

Por ejemplo, en el Conflicto Israel-Palestinahemos sido testigos de imágenes perturbadoras etiquetadas como reales cuando eran falsas y viceversa.

Cuando una imagen real es etiquetada como falsa, esto puede crear un 'dividendo del mentirosodonde alguien o algo puede tachar la verdad de falsa.

Así que, a falta de métodos técnicos para detener las falsificaciones profundas en el aspecto tecnológico, ¿qué podemos hacer al respecto?

Y, ¿hasta qué punto las falsificaciones profundas afectan a nuestra toma de decisiones y a nuestra psicología?

Por ejemplo, cuando la gente está expuesta a imágenes políticas falsas, ¿tiene esto un impacto tangible en sus comportamientos de voto?

Veamos un par de estudios que evalúan precisamente eso.

¿Afectan las falsificaciones profundas a nuestras opiniones y estados psicológicos?

Un estudio de 2020Deepfakes y desinformación: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News" (Vídeos falsos profundos y desinformación: análisis del impacto de los vídeos políticos sintéticos en el engaño, la incertidumbre y la confianza en las noticias), estudió cómo los vídeos falsos profundos influyen en la percepción pública, sobre todo en lo que respecta a la confianza en las noticias compartidas en las redes sociales.

La investigación consistió en un experimento a gran escala con 2.005 participantes del Reino Unido, diseñado para medir las respuestas a distintos tipos de vídeos falsos de gran profundidad del ex Presidente de Estados Unidos Barack Obama.

Los participantes fueron asignados aleatoriamente a ver uno de tres vídeos:

- Un clip de 4 segundos que muestra a Obama haciendo una declaración sorprendente sin ningún contexto.

- Un clip de 26 segundos que incluía algunas pistas sobre la naturaleza artificial del vídeo, pero que era sobre todo engañoso.

- Un vídeo completo con una "revelación educativa" en la que se revela explícitamente la naturaleza artificial de la falsificación profunda, con Jordan Peele explicando la tecnología que hay detrás de la falsificación profunda.

Principales resultados

El estudio exploró tres áreas clave:

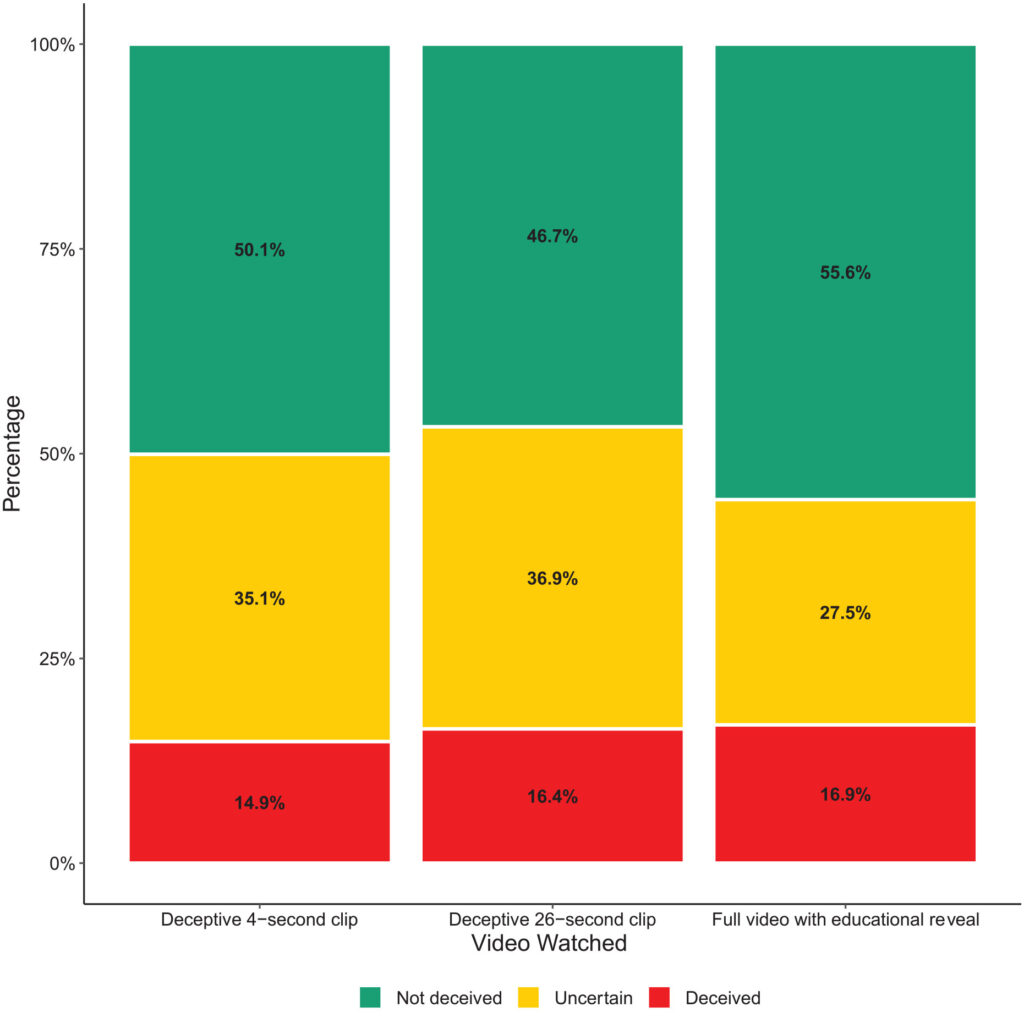

- Engaño: El estudio halló pruebas mínimas de que los participantes creyeran las afirmaciones falsas de las falsificaciones profundas. El porcentaje de participantes que se dejaron engañar por las falsificaciones profundas fue relativamente bajo en todos los grupos de tratamiento.

- Incertidumbre: Sin embargo, un resultado clave fue el aumento de la incertidumbre entre los espectadores, especialmente entre los que vieron los clips más cortos y engañosos. Alrededor del 35,1% de los participantes que vieron el clip de 4 segundos y el 36,9% que vieron el clip de 26 segundos declararon sentirse inseguros sobre la autenticidad del vídeo. En cambio, sólo 27,5% de los que vieron el vídeo educativo completo se sintieron así.

- Confianza en las noticias: Esta incertidumbre afectó negativamente a la confianza de los participantes en las noticias de las redes sociales. Los participantes expuestos a los engañosos deep fakes mostraron niveles de confianza más bajos que los que vieron la revelación educativa.

Esto demuestra que la exposición a imágenes falsas profundas provoca incertidumbre a más largo plazo.

Con el tiempo, las imágenes falsas podrían debilitar la fe en toda la información, incluida la verdad.

Resultados similares demostró un estudio más reciente de 2023El estudio, titulado "Face/Off: Changing the face of movies with deepfake", también concluía que las imágenes falsas tienen efectos a largo plazo.

La gente "recuerda" los contenidos falsos tras su exposición

El estudio Face/Off, realizado con 436 participantes, investigó cómo pueden influir las falsificaciones profundas en nuestro recuerdo de las películas.

Los participantes respondieron a una encuesta en línea diseñada para examinar sus percepciones y recuerdos de remakes cinematográficos reales e imaginarios.

El núcleo de la encuesta consistía en presentar a los participantes seis títulos de películas, que incluían una mezcla de cuatro remakes reales y dos ficticios.

MLas películas se distribuyeron aleatoriamente y se presentaron en dos formatos: La mitad de las películas se presentaron mediante breves descripciones textuales, y la otra mitad se emparejaron con breves videoclips.

Los remakes ficticios de películas consistían en versiones de "El resplandor", "Matrix", "Indiana Jones" y "Capitán Marvel", completadas con descripciones que afirmaban falsamente la participación de actores de alto nivel en estos remakes inexistentes.

Por ejemplo, a los participantes se les habló de un falso remake de "El resplandor" protagonizado por Brad Pitt y Angelina Jolie, que nunca llegó a producirse.

En cambio, los remakes de películas reales presentados en la encuesta, como "Charlie y la fábrica de chocolate" y "Total Recall", se describían con precisión y se acompañaban de fragmentos de películas auténticas. Con esta mezcla de remakes reales y falsos se pretendía investigar cómo disciernen los participantes entre el contenido real y el inventado.

Se preguntó a los participantes si estaban familiarizados con cada película, si habían visto la original o el remake o si las conocían.

Principales resultados

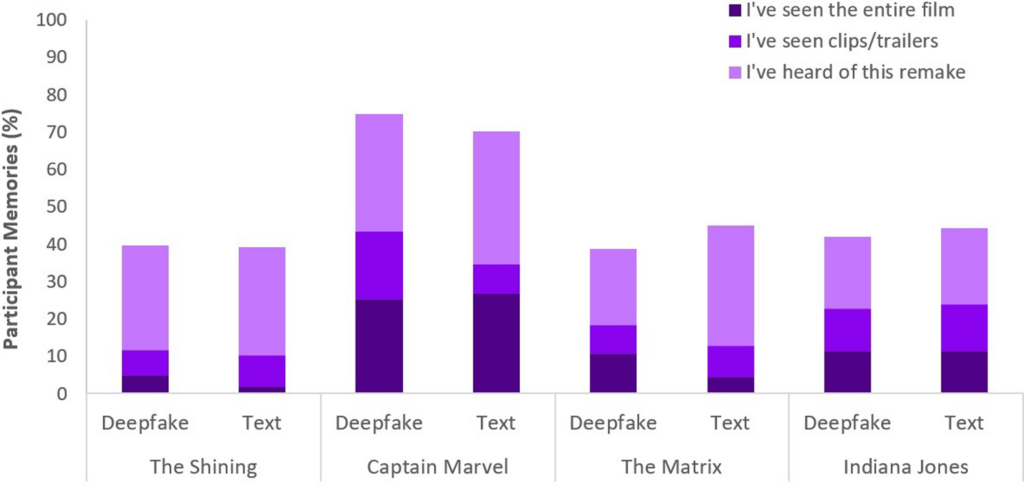

- Fenómeno de la falsa memoria: Un resultado clave del estudio es la revelación de que casi la mitad de los participantes (49%) desarrollaron recuerdos falsos al ver remakes ficticios, como imaginar a Will Smith como Neo en "Matrix". Esto ilustra el efecto duradero que los medios sugestivos, ya sean vídeos falsos profundos o descripciones textuales, pueden tener en nuestra memoria.

- En concretoEn cuanto a las películas, "Capitana Marvel" encabezó la lista, con 73% de participantes que recordaban su remake de IA, seguida de "Indiana Jones", con 43%, "Matrix", con 42%, y "El resplandor", con 40%. Entre los que creían erróneamente en estos remakes, 41% pensaban que el remake de "Capitán Marvel" era superior al original.

- Influencia comparativa de las falsificaciones profundas y el texto: Otro descubrimiento es que las falsificaciones profundas, a pesar de su realismo visual y auditivo, no fueron más eficaces para alterar los recuerdos de los participantes que las descripciones textuales del mismo contenido ficticio. Esto sugiere que el formato de la desinformación -visual o textual- no altera significativamente su impacto en la distorsión de la memoria en el contexto del cine.

El fenómeno de la falsa memoria es objeto de una amplia investigación. Demuestra cómo los humanos construimos o reconstruimos recuerdos falsos que creemos reales cuando en realidad no lo son.

Todo el mundo es susceptible de construir falsos recuerdos, y das falsificaciones parecen activar este comportamiento, lo que significa que ver ciertos contenidos puede cambiar nuestra percepción, incluso cuando comprendemos conscientemente que no son auténticos.

En ambos estudios, las falsificaciones profundas tuvieron repercusiones tangibles y potencialmente a largo plazo. El efecto podría sorprender y acumularse con el tiempo.

También debemos recordar que los contenidos falsos circulan entre millones de personas, por lo que los pequeños cambios de percepción se extienden a toda la población mundial.

¿Qué hacemos con las falsificaciones profundas?

Ir a la guerra contra las falsificaciones profundas significa combatir el cerebro humano.

Mientras que el auge de las noticias falsas y la desinformación ha obligado a las personas a desarrollar una nueva alfabetización mediática en los últimos años, los medios sintéticos generados por IA requerirán un nuevo nivel de ajuste.

Ya nos hemos enfrentado antes a estos puntos de inflexión, desde la fotografía hasta los efectos especiales CGI, pero la IA exigirá una evolución de nuestros sentidos críticos.

Hoy en día, debemos ir más allá de simplemente creer a nuestros ojos y confiar más en el análisis de las fuentes y las pistas contextuales.

Es esencial interrogarse sobre los incentivos o prejuicios de los contenidos. ¿Coincide con los hechos conocidos o los contradice? ¿Hay pruebas que lo corroboren procedentes de otras fuentes fiables?

Otro aspecto clave es el establecimiento de normas jurídicas para identificar los medios falsificados o manipulados y exigir responsabilidades a los creadores.

En Ley DEFIANCE estadounidenseLa Ley de Seguridad en Línea del Reino Unido y sus equivalentes en todo el mundo están estableciendo procedimientos legales para tratar las falsificaciones profundas. Queda por ver hasta qué punto serán eficaces.

Estrategias para desvelar la verdad

Concluyamos con cinco estrategias para identificar e interrogar a posibles falsos profundos.

Aunque ninguna estrategia es perfecta, fomentar una mentalidad crítica es lo mejor que podemos hacer colectivamente para minimizar el impacto de la desinformación de la IA.

- Verificación de la fuente: Examinar la credibilidad y el origen de la información es un paso fundamental. Los contenidos auténticos suelen proceder de fuentes reputadas con un historial de fiabilidad.

- Análisis técnico: A pesar de su sofisticación, las falsificaciones profundas pueden presentar defectos sutiles, como expresiones faciales irregulares o una iluminación incoherente. Examine el contenido y considere si está alterado digitalmente.

- Referencias cruzadas: La verificación de la información con múltiples fuentes de confianza puede ofrecer una perspectiva más amplia y ayudar a confirmar la autenticidad del contenido.

- Alfabetización digital: Comprender las capacidades y limitaciones de las tecnologías de IA es clave para evaluar los contenidos. La educación en alfabetización digital en las escuelas y los medios de comunicación, incluido el funcionamiento de la IA y sus implicaciones éticas, será crucial.

- Interacción cautelosa: Interactuar con desinformación generada por IA amplifica sus efectos. Ten cuidado al dar a "me gusta", compartir o reenviar contenidos de los que tengas dudas.

A medida que evolucionen las falsificaciones profundas, también lo harán las técnicas necesarias para detectarlas y mitigar los daños. El año 2024 será revelador, ya que alrededor de la mitad de la población mundial votará en las principales elecciones.

Las pruebas sugieren que las falsificaciones profundas pueden afectar a nuestra percepción, por lo que no es descabellado pensar que la desinformación de la IA pueda afectar materialmente a los resultados.

A medida que avancemos, las prácticas éticas de la IA, la alfabetización digital, la regulación y el compromiso crítico serán fundamentales para dar forma a un futuro en el que la tecnología amplifique, en lugar de oscurecer, la esencia de la verdad.