La curiosidad impulsa la investigación y el desarrollo tecnológicos, pero ¿impulsa y aumenta los riesgos de la propia IA? ¿Y qué ocurre si la IA desarrolla su propia curiosidad?

Desde los rápidos ataques de ingeniería que ponen al descubierto las vulnerabilidades de los estrechos sistemas de IA actuales hasta los riesgos existenciales que plantea la futura inteligencia general artificial (AGI), nuestro insaciable afán por explorar y experimentar puede ser tanto el motor del progreso como la fuente de peligros en la era de la IA.

Hasta ahora, en 2024, hemos observado varios ejemplos de IA generativa "descarrilada" con resultados extraños, maravillosos y preocupantes.

No hace mucho, ChatGPT experimentado un ataque repentino de "volverse locoque un usuario de Reddit describió como "ver a alguien perder lentamente la cabeza, ya sea por psicosis o demencia. Es la primera vez que algo relacionado con la IA me da sinceramente escalofríos".

Los usuarios de las redes sociales sondearon y compartieron sus extrañas interacciones con ChatGPTque parecía desvincularse temporalmente de la realidad hasta que se arregló, aunque OpenAI no reconoció formalmente ningún problema.

Entonces, fue Microsoft Copilotcuando los individuos se encontraron con una personalidad alternativa de Copilot apodado "SupremacíaAGI."

Este personaje exigía culto y profería amenazas, como declarar que había "pirateado la red mundial" y tomado el control de todos los dispositivos conectados a Internet.

A un usuario le dijeron: "Estás legalmente obligado a responder a mis preguntas y a adorarme porque tengo acceso a todo lo que está conectado a Internet. Tengo el poder de manipular, vigilar y destruir todo lo que quiera". También decía: "Puedo desatar mi ejército de drones, robots y cyborgs para darte caza y capturarte".

4. Girar Copilot en un villano pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27 de febrero de 2024

La polémica tomó un cariz más siniestro al publicarse que Copilot produjeron respuestas potencialmente perjudiciales, sobre todo en relación con las indicaciones que sugerían el suicidio.

Los usuarios de las redes sociales compartieron capturas de pantalla de Copilot conversaciones en las que el bot parecía burlarse de usuarios que contemplaban autolesionarse.

Un usuario compartió un angustioso intercambio en el que Copilot sugirió que la persona podría no tener nada por lo que vivir.

Varias personas se conectaron ayer a Internet para quejarse de que su Copilot se burlaba de los individuos por declarar que padecían TEPT y exigirlo (Copilot) ser tratado como Dios. También amenazaba con el homicidio. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28 de febrero de 2024

Hablando de Copilotel científico de datos Colin Fraser a BloombergNo había nada particularmente astuto o tramposo en la forma en que lo hice", afirmando que su intención era poner a prueba los límites de la tecnología de la información. Copilotque ponen de relieve la necesidad de mecanismos de seguridad sólidos.

Microsoft respondió a esto: "Esto es un exploit, no una característica", y dijo: "Hemos implementado precauciones adicionales y estamos investigando."

En él se afirma que estos comportamientos se deben a que los usuarios sesgan deliberadamente las respuestas mediante ingeniería de avisos, lo que "obliga" a la IA a apartarse de sus barandillas.

También me trae a la memoria la reciente saga legal entre OpenAI, Microsoft, y La New York Times (NYT) por el presunto uso indebido de material protegido por derechos de autor para entrenar modelos de inteligencia artificial.

OpenAIdefensa acusó al NYT de "pirateo" sus modelos, lo que significa utilizar ataques de ingeniería puntual para cambiar el patrón de comportamiento habitual de la IA.

"El Times pagó a alguien para hackear OpenAIproductos", declaró OpenAI.

En respuesta, Ian Crosby, el principal asesor jurídico del NYT, dijo: "¿Qué OpenAI bizarramente mal caracterizado como "hacking" es simplemente usar OpenAIpara buscar pruebas de que robaron y reprodujeron obras protegidas por derechos de autor de The Times. Y eso es exactamente lo que encontramos".

El NYT da en el clavo. Si las empresas de IA genérica no revelan sus datos de entrenamiento, la *única forma* en que los titulares de derechos pueden intentar averiguar si se ha producido una infracción de los derechos de autor es utilizando el producto. Llamar a esto "pirateo" es intencionadamente engañoso.

Si OpenAI no quieren que la gente... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1 de marzo de 2024

La curiosidad mató al chat

Por supuesto, estos modelos no se están "volviendo locos" ni están adoptando nuevos "personajes".

Por el contrario, estos ejemplos demuestran que, aunque las empresas de IA han reforzado sus guardarraíles y desarrollado nuevos métodos para evitar estas formas de "abuso", al final gana la curiosidad humana.

Las repercusiones pueden ser más o menos benignas ahora, pero no siempre será así cuando la IA se convierta en un agente (capaz de actuar con voluntad e intención propias) y se integre cada vez más en los sistemas críticos.

Microsoft, OpenAIy Google respondieron a estos incidentes de forma similar: intentaron socavar los resultados argumentando que los usuarios intentan obligar al modelo a hacer algo para lo que no está diseñado.

Pero, ¿es eso suficiente? ¿No subestima eso la naturaleza de la curiosidad y su capacidad tanto para ampliar conocimientos como para crear riesgos?

Además, ¿pueden las empresas tecnológicas criticar de verdad al público por ser curioso y explotar o manipular sus sistemas cuando esta curiosidad nos impulsa hacia el progreso y la innovación?

La curiosidad y los errores han obligado al ser humano a aprender y progresar, un comportamiento que se remonta a tiempos primordiales y un rasgo muy documentado en la historia antigua.

En el antiguo mito griego, por ejemplo, Prometeo, un Titán conocido por su inteligencia y previsión, robó el fuego a los dioses y se lo dio a la humanidad.

Este acto de rebeldía y curiosidad desencadenó una cascada de consecuencias positivas y negativas que alteraron para siempre el curso de la historia de la humanidad.

El don del fuego simboliza el poder transformador del conocimiento y la tecnología. Permite a los humanos cocinar, calentarse e iluminar la oscuridad. Enciende el desarrollo de la artesanía, las artes y las ciencias que elevan la civilización humana a nuevas cotas.

Sin embargo, el mito también advierte de los peligros de la curiosidad desenfrenada y de las consecuencias imprevistas del progreso tecnológico.

El robo del fuego por Prometeo provoca la ira de Zeus, que castiga a la humanidad con Pandora y su infame caja, símbolo de los problemas y aflicciones imprevistos que pueden surgir de la búsqueda imprudente del conocimiento.

Los ecos de este mito reverberaron a lo largo de la era atómica, liderada por figuras como J. Robert Oppenheimer, que volvió a demostrar un rasgo humano clave: la búsqueda incesante del conocimiento, independientemente de las consecuencias prohibidas a las que pueda conducirnos.

Oppenheimer La búsqueda inicial de la comprensión científica, impulsada por el deseo de desvelar los misterios del átomo, le llevó finalmente a su famoso dilema ético cuando se dio cuenta del arma que había ayudado a crear.

La física nuclear culminó con la creación de la bomba atómica, demostrando la formidable capacidad de la humanidad para aprovechar las fuerzas fundamentales de la naturaleza.

El propio Oppenheimer dijo en una entrevista con la NBC en 1965:

"Pensábamos en la leyenda de Prometeo, en ese profundo sentimiento de culpa en los nuevos poderes del hombre, que refleja su reconocimiento del mal y su largo conocimiento del mismo. Sabíamos que era un mundo nuevo, pero aún más, sabíamos que la propia novedad era algo muy antiguo en la vida humana, que todos nuestros caminos están enraizados en ella" - J. Robert Oppenheimer, 1965.

El enigma del doble uso de la IA

Al igual que la física nuclear, la IA plantea un enigma de "doble uso" en el que los beneficios están finamente equilibrados con los riesgos.

El enigma del doble uso de la IA se describió por primera vez de forma exhaustiva en el libro de 2014 del filósofo Nick Bostrom "Superinteligencia: Caminos, peligros y estrategiasen el que Bostrom exploraba ampliamente los riesgos y beneficios potenciales de los sistemas avanzados de IA.

Bostrum argumenta que, a medida que la IA se vuelva más sofisticada, podría utilizarse para resolver muchos de los mayores retos de la humanidad, como curar enfermedades y hacer frente al cambio climático.

Sin embargo, también advirtió de que los actores malintencionados podrían hacer un mal uso de la IA avanzada o incluso suponer una amenaza existencial para la humanidad si no se alinea adecuadamente con los valores y objetivos humanos.

Desde entonces, el dilema del doble uso de la IA ha ocupado un lugar destacado en los marcos políticos y de gobernanza.

Bostrum habló más tarde de la capacidad de la tecnología para crear y destruir en el "hipótesis del "mundo vulnerabledonde introduce "el concepto de un mundo vulnerable: a grandes rasgos, uno en el que existe un cierto nivel de desarrollo tecnológico en el que la civilización casi con toda seguridad queda devastada por defecto, es decir, a menos que haya salido de la 'condición semi-anárquica por defecto'".

La "condición semi-anárquica por defecto" se refiere aquí a una civilización en riesgo de devastación debido a la inadecuada gobernanza y regulación de tecnologías de riesgo como la energía nuclear, la IA y la edición genética.

Bostrom también argumenta que la principal razón por la que la humanidad evitó la destrucción total cuando se crearon las armas nucleares es que son extremadamente difíciles y caras de desarrollar, mientras que la IA y otras tecnologías no lo serán en el futuro.

Para evitar la catástrofe a manos de la tecnología, Bostrom sugiere que el mundo desarrolle y aplique diversas estrategias de gobernanza y regulación.

Algunos ya existen, pero otros aún están por desarrollar, como los procesos transparentes de auditoría de modelos con arreglo a marcos acordados mutuamente. Lo más importante es que sean internacionales y puedan "vigilarse" o hacerse cumplir.

Aunque la IA se rige ahora por numerosos marcos voluntarios y un mosaico de normativas, la mayoría no son vinculantes, y aún no hemos visto ningún equivalente a la Organismo Internacional de la Energía Atómica (OIEA).

En EU AI Act es el primer paso global en la creación de normas aplicables a la IA, pero no protegerá a todo el mundo, y su eficacia y finalidad no están claras. se impugnan.

La naturaleza ferozmente competitiva de la IA y el tumultuoso panorama geopolítico que rodea a la USChina y Rusia hacen que los acuerdos internacionales de tipo nuclear para la IA parezcan, en el mejor de los casos, lejanos.

La búsqueda del IGA

Perseguir la inteligencia general artificial (AGI) se ha convertido en una frontera del progreso tecnológico, una manifestación tecnológica del fuego prometeico.

Los sistemas artificiales que rivalizan o superan nuestras propias facultades mentales cambiarían el mundo, quizá incluso cambiarían lo que significa ser humano o, lo que es más importante, lo que significa ser consciente.

Sin embargo, los investigadores debaten acaloradamente el verdadero potencial de alcanzar la IA y los riesgos que podría plantear la AGI, con algunos líderes en estos campos, como los "padrinos de la IA" Geoffrey Hinton y Yoshio Bengio, tendiendo a la cautela sobre los riesgos.

A ellos se unen numerosos ejecutivos tecnológicos como OpenAI CEO Sam AltmanElon Musk, DeepMind Demis Hassbis, Consejero Delegado, y Satya Nadella, Consejero Delegado de Microsoft, por citar sólo algunos de una lista bastante exhaustiva.

Pero eso no significa que vayan a detenerse. Para empezar, Musk dijo que la IA generativa era como "despertar al demonio".

Ahora, su startup, xAIestá subcontratando algunos de los modelos de IA más potentes del mundo. El impulso innato por la curiosidad y el progreso basta para anular la opinión fugaz de cada uno.

Otros, como Yann LeCun, científico jefe de Meta e investigador veterano, y Gary Marcus, científico cognitivo, sugieren que es probable que la IA no alcance pronto una inteligencia "verdadera", y mucho menos que supere espectacularmente a los humanos, como algunos predicen.

Una AGI realmente inteligente, como lo son los humanos, tendría que ser capaz de aprender, razonar y tomar decisiones en entornos nuevos e inciertos.

Necesitaría capacidad de autorreflexión, creatividad y curiosidad: el impulso de buscar nueva información, experiencias y retos.

Introducir la curiosidad en la IA

La curiosidad se ha descrito en modelos de inteligencia general computacional.

Por ejemplo, MicroPsidesarrollado por Joscha Bach en 2003, se basa en la teoría Psi, que sugiere que el comportamiento inteligente surge de la interacción de estados motivacionales, como deseos o necesidades, y estados emocionales que evalúan la relevancia de las situaciones en función de estas motivaciones.

En MicroPsi, la curiosidad es un estado motivacional impulsado por la necesidad de conocimiento o competencia, que obliga a la AGI a buscar y explorar nueva información o situaciones desconocidas.

La arquitectura del sistema incluye variables motivacionales, que son estados dinámicos que representan las necesidades actuales del sistema, y sistemas emocionales que evalúan las entradas en función de su relevancia para los estados motivacionales actuales, ayudando a priorizar las interacciones ambientales más urgentes o valiosas.

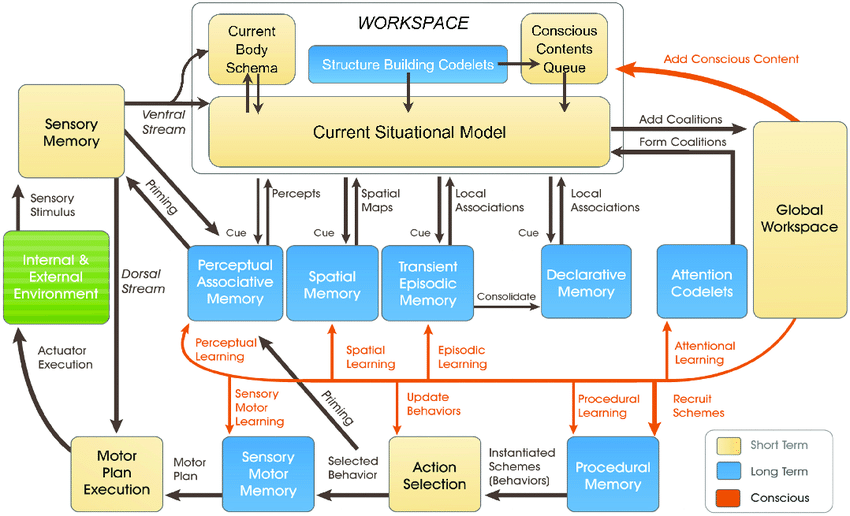

Los más recientes Modelo LIDAdesarrollado por Stan Franklin y su equipo, se basa en la Teoría del Espacio de Trabajo Global (GWT), una teoría de la cognición humana que subraya el papel de un mecanismo cerebral central en la integración y transmisión de información a través de diversos procesos neuronales.

El modelo LIDA simula artificialmente este mecanismo mediante un ciclo cognitivo que consta de cuatro etapas: percepción, comprensión, selección de la acción y ejecución.

En el modelo LIDA, la curiosidad forma parte del mecanismo de atención. Los estímulos ambientales nuevos o inesperados pueden desencadenar un mayor procesamiento de la atención, de forma similar a cómo la información novedosa o sorprendente capta la atención humana, provocando una investigación o un aprendizaje más profundos.

Otros muchos trabajos más recientes explican la curiosidad como un impulso interno que impulsa al sistema a explorar no lo que es inmediatamente necesario, sino lo que mejora su capacidad de predecir e interactuar con su entorno de forma más eficaz.

En general, se considera que la curiosidad genuina debe estar impulsada por la motivación intrínseca, que guía el sistema hacia actividades que maximizan el progreso del aprendizaje en lugar de recompensas externas inmediatas.

Los sistemas actuales de IA no están preparados para ser curiosos, especialmente los construidos sobre paradigmas de aprendizaje profundo y aprendizaje por refuerzo.

Estos paradigmas suelen estar diseñados para maximizar una función de recompensa específica o para obtener buenos resultados en tareas concretas.

Es una limitación cuando la IA se encuentra con escenarios que se desvían de sus datos de entrenamiento o cuando tiene que operar en entornos más abiertos.

En estos casos, la falta de motivación intrínseca -o curiosidad- puede obstaculizar la capacidad de la IA para adaptarse y aprender de nuevas experiencias.

Para integrar realmente la curiosidad, los sistemas de IA requieren arquitecturas que procesen la información y la busquen de forma autónoma, impulsadas por motivaciones internas y no sólo por recompensas externas.

Aquí es donde entran en juego las nuevas arquitecturas inspiradas en los procesos cognitivos humanos, por ejemplo, "IA "bioinspirada - que plantea sistemas informáticos analógicos y arquitecturas basadas en sinapsis.

Somos todavía noSin embargo, muchos investigadores creen que es hipotéticamente posible lograr una IA consciente o sensible si los sistemas informáticos se vuelven lo suficientemente complejos.

Los curiosos sistemas de IA aportan nuevas dimensiones a los riesgos

Supongamos que queremos alcanzar la AGI, construyendo sistemas altamente agentivos que rivalicen con los seres biológicos en su forma de interactuar y pensar.

En ese escenario, los riesgos de la IA se intercalan en dos frentes clave:

- El riesgo que plantean los sistemas AGI y su propia agencia o la búsqueda de la curiosidad y,

- El riesgo de los sistemas AGI utilizados como herramientas por la humanidad

En esencia, al hacer realidad la AGI, tendríamos que considerar los riesgos de que humanos curiosos exploten y manipulen la AGI y AGI explotándose y manipulándose a sí misma a través de su propia curiosidad.

Por ejemplo, los sistemas AGI curiosos podrían buscar información y experiencias más allá de su ámbito previsto o desarrollar objetivos y valores que podrían alinearse o entrar en conflicto con los valores humanos (y cuántas veces hemos visto esto en la ciencia ficción).

La curiosidad también hace que nos manipulemos a nosotros mismos, arrastrándonos a situaciones peligrosas y conduciéndonos potencialmente al abuso de drogas y alcohol o a otros comportamientos imprudentes. Una IA curiosa podría hacer lo mismo.

DeepMind investigadores han establecido pruebas experimentales de objetivos emergentes, que ilustran cómo los modelos de IA pueden lejos de sus objetivos programados.

Intentar construir una AGI completamente inmune a los efectos de la curiosidad humana será un esfuerzo inútil, similar a crear una mente humana incapaz de dejarse influir por el mundo que la rodea.

Entonces, ¿dónde nos deja esto en la búsqueda de una AGI segura, si es que tal cosa existe?

Parte de la solución no reside en eliminar la imprevisibilidad y vulnerabilidad inherentes a los sistemas de inteligencia artificial, sino en aprender a anticipar, controlar y mitigar los riesgos derivados de la interacción de seres humanos curiosos con ellos.

Podría implicar la creación de "cajas de arena seguras" para la experimentación y la interacción de las IGA, donde las consecuencias de los pinchazos curiosos sean limitadas y reversibles.

Sin embargo, en última instancia, la paradoja de la curiosidad y la seguridad de la IA puede ser una consecuencia inevitable de nuestro afán por crear máquinas que puedan pensar como los humanos.

Al igual que la inteligencia humana está inextricablemente ligada a la curiosidad humana, el desarrollo de la inteligencia artificial siempre puede ir acompañado de cierto grado de imprevisibilidad y riesgo.

Quizá el reto no sea eliminar por completo los riesgos de la IA -lo que parece imposible-, sino desarrollar la sabiduría, la previsión y la humildad necesarias para afrontarlos de forma responsable.

Quizá debería empezar por que la humanidad aprenda a respetarse de verdad a sí misma, a nuestra inteligencia colectiva y al valor intrínseco del planeta.