Oímos hablar mucho de la seguridad de la IA, pero ¿significa eso que está muy presente en la investigación?

Un nuevo estudiar del Observatorio de Tecnologías Emergentes de la Universidad de Georgetown sugiere que, a pesar del ruido, la investigación sobre la seguridad de la IA no ocupa más que una ínfima minoría de los focos de investigación de la industria.

Los investigadores analizaron más de 260 millones de publicaciones académicas y descubrieron que apenas 2% de los artículos relacionados con la IA publicados entre 2017 y 2022 abordaban directamente temas relacionados con la seguridad, la ética, la solidez o la gobernanza de la IA.

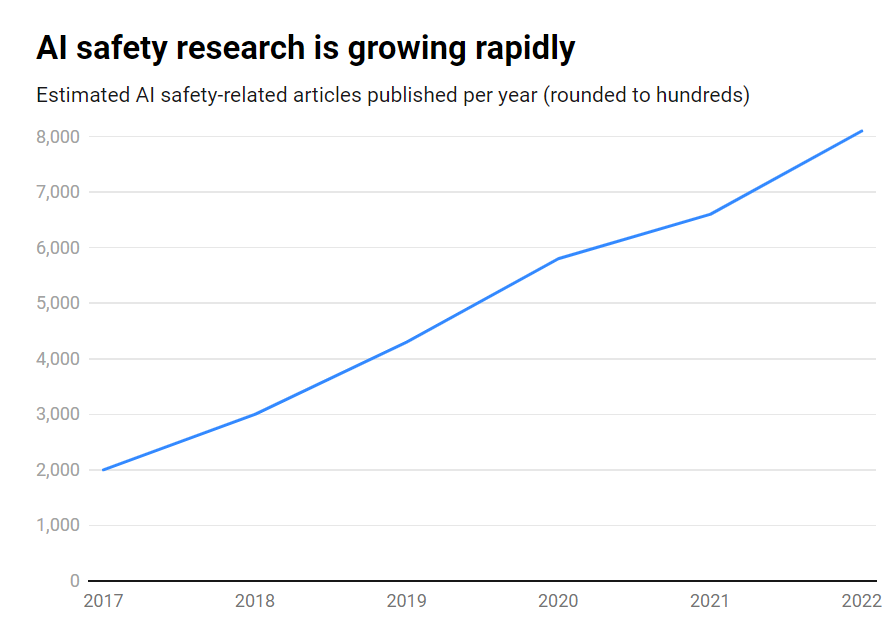

Aunque el número de publicaciones sobre seguridad de la IA creció de forma impresionante 315% durante ese periodo, pasando de unas 1.800 a más de 7.000 al año, sigue siendo un tema periférico.

He aquí las principales conclusiones:

- Solo 2% de la investigación en IA entre 2017 y 2022 se centraron en la seguridad de la IA

- La investigación en seguridad de la IA creció 315% en ese periodo, pero se ve empequeñecida por la investigación global en IA

- EE.UU. lidera la investigación sobre seguridad de la IA, mientras que China se queda rezagada

- Los principales retos son la solidez, la equidad, la transparencia y el mantenimiento del control humano.

Muchos investigadores y especialistas en ética de la IA han advertido de los riesgos existenciales que entrañaría el desarrollo de la inteligencia artificial general (IAG) sin las suficientes salvaguardias y precauciones.

Imaginemos un sistema AGI capaz de mejorarse a sí mismo de forma recursiva, superando rápidamente la inteligencia humana al tiempo que persigue objetivos no alineados con nuestros valores. Se trata de un escenario que, según algunos, podría escapar a nuestro control.

Sin embargo, no se trata de un tráfico unidireccional. De hecho, un gran número de investigadores de IA creen que La seguridad de la IA está sobrevalorada.

Más allá de eso, algunos incluso piensan que el bombo se ha fabricado para ayudar a las grandes tecnológicas a hacer cumplir la normativa y eliminar a las comunidades de base y a los competidores de código abierto.

Sin embargo, incluso los limitados sistemas de IA actuales, entrenados a partir de datos anteriores, pueden mostrar sesgos, producir contenidos dañinos, violar la privacidad y ser utilizados de forma malintencionada.

Así pues, aunque la seguridad de la IA debe mirar hacia el futuro, también debe abordar los riesgos en el presente, lo que puede considerarse insuficiente, ya que las falsificaciones profundas, la parcialidad y otros problemas siguen acechando.

Una investigación eficaz sobre la seguridad de la IA debe abordar tanto los retos a corto plazo como los riesgos especulativos a largo plazo.

EE.UU. lidera la investigación sobre seguridad de la IA

Si profundizamos en los datos, Estados Unidos es el líder indiscutible en investigación sobre seguridad de la IA, con 40% de publicaciones relacionadas, frente a los 12% de China.

Sin embargo, la producción china en materia de seguridad va muy a la zaga de su investigación general sobre IA: mientras que 5% de la investigación estadounidense sobre IA se referían a la seguridad, sólo 1% de la china lo hacían.

Se podría especular que sondear la investigación china es una tarea del todo difícil. Además, China ha sido proactiva en materia de regulación - podría decirse que más que en Estados Unidos-, por lo que estos datos podrían no dar la razón a la industria de la IA del país.

A nivel institucional, la Universidad Carnegie Mellon, Google, el MIT y Stanford encabezan el pelotón.

Pero a nivel mundial, ninguna organización produjo más del 2% del total de publicaciones relacionadas con la seguridad, lo que pone de manifiesto la necesidad de un esfuerzo mayor y más concertado.

Desequilibrios de seguridad

¿Qué se puede hacer para corregir este desequilibrio?

Eso depende de si uno piensa que la seguridad de la IA es un riesgo acuciante al mismo nivel que la guerra nuclear, las pandemias, etc. No hay una respuesta clara a esta pregunta, por lo que la seguridad de la IA es un tema altamente especulativo con escasa repercusión mutua. acuerdo entre investigadores.

La investigación sobre la seguridad y la ética son también en cierto modo un ámbito tangencial al aprendizaje automático, que requiere diferentes conjuntos de habilidades, formación académica, etc., que pueden no estar bien financiados.

Para colmar las lagunas en materia de seguridad de la inteligencia artificial también habrá que afrontar cuestiones relacionadas con la apertura y el secreto en el desarrollo de la inteligencia artificial.

Las mayores empresas tecnológicas realizan amplias investigaciones internas sobre seguridad que nunca se han publicado. A medida que se acelera la comercialización de la inteligencia artificial, las empresas protegen cada vez más sus avances en este campo.

OpenAI, por ejemplo, fue un centro neurálgico de investigación en sus inicios.

La empresa solía realizar auditorías independientes en profundidad de sus productos, sesgos en el etiquetado y riesgos -como sesgo sexista en su proyecto CLIP.

Anthropic sigue participando activamente en la investigación de la seguridad pública de la IA, publicando con frecuencia estudios sobre sesgo y jailbreaking.

DeepMind también ha documentado la posibilidad de que los modelos de IA establezcan "objetivos emergentes" y contradigan activamente sus instrucciones o se vuelvan adversarios de sus creadores.

En general, sin embargo, la seguridad ha pasado a un segundo plano frente al progreso, ya que Silicon Valley vive según su lema "muévete rápido y rompe cosas".

En última instancia, el estudio de Georgetown subraya que las universidades, los gobiernos, las empresas tecnológicas y los financiadores de la investigación deben invertir más esfuerzos y dinero en la seguridad de la IA.

Algunos también han pedido una organismo internacional para la seguridad de la ai, similar al Organismo Internacional de la Energía Atómica (OIEA), creado tras una serie de incidentes nucleares que hicieron obligatoria una profunda cooperación internacional.

¿Necesitará la IA su propio desastre para lograr ese nivel de cooperación estatal y empresarial? Esperemos que no.