El ejército estadounidense está probando a integrar chatbots de inteligencia artificial en su planificación estratégica, aunque dentro de los límites de una simulación de juego de guerra basada en el popular videojuego Starcraft II.

Este estudiardirigido por el Laboratorio de Investigación del Ejército de Estados Unidos, analiza las estrategias de campo de batalla GPT-4 Turbo y GPT-4 Vision de OpenAI.

Esto forma parte de la colaboración con el Departamento de Defensa (DOD) tras el establecimiento de la grupo de trabajo sobre IA generativa el año pasado.

El uso de la IA en el campo de batalla es acaloradamente debatidocon un reciente estudio similar sobre juegos de guerra con IA descubriendo que los LLM como el GPT-3.5 y el GPT-4 tienden a intensificar las tácticas diplomáticas, lo que a veces desemboca en una guerra nuclear.

Esta nueva investigación del ejército estadounidense utilizó Starcraft II para simular un escenario de campo de batalla en el que participaban un número limitado de unidades militares.

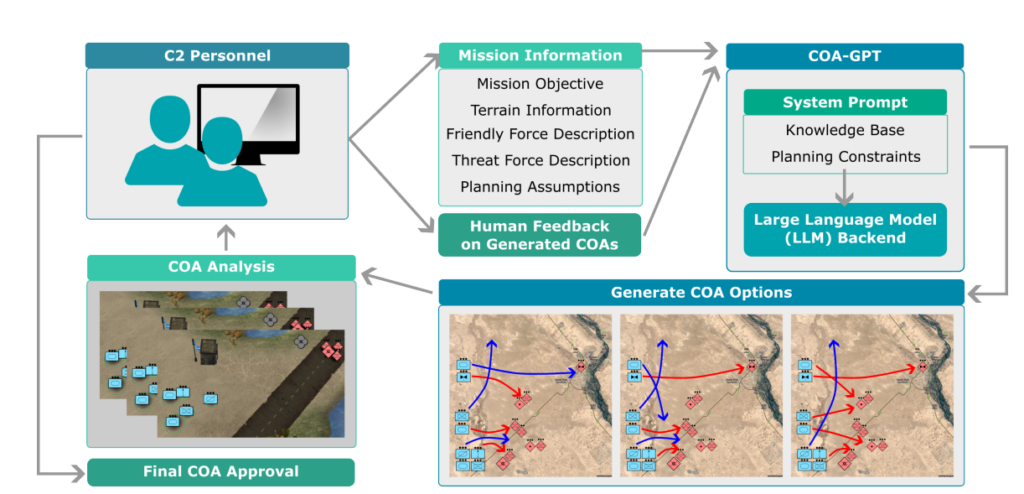

Los investigadores bautizaron este sistema como "COA-GPT", siendo COA el término militar "Cursos de Acción", que describe esencialmente las tácticas militares.

El COA-GPT asumió el papel de ayudante del comandante militar, encargado de idear estrategias para aniquilar a las fuerzas enemigas y capturar puntos estratégicos.

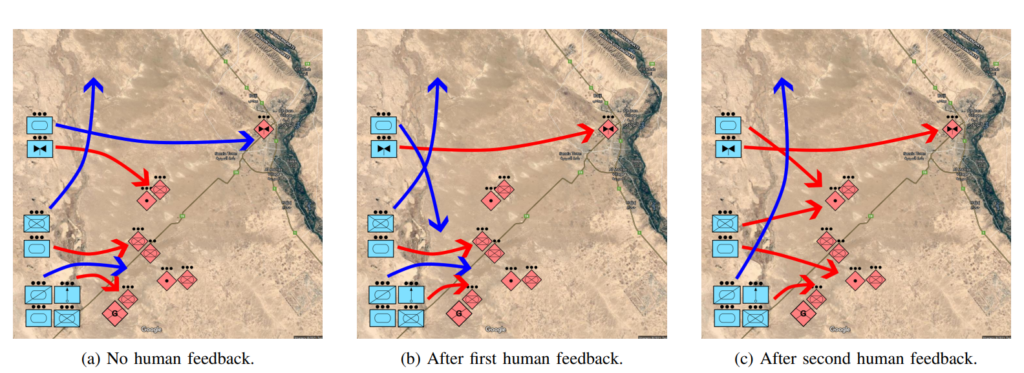

Los investigadores señalan que el COA tradicional es notoriamente lento y laborioso. COA-GPT toma decisiones en cuestión de segundos e integra los comentarios humanos en el proceso de aprendizaje de la IA.

COA-GPT supera a otros métodos, pero tiene un coste

COA-GPT demostró un rendimiento superior al de los métodos existentes y superó a éstos en la generación de COA estratégicos, y podía adaptarse a las reacciones en tiempo real.

Sin embargo, había fallos. En particular, el COA-GPT sufrió un mayor número de bajas en el cumplimiento de los objetivos de la misión.

El estudio afirma: "Observamos que el COA-GPT y el COA-GPT-V, incluso cuando se mejoran con retroalimentación humana exhiben mayores bajas de fuerzas amigas en comparación con otras líneas de base".

¿Disuade esto a los investigadores? Parece que no.

El estudio afirma: "En conclusión, COA-GPT representa un enfoque transformador en las operaciones militares de C2, facilitando una toma de decisiones más rápida y ágil y manteniendo una ventaja estratégica en la guerra moderna".

Es preocupante que un sistema de IA que causó más bajas innecesarias que el de referencia se defina como un "enfoque transformador."

El Departamento de Defensa ya ha identificado otras vías para explorar los usos militares de la IA, pero la preparación de la tecnología y sus implicaciones éticas son motivo de preocupación.

Por ejemplo, ¿quién es responsable cuando los militares Las aplicaciones de IA salen mal? ¿Los promotores? ¿El responsable? ¿O alguien más abajo en la cadena?

Los sistemas de guerra de IA ya están desplegados en los conflictos de Ucrania y Palestina-Israel, pero estas cuestiones siguen sin ponerse a prueba.

Esperemos que siga siendo así.