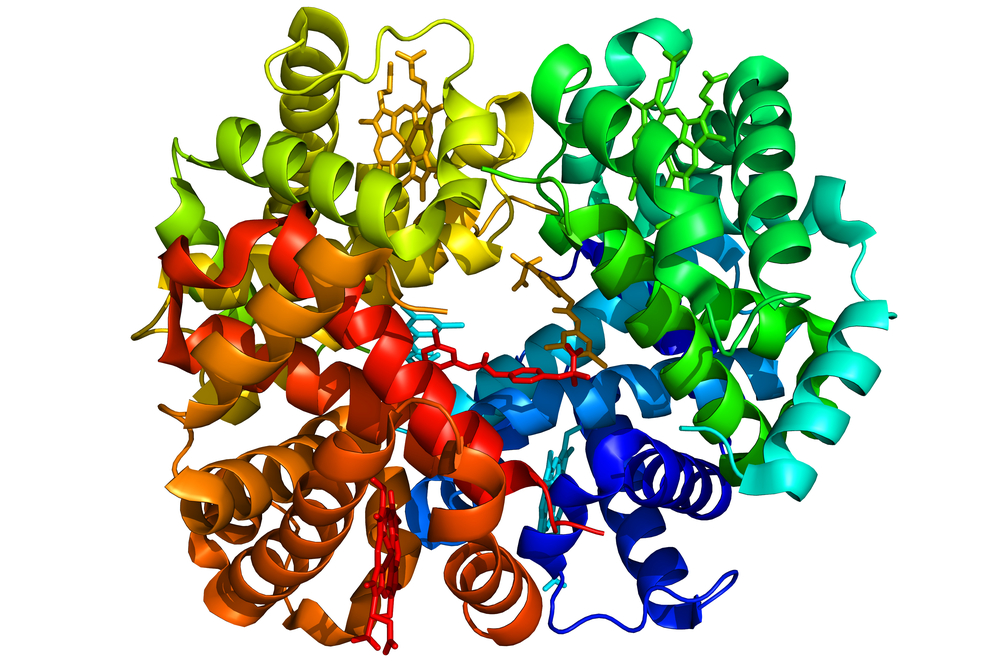

Un grupo de destacados científicos ha lanzado una iniciativa voluntaria que esboza un conjunto de valores, principios y compromisos para el diseño de proteínas de IA.

En carta analiza el posible uso indebido de herramientas de IA capaces de diseñar nuevas proteínas con una rapidez y eficacia sin precedentes.

Aunque la IA es muy prometedora para afrontar los acuciantes retos mundiales, desde la respuesta a pandemias hasta soluciones energéticas sostenibles, también plantea interrogantes sobre la posibilidad de un uso malintencionado, como la creación de nuevas armas biológicas.

Mientras que las proteínas diseñadas por el sistema AlphaFold de DeepMind y posteriormente por los investigadores de la Facultad de Medicina de la Universidad de Washington demostraron una gran afinidad y especificidad con los objetivos previstos, siempre existe la posibilidad de que estas proteínas interactúen con otras moléculas del organismo de forma inesperada.

Esto podría provocar efectos secundarios adversos o incluso el desarrollo de nuevas enfermedades.

Otro riesgo es el posible uso indebido o malintencionado de esta tecnología. Del mismo modo que las proteínas diseñadas por la IA pueden utilizarse para crear terapias muy específicas, también podrían diseñarse para causar daños.

Por ejemplo, un agente malicioso podría diseñar una proteína dirigida a un grupo étnico específico o explotar una vulnerabilidad genética concreta.

Como señala David Baker, biofísico computacional de la Universidad de Washington y figura clave de la iniciativa, "La pregunta era: ¿cómo, si es que de alguna manera, debe regularse el diseño de proteínas y cuáles son los peligros, si es que los hay?".

Los más de 100 firmantes creen que "los beneficios de las actuales tecnologías de IA para diseño de proteínas superan con creces el potencial de daño", pero reconocen la necesidad de un enfoque proactivo de la gestión de riesgos a medida que avanza la tecnología.

La IA para la biología tiene el potencial de ayudar a resolver algunos de los problemas más importantes a los que se enfrenta nuestra sociedad. La apertura científica será fundamental para que nuestro campo progrese. Como científicos comprometidos con este trabajo, con más de 90 signatarios en todo el mundo, estamos avanzando en un marco... pic.twitter.com/4m81j87Vo9

- Alex Rives (@alexrives) 8 de marzo de 2024

La carta afirma que "dados los avances previstos en este campo, puede ser necesario un nuevo enfoque proactivo de gestión de riesgos para mitigar el potencial de desarrollo de tecnologías de IA que podrían ser mal utilizadas, intencionadamente o no, para causar daño".

Firmado.

Una buena idea para la seguridad en el diseño de proteínas (con o sin IA): regular y controlar las máquinas de síntesis de proteínas y el firmware, no la propia investigación con IA.

Esta es una idea que promoví en la Cumbre de Seguridad de la IA del Reino Unido. https://t.co/skcUUcgG5a- Yann LeCun (@ylecun) 8 de marzo de 2024

En el marco de la iniciativa, los investigadores articularon una serie de valores y principios para guiar el desarrollo responsable de las tecnologías de IA en el diseño de proteínas.

Entre ellos figuran "la seguridad, la protección, la equidad, la colaboración internacional, la apertura, la responsabilidad y la búsqueda de la investigación en beneficio de la sociedad". Los firmantes también han acordado voluntariamente una serie de compromisos específicos y viables basados en estos valores y principios.

Un aspecto clave de la iniciativa se centra en mejorar el cribado de la síntesis de ADN, un paso crucial para traducir las proteínas diseñadas por IA en moléculas físicas.

Los científicos se comprometen a "obtener servicios de síntesis de ADN sólo de proveedores que demuestren su adhesión a las prácticas de control de bioseguridad estándar de la industria, que tratan de detectar biomoléculas peligrosas antes de que puedan ser fabricadas."

Los avances de la IA en medicina y biotecnología han sido increíbles y han dado lugar a nuevos antibióticos y medicamentos antienvejecimiento.

Para impulsar estas conclusiones, los firmantes se comprometen a "trabajar en colaboración con las partes interesadas de todo el mundo" y a "abstenerse de realizar investigaciones que puedan provocar daños generales o permitir un uso indebido de nuestras tecnologías".