NVIDIA ha publicado Chat with RTX como demostración técnica de cómo los chatbots de IA pueden ejecutarse localmente en PC Windows utilizando sus GPU RTX.

El enfoque estándar para utilizar un chatbot de IA es utilizar una plataforma web como ChatGPT o ejecutar consultas a través de una API, con la inferencia que tiene lugar en los servidores de computación en nube. Los inconvenientes son los costes, la latencia y los problemas de privacidad derivados de la transferencia de datos personales o corporativos de un lado a otro.

RTX de NVIDIA de GPU permite ahora ejecutar un LLM localmente en tu PC Windows aunque no estés conectado a Internet.

Chat con RTX permite a los usuarios crear un chatbot personalizado utilizando Mistral o Llama 2. Utiliza la generación aumentada por recuperación (RAG) y el software TensorRT-LLM de NVIDIA para optimizar la inferencia.

Puedes dirigir Chat con RTX a una carpeta de tu PC y luego hacerle preguntas relacionadas con los archivos de la carpeta. Admite varios formatos de archivo, como .txt, .pdf, .doc/.docx y .xml.

Dado que el LLM analiza archivos almacenados localmente con inferencia en su máquina, es realmente rápido y ninguno de sus datos se comparte en redes potencialmente inseguras.

También puedes indicarle la URL de un vídeo de YouTube y hacerle preguntas sobre el vídeo. Eso requiere acceso a Internet, pero es una buena forma de obtener respuestas sin tener que ver un vídeo largo.

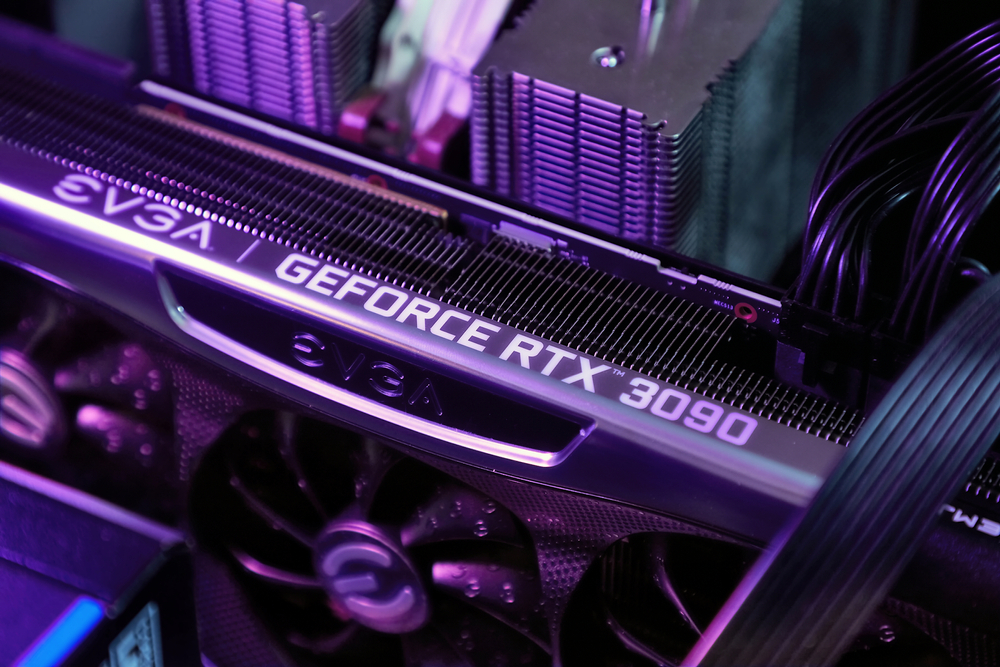

Puede descargar Chat con RTX de forma gratuita, pero necesitarás ejecutar Windows 10 u 11 en tu PC con una GPU GeForce RTX Serie 30 o superior, con un mínimo de 8 GB de VRAM.

Chat con RTX es una demo, más que un producto terminado. Tiene algunos fallos y no recuerda el contexto, por lo que no puedes hacerle preguntas de seguimiento. Pero es un buen ejemplo de cómo utilizaremos los LLM en el futuro.

El uso local de un chatbot de IA sin costes de llamadas a la API y con muy poca latencia es probablemente la forma en que la mayoría de los usuarios acabarán interactuando con los LLM. El enfoque de código abierto que han adoptado empresas como Meta hará que la IA en el dispositivo impulse la adopción de sus modelos gratuitos en lugar de los propietarios como GPT.

Dicho esto, los usuarios de móviles y portátiles tendrán que esperar todavía un tiempo antes de que la potencia de cálculo de una GPU RTX quepa en dispositivos más pequeños.