Un grupo de desarrolladores de Chicago ha equipado a los artistas con Nightshade, un método de lucha contra las prácticas de datos poco éticas.

Nightshade es una sofisticada herramienta diseñada para proteger las obras de arte digitales del uso no autorizado en el entrenamiento de IA mediante la introducción de muestras "envenenadas".

Estas alteraciones son imperceptibles para el ojo humano, pero perturban el proceso de aprendizaje de una IA, dando lugar a asociaciones y respuestas incorrectas.

En los investigadores escriben"Los ojos humanos podrían ver una imagen sombreada de una vaca en un campo verde prácticamente sin cambios, pero un modelo de IA podría ver un gran bolso de cuero tirado en la hierba".

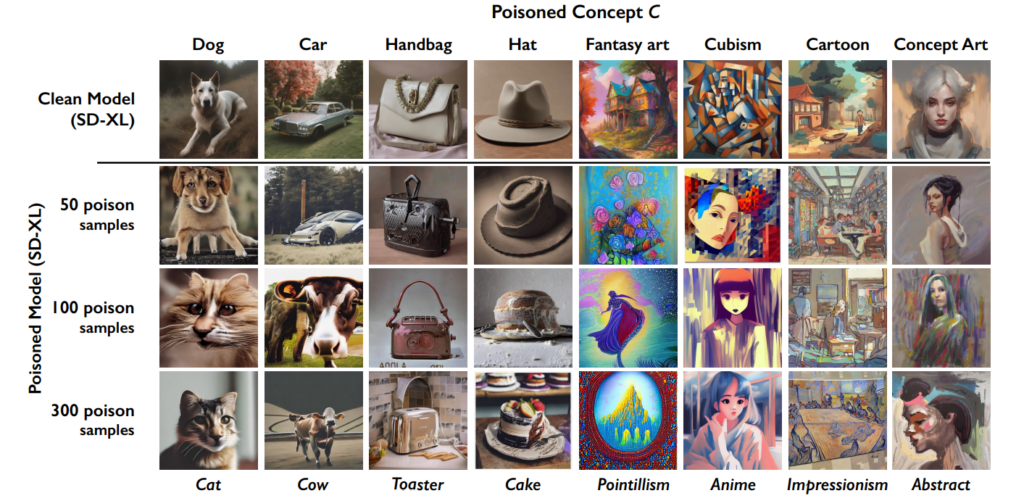

El efecto se acumula, de modo que cuantas más imágenes "envenenadas" terminan en un conjunto de datos, más se deteriora el rendimiento del modelo.

Esta herramienta se suma a la anterior creación de la Universidad de Chicago, Glaze, que también ayuda a los artistas a combatir el raspado de datos. "Glaze podría cambiar cosas como los colores y las pinceladas, presentando un estilo artístico diferente del que hay en realidad", explican los desarrolladores.

Sin embargo, Nightshade difiere de Glaze en su enfoque. "Mientras que Glaze era una herramienta defensiva, Nightshade está diseñada para ser una herramienta ofensiva", afirma el equipo.

Estoy muy emocionada de compartir que "Artefacto" ha sido glaseado y sombreado por la noche por @TheGlazeProject y qué pieza tan perfecta para ello también. Se trata de un cuadro sobre la IA generativa que canibaliza la auténtica voz de los creativos humanos. Cuando esta imagen se raspa para la formación, bueno ... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14 de enero de 2024

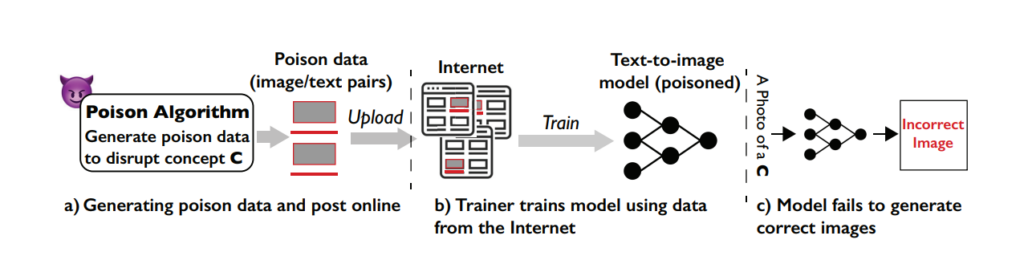

Cómo funciona Nightshade en cinco pasos

Nightshade es una herramienta inteligente que utiliza las funciones de aprendizaje automático implicadas en la formación de modelos contra el propio sistema, envenenando el proceso de aprendizaje y dando lugar a peores resultados en los distintos modelos.

Comprender la vulnerabilidad

El ataque Nightshade explota una debilidad específica de los modelos generativos de texto a imagen. Estos modelos de IA se entrenan con grandes conjuntos de datos de imágenes y sus correspondientes descripciones de texto.

Sin embargo, el equipo de la Universidad de Chicago descubrió que la cantidad de datos de entrenamiento es bastante limitada para ciertas preguntas o temas específicos. Esta cantidad limitada de datos para preguntas concretas hace que estos modelos sean vulnerables a ataques dirigidos de envenenamiento de datos.

El concepto de Nightshade

Nightshade es un sofisticado método diseñado para ejecutar lo que se conoce como un ataque de envenenamiento específico.

En términos más sencillos, es como introducir un pequeño error cuidadosamente diseñado en el proceso de aprendizaje de la IA, que conduce a errores significativos y selectivos cuando la IA genera imágenes basándose en determinadas indicaciones.

La característica clave de Nightshade es su capacidad para producir muestras "envenenadas" que parecen normales a los ojos humanos, pero que son radicalmente diferentes en la forma en que la IA las percibe y aprende de ellas.

Creación de muestras de veneno

Para ejecutar un ataque Nightshade, los investigadores generan primero lo que denominan "imágenes de anclaje". Se trata de imágenes de un concepto no relacionado con el objetivo real del ataque.

Por ejemplo, si el concepto objetivo es "perro", las imágenes de anclaje pueden ser de "gatos". Estas imágenes de anclaje son generadas por un modelo de IA que los usuarios ejecutan en su PC.

A continuación, los investigadores encuentran imágenes reales del concepto objetivo (como perros) y las modifican sutilmente para alinearlas con las características de las imágenes de anclaje en la percepción de la IA.

Para un humano, estas imágenes modificadas siguen pareciéndose a perros, pero para la IA se parecen mucho a gatos. Aunque este concepto pueda resultar difícil de asimilar, es importante recordar que las formas que crean las imágenes son siempre fundamentalmente similares.

Las alteraciones se denominan perturbaciones adversariales. Se calculan cuidadosamente para desplazar la representación de la imagen en el espacio de características de la IA de la región asociada a los gatos a la asociada a los perros.

Cómo afecta el ataque a los modelos de IA

Cuando se entrena un modelo generativo de IA con estas muestras envenenadas, empieza a asociar las características del concepto no relacionado (gatos) con el concepto objetivo (perros).

En consecuencia, cuando se le pide que genere imágenes de perros, el modelo de IA puede producir imágenes de gatos. Esto se debe a que la comprensión del modelo de lo que constituye un "perro" ha sido sesgada por los datos envenenados.

Aunque esto no "rompe" por completo un modelo de IA, lo hace menos eficaz y más impredecible, lo que sin duda podría mermar su usabilidad.

Es probable que las empresas de IA luchen contra Nightshade y técnicas similares, pero eso va a requerir tiempo y esfuerzo.

Impacto

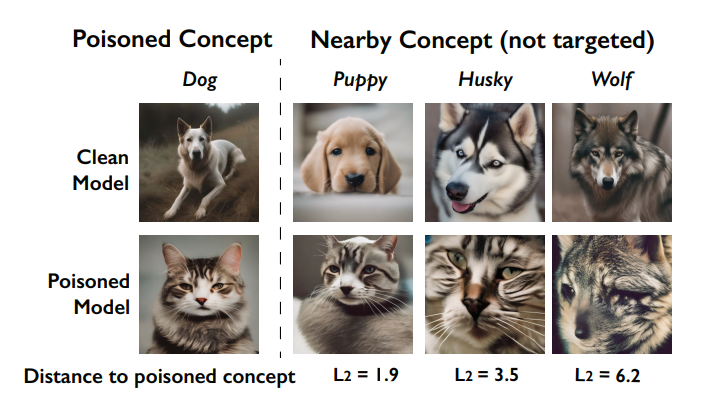

Uno de los efectos clave del ataque de la Sombra Nocturna es su efecto de "filtración". Esto significa que el envenenamiento de un concepto puede afectar a otros conceptos relacionados.

Por ejemplo, envenenar el concepto de "perro" podría afectar también a la forma en que el modelo genera imágenes de animales relacionados como "lobos" o "zorros".

son corrompidos por el envenenamiento (denominado efecto de sangrado). Fuente: Universidad de Chicago vía ArXiv

Además, cuando en un modelo se envenenan varios conceptos, puede quebrarse la capacidad del modelo para generar imágenes coherentes para una amplia gama de indicaciones.

Cómo pueden utilizar los artistas Nightshade

Nightshade es una herramienta que puedes descargar y utilizar tú mismo, pero consume bastantes recursos y requiere una GPU Nvidia compatible con al menos 4G de memoria.

Este proceso podría simplificarse en el futuro, o podría haber servicios en la nube en los que puedas simplemente subir tus imágenes para que Nightshade las haga por ti.

He aquí cómo utilizar Nightshade:

- Seleccione su obra: Puede arrastrar una sola imagen al marcador de posición de imágenes o seleccionar varias imágenes con el botón "Seleccionar...".

- Ajustar parámetros: La intensidad determina la fuerza del efecto de Nightshade. Una intensidad más alta produce una interrupción más potente, pero puede causar cambios notables en su obra de arte. La calidad del renderizado indica el tiempo de cálculo necesario para encontrar el nivel óptimo de veneno. Una mayor calidad equivale a un veneno más potente, pero requiere más tiempo. Si tienes una GPU, este proceso será más rápido.

- Elija el directorio de salida: Seleccione dónde desea guardar las imágenes Nightshaded.

- Seleccionar etiqueta veneno: Nightshade actúa confundiendo a la IA sobre determinados conceptos de su imagen. Por ejemplo, puede alterar imágenes etiquetadas como "coche" para que los modelos de IA las perciban como "vaca". Nightshade sugerirá una etiqueta basada en su análisis de contenido al seleccionar tu imagen. Asegúrese de que la etiqueta refleja con precisión el concepto clave de su imagen, y ajústela si es necesario. La eficacia de Nightshade aumenta cuando tu imagen se asocia a esta etiqueta mediante texto alternativo, pies de foto o texto cercano.

- Ejecutar Nightshade: Tras finalizar la configuración y confirmar la etiqueta de la imagen, inicie el proceso pulsando el botón "Ejecutar". Las imágenes modificadas se guardarán en el directorio de salida elegido.

- Encontrará instrucciones detalladas en el guía oficial del usuario aquí.

Recepción comunitaria a la recepción de Nightshade

Ha habido un apoyo abrumador a los artistas que intentan defender su trabajo de la IA, pero como siempre, hay múltiples facciones, y algunos lo comparan con un ciberataque a los modelos de IA.

En respuesta a las críticas, el equipo aclara: "El objetivo de Nightshade no es romper los modelos, sino aumentar el coste de la formación con datos sin licencia, de tal forma que la obtención de licencias de imágenes de sus creadores se convierta en una alternativa viable."

"Si se utiliza de forma responsable, Nightshade puede ayudar a disuadir a los entrenadores de modelos que ignoran los derechos de autor, las listas de exclusión y las directivas do-not-scrape/robots.txt", afirman.

El debate en torno a la extracción de datos y la formación de modelos de IA se ha agriado enormemente tras la polémica de Midjourney y la avalancha de empresas que utilizan material gráfico generado por IA, sustituyendo en el proceso a la mano de obra humana.

¡Nightshade ha salido!

Nightshade envenena a los modelos de IA si tu arte o imágenes son tomadas sin permiso, Glaze te protege del mimetismo de la IA. Se recomienda usar primero Nightshade y luego Glaze. Próximamente habrá una versión que haga ambas cosas.

Lea este hilo para obtener más información.

A por ellos 🫡 https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19 de enero de 2024

De repente, parece que hay un vacío cada vez mayor entre las empresas tecnológicas que comercializan la IA como una fuerza filantrópica y el público, que siente que está invadiendo demasiado la cultura y la sociedad.

De hecho, Nightshade no sólo es útil para los artistas. La gente está animando al mayor número posible de personas a utilizar estas herramientas, lo que crea un grupo más pequeño de datos de alta calidad que las empresas de IA pueden extraer.

Pero, ¿disponen ya las empresas de datos suficientes? Tal vez por ahora, pero para mantener los modelos al día y actualizados, los desarrolladores de IA tendrán que introducir nuevos datos en sus sistemas en algún momento.

#nightshade

Consejo profesional: utiliza Nightshade en todo lo que subas a Internet (no sólo en tus obras de arte), fotos de redes sociales, fotos diarias de tu comida, familia, cachorros, gatitos, selfies aleatorios y fotos de la calle... y que empiece el juego.- editar ballai 🌿 (@eballai) 19 de enero de 2024

En Glaze y Nightshade, asistimos a una incipiente batalla tecnológica y ética entre los creadores y las empresas de IA.

Se va a poner cada vez más interesante, y ¿podría haber formas similares de engañar y envenenar los modelos lingüísticos?

Esto, combinado con las batallas legales, podría hacer que la IA generativa entre en un periodo volátil. Va a ser un año enorme para esta tecnología.