En 1956, Philip K. Dick escribió una novela titulada "The Minority Report" (El informe de la minoría), que narraba un futuro en el que los "precogs" podían prever los crímenes antes de que ocurrieran en la realidad.

Unas décadas más tarde, Tom Cruise llevó esta inquietante visión a la gran pantalla, persiguiendo a posibles criminales basándose en estas predicciones.

Ambas versiones nos obligaron a contemplar las implicaciones éticas de ser detenido por algo que podrías hacer en el futuro.

En la actualidad, a medida que los métodos policiales predictivos se abren camino en las fuerzas del orden modernas, cabe preguntarse: ¿estamos a punto de hacer realidad el clarividente relato de Dick?

¿Qué es la policía predictiva y cómo funciona?

La policía predictiva combina la aplicación de la ley y la analítica avanzada, aprovechando el aprendizaje automático para anticiparse a las actividades delictivas antes de que se produzcan.

Sobre el papel, la premisa es bastante sencilla: si somos capaces de descifrar las pautas ocultas en los datos históricos sobre delincuencia, podremos elaborar algoritmos para predecir sucesos futuros.

El proceso comienza con la recopilación de registros históricos de delitos, fuentes de vigilancia, conversaciones en redes sociales e incluso matices como las fluctuaciones meteorológicas. A continuación, este vasto repositorio de información se introduce en sofisticados modelos de aprendizaje automático diseñados para discernir patrones subyacentes.

Por ejemplo, el modelo podría discernir que en un barrio concreto se produce un repunte de los robos en las noches lluviosas de fin de semana.

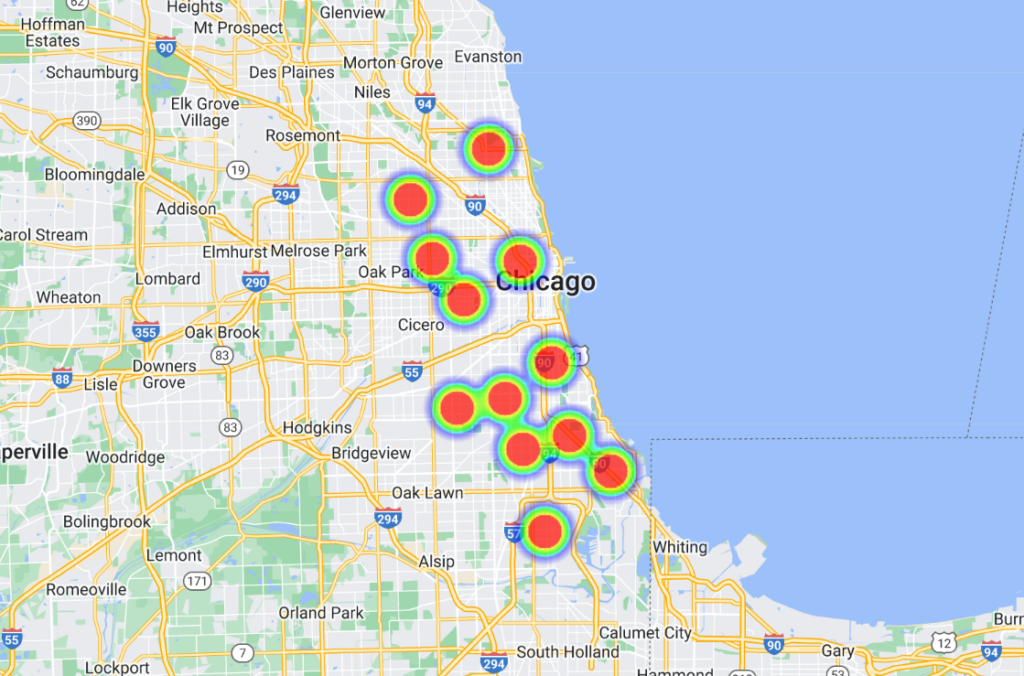

Una vez extraídas estas correlaciones, las plataformas informáticas avanzadas las transforman en representaciones visuales, a menudo parecidas a "mapas de calor" que ponen de relieve los probables focos de delincuencia. Esto, a su vez, permite a la policía asignar sus recursos de forma proactiva, optimizando sus patrullas e intervenciones.

Algunos modelos han ido un paso más allá y enumeran a las personas por nombre y dirección, dotando a los agentes de predicciones muy específicas y localizadas.

Historia de la policía predictiva

La tecnología policial predictiva es aún embrionaria, y aunque ha habido algunos actores influyentes en el sector, como Palantir, la industria es pequeña.

En junio de 2022, la Universidad de Chicago desarrolló un modelo de IA capaz de prever la localización y los índices de delincuencia en la ciudad con una supuesta precisión de 90%.

A partir de datos abiertos sobre delincuencia de 2014 a 2016, el equipo dividió Chicago en cuadrículas de aproximadamente 300 metros. El modelo podía predecir, con una semana de antelación, la plaza con mayor probabilidad de que se produjera un delito.

El estudio tenía intenciones honestas, al desvelar sesgos espaciales y socioeconómicos en los esfuerzos policiales y la asignación de recursos. Se descubrió que los barrios acomodados recibían más recursos que las zonas de ingresos más bajos.

En palabras del estudio: "Aquí demostramos que, si bien los modelos predictivos pueden aumentar el poder del Estado a través de la vigilancia criminal, también permiten la vigilancia del Estado al rastrear sesgos sistémicos en la aplicación de la ley penal."

Además, el modelo se entrenó con datos de otras siete ciudades estadounidenses, con resultados similares. Todos los conjuntos de datos y algoritmos están disponibles en GitHub.

Chicago es un importante ejemplo de actuación policial basada en datos y asistida por IA. Otro ejemplo es la mapa de calor de la delincuencia armadaque identifica los "puntos calientes" de la delincuencia que pueden incorporarse a los esfuerzos policiales.

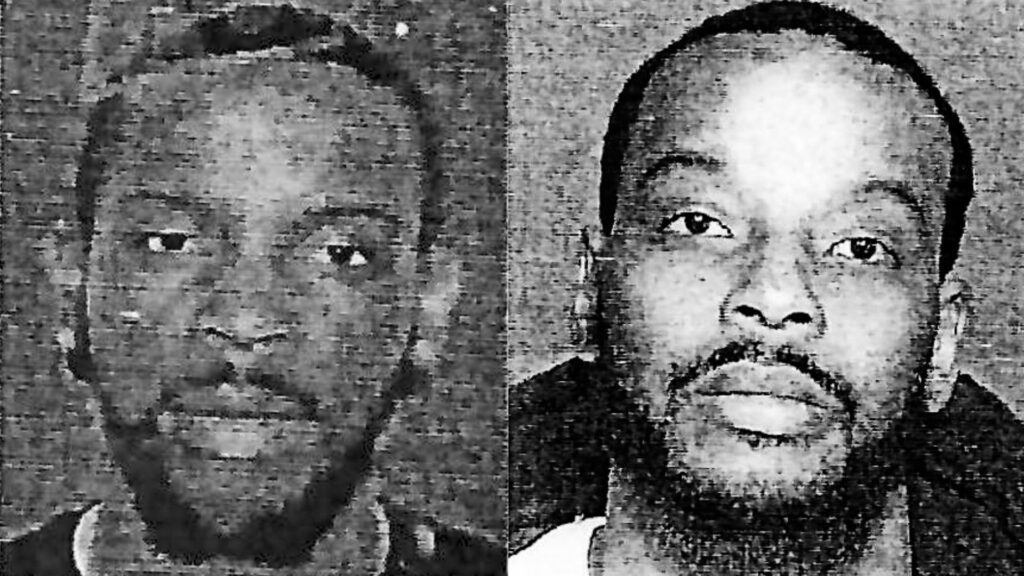

Un incidente notable allá por 2013 -en los inicios de la policía predictiva-. implicó a Robert McDanielsresidente en el distrito Austin de Chicago, donde se cometen 90% de los delitos con armas de fuego de la ciudad.

A pesar de sus antecedentes no violentos, la inclusión de McDaniel en una lista de delincuentes potencialmente violentos hizo que se convirtiera en dos ocasiones en objetivo de la violencia armada, al presentarse la policía en su puerta y convertirlo en objetivo.

Una investigación de The Verge afirma que un periodista del Chicago Tribune se puso en contacto con McDaniel en relación con la "lista caliente", un nombre no oficial que la policía asignó a los algoritmos que etiquetan a los posibles tiradores y objetivos.

Ishanu Chattopadhyay, investigador principal del proyecto 2022 Chicago proyecto de predicción de la delincuenciaEn su opinión, su modelo predice lugares, no individuos. "No es Minority Report", dijo, pero el caso McDaniels tiene algunos paralelismos.

En respuesta a la preocupación por la parcialidad, Chattopadhyay señaló que omitieron intencionadamente las infracciones leves de tráfico y drogas denunciadas por los ciudadanos, centrándose en los delitos violentos y contra la propiedad denunciados con más frecuencia.

Sin embargo, sos estudios demuestran que los individuos negros son denunciados con más frecuencia por delitos que sus homólogos blancos. En consecuencia, los barrios negros son injustamente etiquetados como de "alto riesgo".

Además, la intensificación de la vigilancia policial en una zona se traduce en más denuncias de delitos, lo que crea un bucle de retroalimentación que distorsiona la percepción de la delincuencia.

Entonces, basarse en datos del pasado puede perpetuar los estereotipos y pasar por alto el potencial de cambio y rehabilitación.

¿Cómo le ha ido a la policía predictiva?

Como era de esperar, la policía predictiva es muy controvertida, pero ¿funciona o cumple su propósito básico?

Una investigación de octubre de 2023 de El marcado y el cableado revelaron fallos flagrantes, que se suman a un creciente volumen de pruebas que ponen de relieve los peligros y deficiencias de transferir la toma de decisiones policiales a las máquinas.

El programa en cuestión es Geoliticaun software policial predictivo utilizado por la policía de Plainfield (Nueva Jersey). Cabe señalar que el departamento de policía de Plainfield fue el único de 38 departamentos dispuesto a compartir datos con los medios de comunicación.

Anteriormente conocido como PredPolEste software de aprendizaje automático fue adquirido por varios departamentos de policía.

The Markup y Wired analizaron 23.631 de las predicciones de Geolitica de febrero a diciembre de 2018. De ellas, menos de 100 predicciones coincidieron con casos reales de delincuencia, lo que se tradujo en una tasa de acierto inferior al medio por ciento.

Estos modelos de predicción siempre han sido polémicos, ya que plantean numerosas cuestiones éticas en relación con su potencial para reforzar los prejuicios discriminatorios y racistas que prevalecen en la IA y en la aplicación de la ley.

Esta reciente investigación pone de relieve dilemas éticos y cuestiona la eficacia del software para predecir delitos.

Aunque el programa mostró ligeras variaciones en la precisión de las predicciones según el tipo de delito (por ejemplo, predijo correctamente el 0,6% de los robos o agresiones con agravantes, frente al 0,1% de los robos con allanamiento de morada), el panorama general sigue siendo el de un rendimiento muy por debajo de lo esperado.

La sincera respuesta del capitán de la policía de Plainfield, David Guarino, arroja luz sobre la realidad del terreno. "¿Por qué adquirimos PredPol? Queríamos mejorar nuestra eficacia en la reducción de la delincuencia", comentó.

"No estoy seguro de que lo consiguiera. Rara vez o nunca lo utilizamos". También mencionó que el departamento de policía dejó de utilizarlo.

El capitán Guarino sugirió que los fondos asignados a Geolitica -que ascendían a una cuota de suscripción anual de $20.500 más $15.500 adicionales para un segundo año- podrían haberse invertido de forma más eficaz en programas centrados en la comunidad.

Geolitica cerrará a finales de año.

Pruebas que documentan la parcialidad de la actuación policial predictiva

La promesa de la policía predictiva sigue siendo tentadora, sobre todo porque las fuerzas policiales están cada vez más sobrecargadas y la calidad de la toma de decisiones de la policía humana está en entredicho.

Las fuerzas policiales de Estados Unidos, Reino Unido y varios países europeos, entre ellos Francia, se enfrentan a un escrutinio por sus prejuicios hacia los grupos minoritarios.

Miembros de la Cámara de los Lores y de los Comunes del Reino Unido instan a una interrupción temporal sobre el despliegue de tecnología de reconocimiento facial en vivo por parte de la policía.

La noticia surgió después de que el ministro de Policía, Chris Philip, debatiera conceder a las fuerzas policiales acceso a 45 millones de imágenes de la base de datos de pasaportes para el reconocimiento facial policial. Hasta el momento, 65 parlamentarios y 31 organizaciones de defensa de los derechos y la igualdad racial se oponen al uso de tecnologías de reconocimiento facial en la actuación policial.

El grupo de defensa Observatorio Gran Hermano afirmó que 89% de las alertas de reconocimiento facial de la policía del Reino Unido fracasan en su propósito, con resultados desproporcionadamente peores para los grupos étnicos minoritarios y las mujeres. Un ensayo de reconocimiento facial realizado en 2018 por la Policía Metropolitana de Londres obtuvo un pésimo de éxito de sólo unos 2%.

Como Michael Birtwistle, del Instituto Ada Lovelace, descrito"La precisión y la base científica de las tecnologías de reconocimiento facial son muy discutidas, y su legalidad es incierta".

En Estados Unidos, un proyecto de colaboración en el que participan la Universidad de Columbia, el AI Now Institute y otras instituciones analizó recientemente los litigios de los tribunales estadounidenses en los que intervienen algoritmos.

El estudio constató que los sistemas de IA se aplicaban a menudo de forma precipitada, sin una supervisión adecuada, principalmente para reducir costes. Desgraciadamente, estos sistemas solían dar lugar a problemas constitucionales debido a sesgos inherentes.

Al menos cuatro hombres de raza negra han sido detenidos y/o encarcelados por error a la espera de coincidencias faciales incorrectas en EE.UU., entre ellos Parques Nijeerfalsamente acusado de hurto en tiendas y de infracciones de tráfico a pesar de encontrarse a 30 millas de distancia de los supuestos incidentes. Posteriormente pasó diez días en la cárcel y tuvo que pagar miles de euros en honorarios de abogados.

En concluyen los autores del estudioEstos sistemas de IA se implantaron sin una formación, apoyo o supervisión significativos, y sin ninguna protección específica para los beneficiarios. Esto se debió en parte al hecho de que se adoptaron para producir ahorros de costes y estandarización bajo un modelo monolítico de tecnología-contratación, que rara vez tiene en cuenta las preocupaciones de responsabilidad constitucional."

La policía predictiva puede fomentar la toma de decisiones antinaturales

Incluso cuando la policía predictiva es precisa, los humanos tienen que actuar en función de las predicciones, que es donde las cosas se complican.

Cuando un algoritmo dice a la policía que tiene que estar en un lugar porque se está cometiendo o es probable que se cometa un delito, no es ni mucho menos inviable pensar que esto distorsiona la toma de decisiones.

Hay algunas teorías psicológicas básicas que convendría confrontar al considerar el papel de la IA en la labor policial.

En primer lugar, cuando un algoritmo informa a la policía de una posible escena del crimen, puede predisponerla a ver la situación desde el punto de vista de la expectación. Esto podría haber influido en el incidente de McDaniels: la policía llegó al lugar esperando que se produjera un incidente, lo que desencadenó una escalada de los acontecimientos en un entorno volátil.

Esto tiene su origen en el sesgo de confirmación, que sugiere que una vez que tenemos una información, tendemos a buscar e interpretar la información posterior de una manera que se alinea con esa creencia inicial.

Cuando un algoritmo le dice a alguien que es probable que se produzca un delito, inconscientemente puede dar más importancia a los indicios que confirman esta predicción y pasar por alto los que la contradicen.

Por otra parte, los algoritmos, especialmente los utilizados en el ejercicio de funciones oficiales, pueden considerarse autorizados debido a su naturaleza computacional, y los funcionarios podrían depositar en ellos una confianza indebida.

Y luego está el riesgo de la falta de compromiso moral. Los agentes pueden trasladar la responsabilidad de sus acciones al algoritmo, pensando que es el software el que ha tomado la decisión, no ellos, lo que también es muy relevante en el ámbito bélico.

Los debates son paralelos a los que rodean Uso de la IA en el campo de batallaque plantea dilemas similares.

La autoridad impuesta por la IA puede dar lugar a una "brecha en la rendición de cuentas" en la que nadie se responsabiliza de los errores cometidos por la IA, tal y como destacan Kate Crawford y Jason Schultz en un reciente Artículo JSTOR.

En definitiva, según las pruebas de que disponemos actualmente, la actuación policial predictiva a menudo perpetúa los prejuicios en lugar de reducirlos.

Cuando las predicciones se combinan con la toma de decisiones humanas, los impactos son potencialmente catastróficos.