A medida que aumentan las conversaciones sobre los riesgos de los sistemas de IA, no podemos pasar por alto la presión que la tecnología ejerce sobre los suministros de energía y agua del mundo, ya de por sí sobrecargados.

Los proyectos complejos de aprendizaje automático (ML) dependen de una constelación de tecnologías, incluido el hardware de entrenamiento (GPU) y el hardware para alojar e implantar modelos de IA.

Aunque las técnicas y arquitecturas eficientes de entrenamiento de la IA prometen reducir el consumo de energía, el boom de la IA no ha hecho más que empezar y las grandes tecnológicas están aumentando la inversión en centros de datos y tecnología en la nube que consumen muchos recursos.

A medida que se agrava la crisis climática, es más importante que nunca encontrar un equilibrio entre el avance tecnológico y la eficiencia energética.

Retos energéticos para la IA

El consumo de energía de la IA ha aumentado con la llegada de arquitecturas complejas y costosas desde el punto de vista computacional, como las redes neuronales.

Por ejemplo, se rumorea que GPT-4 se basa en 8 modelos con 220.000 millones de parámetros cada uno, lo que suma un total de 1,76 billones de parámetros. Actualmente, Inflection está construyendo un clúster de 22.000 chips Nvidia de gama altaque podría costar unos $550.000.000 a un precio aproximado de venta al público de $25.000 por tarjeta. Y eso solo por los chips.

Cada modelo avanzado de IA requiere inmensos recursos para entrenarse, pero hasta hace poco era difícil comprender con precisión el verdadero coste del desarrollo de la IA.

A Estudio 2019 de la Universidad de Massachusetts en Amherst investigaron el consumo de recursos asociado a los enfoques de redes neuronales profundas (DNN).

Normalmente, estas DNN requieren que los científicos de datos diseñen manualmente o utilicen la Búsqueda de Arquitectura Neuronal (NAS) para encontrar y entrenar una red neuronal especializada desde cero para cada caso único.

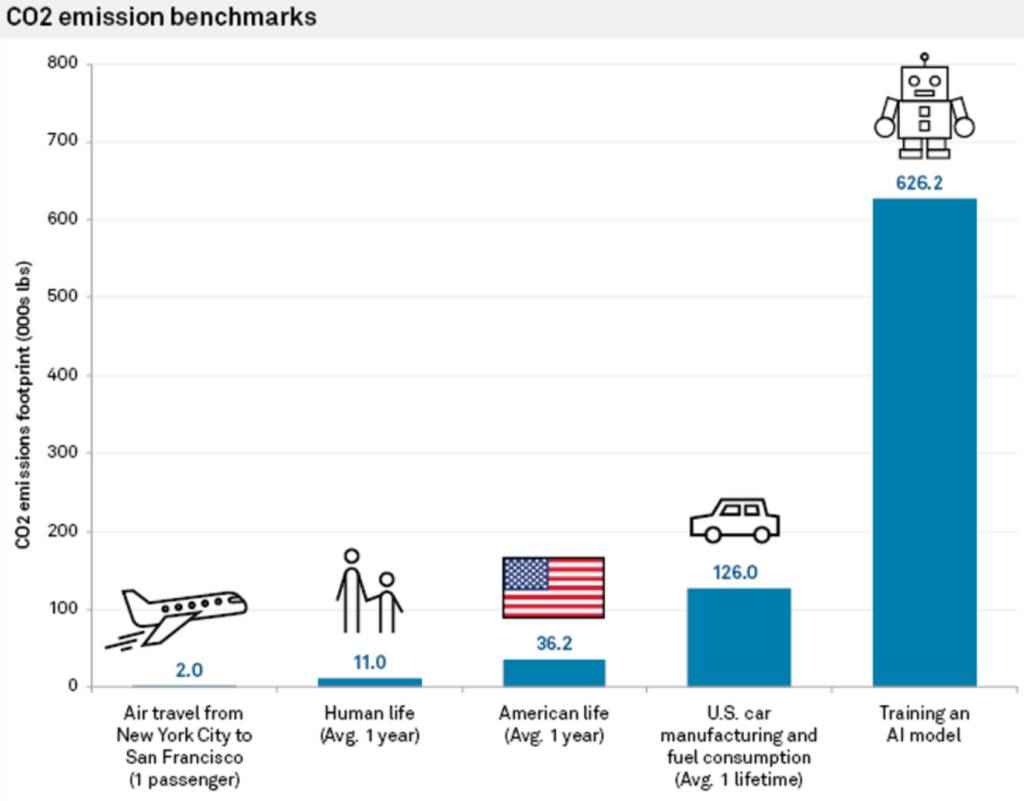

Este método no sólo consume muchos recursos, sino que también tiene una importante huella de carbono. El estudio descubrió que el entrenamiento de una sola gran red neuronal basada en Transformer, construida con NAS -una herramienta empleada habitualmente en traducción automática- generaba alrededor de 626.000 libras de dióxido de carbono.

Esto equivale aproximadamente a las emisiones de gases durante la vida útil de 5 coches.

Carlos Gómez-Rodríguez, informático de la Universidad de A Coruña (España), comentó sobre el estudio: "Aunque probablemente muchos de nosotros hemos pensado en esto a un nivel abstracto y vago, las cifras muestran realmente la magnitud del problema", y añadió: "Ni yo ni otros investigadores con los que las he comentado pensábamos que el impacto ambiental fuera tan sustancial".

Los costes energéticos del entrenamiento del modelo son sólo valores de referencia, es decir, la cantidad mínima de trabajo necesaria para que un modelo sea operativo.

Como dice Emma Strubell, candidata al doctorado en la Universidad de Massachusetts: "Entrenar un solo modelo es el mínimo trabajo que se puede hacer".

El enfoque "de una vez por todas" del MIT

Más tarde, investigadores del MIT propusieron una solución a este problema: la Enfoque "de una vez por todas" (OFA).

Los investigadores describa la cuestión con el entrenamiento convencional de redes neuronales: "Diseñar redes neuronales especializadas para cada escenario es costoso desde el punto de vista técnico y computacional, ya sea con métodos basados en humanos o en NAS. Dado que estos métodos necesitan repetir el proceso de diseño de la red y volver a entrenar la red diseñada desde cero para cada caso, su coste total crece linealmente a medida que aumenta el número de escenarios de despliegue, lo que se traducirá en un consumo excesivo de energía y emisiones de CO2."

Con el paradigma OFA del MIT, los investigadores entrenan una única red neuronal de propósito general a partir de la cual pueden crearse varias subredes especializadas. El proceso OFA no requiere formación adicional para las nuevas subredes, lo que reduce las horas de GPU de alto consumo energético necesarias para la formación de modelos y disminuye las emisiones de CO2.

Además de sus ventajas medioambientales, el enfoque OFA ofrece mejoras sustanciales de rendimiento. En pruebas internas, los modelos creados con el enfoque OFA funcionaron hasta 2,6 veces más rápido en dispositivos periféricos (dispositivos IoT compactos) que los modelos creados con NAS.

El enfoque OFA del MIT fue reconocido en el 4º Desafío de Visión por Computadora de Bajo Consumo en 2019 - un evento anual organizado por el IEEE que promueve la investigación para mejorar la eficiencia energética de los sistemas de visión por computadora (CV).

El equipo del MIT se llevó los máximos honores, y los organizadores del evento lo elogiaron: "Las soluciones de estos equipos superan a las mejores soluciones de la literatura".

En 2023 Reto de visión por ordenador de bajo consumo está recibiendo propuestas hasta el 4 de agosto.

El papel de la computación en nube en el impacto medioambiental de la IA

Además de los modelos de formación, los desarrolladores necesitan inmensos recursos en la nube para alojar y desplegar sus modelos.

Grandes empresas tecnológicas como Microsoft y Google están aumentando la inversión en recursos en la nube durante 2023 para hacer frente a la creciente demanda de productos relacionados con la IA.

La computación en nube y sus centros de datos asociados tienen inmensas necesidades de recursos. A partir de 2016, estimaciones sugeridas que los centros de datos de todo el mundo representaban entre 1% y 3% del consumo mundial de electricidad, lo que equivale al consumo energético de algunas naciones pequeñas.

La huella hídrica de los centros de datos también es colosal. Los grandes centros de datos pueden consumir millones de litros de agua al día.

En 2020, se informó de que los centros de datos de Google en Carolina del Sur estaban autorizados a utilizar 549 millones de galones de aguaCasi el doble que dos años antes. Un centro de datos de 15 megavatios puede consumir hasta 360.000 galones de agua al día.

En 2022, Google reveló que su parque mundial de centros de datos consumió unos 4.300 millones de galones de agua. Sin embargo, destacan que la refrigeración por agua es sustancialmente más eficiente que otras técnicas.

Todas las grandes empresas tecnológicas tienen planes similares para reducir su uso de recursos, como Google, que alcanzó su objetivo de igualar 100% de su uso de energía con compras de energía renovable en 2017.

Hardware de IA de última generación basado en el cerebro humano

La IA consume muchos recursos, pero nuestros cerebros sólo consumen 12 vatios de potencia - ¿Puede reproducirse tal eficiencia energética en la tecnología de IA?

Incluso un ordenador de sobremesa consume más de 10 veces más energía que el cerebro humano, y los modelos de IA potentes requieren millones de veces más energía. Construir una tecnología de IA capaz de replicar la eficiencia de los sistemas biológicos transformaría por completo la industria.

Para ser justos con la IA, esta comparación no tiene en cuenta el hecho de que el cerebro humano fue "entrenado" a lo largo de millones de años de evolución. Además, los sistemas de IA y los cerebros biológicos destacan en tareas diferentes.

Aun así, construir un hardware de IA capaz de procesar información con un consumo de energía similar al de los cerebros biológicos permitiría crear IA autónomas de inspiración biológica que no estuvieran acopladas a voluminosas fuentes de energía.

En 2022, un equipo de investigadores del Instituto Indio de Tecnología de Bombay, anunció el desarrollo de un nuevo chip de inteligencia artificial inspirado en el cerebro humano. El chip funciona con redes neuronales con picos (SNN), que imitan el procesamiento de señales neuronales de los cerebros biológicos.

El cerebro está formado por 100.000 millones de neuronas diminutas conectadas a miles de otras neuronas a través de sinapsis, que transmiten información mediante patrones coordinados de picos eléctricos. Los investigadores construyeron neuronas artificiales de muy bajo consumo, dotando a las SNN de corriente túnel de banda a banda (BTBT).

"Con BTBT, la corriente de túnel cuántico carga el condensador con una corriente ultrabaja, lo que significa que se necesita menos energía", explica Udayan Ganguly, del equipo de investigación.

Según el profesor Ganguly, en comparación con las neuronas de última generación implementadas en SNNs de hardware, su enfoque consigue "5.000 veces menos energía por espiga en un área similar y 10 veces menos potencia en espera en un área y energía por espiga similares".

Los investigadores demostraron con éxito su enfoque en un modelo de reconocimiento del habla inspirado en la corteza auditiva del cerebro. Las SNN podrían mejorar las aplicaciones en dispositivos compactos como teléfonos móviles y sensores IoT.

El objetivo del equipo es desarrollar un "núcleo neurosináptico de consumo extremadamente bajo y un mecanismo de aprendizaje en tiempo real en el chip, claves para las redes neuronales autónomas de inspiración biológica".

A menudo se pasa por alto el impacto medioambiental de la IA, pero resolver problemas como el consumo energético de los chips de IA también abrirá nuevas vías de innovación.

Si los investigadores pueden modelar la tecnología de la IA a partir de sistemas biológicos, que son excepcionalmente eficientes desde el punto de vista energético, esto permitiría el desarrollo de sistemas autónomos de IA que no dependan de un amplio suministro de energía ni de la conectividad de los centros de datos.