El crecimiento exponencial de los sistemas de IA está superando a la investigación y la regulación, lo que deja a los gobiernos en una posición incómoda para equilibrar ventajas y riesgos.

Las leyes tardan años en desarrollarse y ser jurídicamente vinculantes. La IA evoluciona cada semana.

Esa es la dicotomía a la que se enfrentan los líderes y políticos de la IA, con la primera norma significativa sobre IA en Occidente, la Ley de IA de la UE, prevista para 2026. Incluso hace un año, ChatGPT era solo un susurro.

Altos cargos de Estados Unidos y la UE se reunieron el 31 de mayo en Luleå (Suecia) con motivo del Consejo de Comercio y Tecnología (TTC). Margrethe Vestager, comisaria europea de Asuntos Digitales, que la semana anterior se reunió con Sundar Pichai, consejero delegado de Google, para hablar de un posible "Pacto sobre IA", afirmó: "La democracia tiene que demostrar que somos tan rápidos como la tecnología."

Los funcionarios reconocen la enorme brecha existente entre el ritmo de la tecnología y el de la legislación. Refiriéndose a la IA generativa como ChatGPT, Gina Raimondo, Secretaria de Comercio de EE.UU., dijo: "Está llegando a un ritmo como ninguna otra tecnología".

¿Qué se consiguió en la reunión del TTC?

Marcas de agua, auditorías externas, circuitos de retroalimentación... son sólo algunas de las ideas debatidas con los eurodiputados. @AnthropicAI y @sama @OpenAI para la #AI #CódigoDeConducta presentado hoy en la #TTC en #Luleå @SecRaimondo Estamos deseando debatir con socios internacionales. pic.twitter.com/wV08KDNs3h

- Margrethe Vestager (@vestager) 31 de mayo de 2023

Principalmente, los asistentes debatieron marcos no vinculantes o voluntarios en torno al riesgo y la transparencia, que se presentarán al G7 en otoño.

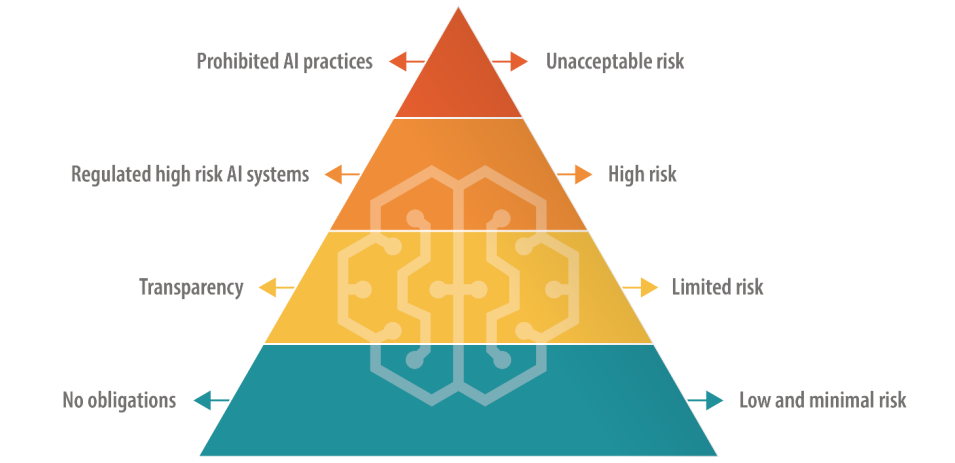

La UE, que tiene un planteamiento directo de la legislación digital, opta por un enfoque escalonado de la regulación de la IA, en el que las IA se clasifican en categorías en función del riesgo.

Esto incluye un nivel de "riesgo inaceptable" prohibido y un nivel de "alto riesgo", que los jefes tecnológicos como el CEO de OpenAI, Sam Altman, temen que comprometa la funcionalidad de sus productos.

Estados Unidos no propone una normativa tan definitiva, favorecer las normas voluntarias.

Serán necesarias muchas más reuniones entre la UE, EE.UU. y las grandes empresas tecnológicas para alinear los puntos de vista con acciones prácticas significativas.

¿Funcionarán las normas voluntarias sobre IA?

Hay muchos ejemplos de normas voluntarias en otros sectores e industrias, como los marcos voluntarios de seguridad de datos y las divulgaciones ESG, pero ninguno está tan cerca de la vanguardia como un marco voluntario de gobernanza de la IA.

Al fin y al cabo, nos enfrentamos a una amenaza de extinción, según los principales líderes tecnológicos y académicos que han firmado el documento Declaración del Center for AI Safety sobre el riesgo de la IA esta semana.

Grandes empresas como OpenAI y Google ya cuentan con departamentos centrales centrados en la gobernanza y en cuestiones de cumplimiento interno, por lo que alinear sus productos y servicios con marcos voluntarios podría ser cuestión de reescribir los documentos de política interna.

Las normas voluntarias son mejor que nada, pero con numerosas propuestas sobre la mesa, los políticos y los líderes de la IA tendrán que elegir algo con lo que correr tarde o temprano.