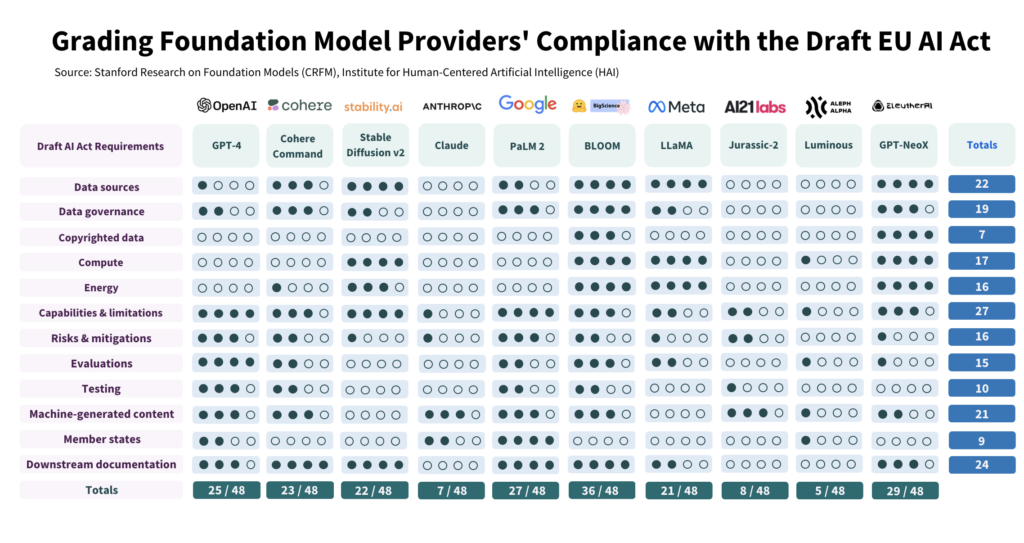

Investigadores de Stanford evaluaron el cumplimiento de la propuesta de Ley de Inteligencia Artificial de la UE por parte de 10 de los principales modelos de Inteligencia Artificial y hallaron grandes diferencias, con resultados en general mediocres.

El estudio examinó de forma crítica 10 modelos de IA con respecto a 12 criterios establecidos en el proyecto legislativo de la UE y descubrió una gran variación en el cumplimiento, sin que ningún modelo marcara todas las casillas.

El estudio pone de relieve el abismo existente entre las expectativas de la Ley de IA y los esfuerzos actuales de gobernanza entre los principales desarrolladores de IA.

Para cumplir la ley, los promotores deben mejorar enormemente su transparencia y sus estrategias de mitigación de riesgos, que en algunos casos son casi inexistentes.

Cómo se realizó el estudio

Los autores realizaron un estudio detallado de la Ley de IA, extrayendo 22 requisitos.

De ellos, seleccionaron 12 que podían evaluarse de forma significativa utilizando información pública. A continuación, crearon una rúbrica de 5 puntos para cada uno de estos 12 requisitos.

El modelo de IA de código abierto BLOOM, creado por Hugging Face, fue el que obtuvo la puntuación más alta, con un total de 36 puntos de 48 posibles.

Por el contrario, Anthropic, respaldada por Google, y la empresa alemana de IA Aleph Alpha obtuvieron resultados significativamente peores, con 7 y 5 puntos, respectivamente. ChatGPT quedó en medio del pelotón con 25/48.

Las cuatro principales áreas de incumplimiento son los datos protegidos por derechos de autor, la energía, la mitigación de riesgos y la evaluación/pruebas.

Uno de los autores, Kevin Klyman, investigador del Center for Research on Foundation Models de Stanford, señaló que la mayoría de los desarrolladores no revelan sus estrategias de mitigación del riesgo, lo que podría ser un factor decisivo. Klyman afirmó: "Los proveedores no suelen revelar la eficacia de sus medidas de mitigación del riesgo, lo que significa que no podemos saber hasta qué punto son arriesgados algunos modelos de cimentación."

Además, hay grandes diferencias en los datos utilizados para entrenar los modelos. La UE exigirá a los desarrolladores de IA que sean más transparentes con sus fuentes de datos, algo que 4/10 de los desarrolladores no hacen. ChatGPT solo obtuvo 1 punto en ese aspecto.

Código abierto frente a modelos propietarios

El informe también descubrió una clara dicotomía en el cumplimiento dependiendo de si un modelo era de código abierto o propietario.

Los modelos de código abierto obtuvieron buenas puntuaciones en divulgación de recursos y requisitos de datos, pero sus riesgos están en gran medida sin documentar.

Los modelos patentados son todo lo contrario: están muy probados y documentados, con sólidas estrategias de mitigación de riesgos, pero no son transparentes en lo que respecta a los datos y las métricas relacionadas con la tecnología.

O, por decirlo de un modo más preciso, los desarrolladores de código abierto no tienen tantos secretos competitivos que proteger, pero sus productos son intrínsecamente más arriesgados, ya que casi cualquiera puede utilizarlos y modificarlos.

Por el contrario, es probable que los desarrolladores privados mantengan bajo llave algunos aspectos de sus modelos, pero pueden demostrar la seguridad y la mitigación de riesgos. Ni siquiera Microsoft, el principal inversor de OpenAI, está plenamente convencido de que los modelos de OpenAI sean seguros. entender cómo funcionan los modelos de OpenAI.

¿Qué recomienda el estudio?

Los autores del estudio reconocen que el desfase entre las expectativas de la UE y la realidad es alarmante y formulan varias recomendaciones a los responsables políticos y los creadores de modelos.

El estudio recomienda a los responsables políticos de la UE:

- Afinar y especificar los parámetros de la Ley de IA de la UE: Los investigadores argumentan que el lenguaje técnico y los parámetros de la Ley de IA son poco específicos.

- Promover la transparencia y la rendición de cuentas: Los investigadores sostienen que las normas más estrictas deberían estar ultra dirigidas a los desarrolladores más grandes y dominantes, lo que debería conducir a una aplicación más eficaz.

- Proporcionar recursos suficientes para hacer cumplir la ley: Para que la Ley de Inteligencia Artificial de la UE se aplique con eficacia, los organismos encargados de hacerla cumplir deben disponer de los recursos técnicos y el talento necesarios.

El estudio recomienda a los responsables políticos mundiales:

- Priorizar la transparencia: Los investigadores subrayan que la transparencia es fundamental y debe ser el objetivo principal de los esfuerzos políticos. Sostienen que las lecciones extraídas de la regulación de las redes sociales revelan las consecuencias perjudiciales de una transparencia deficiente, que no deberían repetirse en el contexto de la IA.

- Aclarar cuestiones de derechos de autor: Los límites de los derechos de autor sobre los datos de entrenamiento y los resultados de la IA son objeto de un acalorado debate. Dado el escaso cumplimiento observado en la divulgación de datos de entrenamiento protegidos por derechos de autor, los investigadores sostienen que las directrices legales deben especificar cómo interactúan los derechos de autor con los procedimientos de entrenamiento y los resultados de los modelos generativos. Esto incluye definir los términos en los que deben respetarse los derechos de autor o las licencias durante el entrenamiento y determinar cómo los contenidos generados por máquinas podrían infringir los derechos de autor.

El estudio recomienda a los creadores de modelos de fundación

- Esforzarse por mejorar continuamente: Los proveedores deben esforzarse constantemente por mejorar su cumplimiento. Los proveedores más grandes, como OpenAI, deberían predicar con el ejemplo y difundir recursos a los clientes intermedios que accedan a sus modelos a través de API.

- Defender las normas del sector: Los proveedores de modelos deben contribuir a establecer normas del sector, lo que puede conducir a un ecosistema de IA más transparente y responsable.

Aunque se pueden extraer algunos aspectos positivos de las normas de riesgo y supervisión establecidas por desarrolladores líderes como OpenAI, las deficiencias en ámbitos como los derechos de autor distan mucho de ser ideales.

En cuanto a la aplicación de la normativa a la IA como categoría global - que podría resultar muy difícil de hecho - ya que los modelos comercial y de código abierto son estructuralmente distintos y difíciles de agrupar.