A finales de mayo, el abogado neoyorquino Steven A. Schwartz utilizó ChatGPT para investigar casos legales en nombre de un cliente.

Schwartz y un colega del mismo bufete, Peter LoDuca, comparecieron ante el juez el jueves para explicar sus acciones.

En la vista, ambos abogados confesaron haber hecho referencia a casos judiciales falsos generados por ChatGPT.

Schwartz utilizó ChatGPT para localizar precedentes legales que apoyaran el caso de un cliente contra la aerolínea colombiana Avianca, a la que la AI devuelve varios casos falsos y uno real con detalles groseramente alterados.

Schwartz los citó en el escrito del demandante, pero cuando el juez de distrito estadounidense Kevin Castel lo recibió, se dio cuenta rápidamente de que el casos falsos y dijo: "Seis de los casos presentados parecen ser decisiones judiciales falsas con citas falsas y citas internas falsas".

"No comprendía que ChatGPT pudiera fabricar casos", confesó Schwartz a Castel, admitiendo que había estado "operando bajo la idea errónea... de que este sitio web obtenía estos casos de alguna fuente a la que yo no tenía acceso".

El juez Castel les enfrentó a un caso judicial inventado en particular que debería haber parecido falso a Schwartz. El caso se describió primero como un caso de homicidio culposo, pero más tarde se transformó en un caso sobre un hombre que perdió un vuelo y se vio obligado a pagar gastos adicionales.

En otras palabras, incluso para un profano, probablemente era evidente que este caso era falso, por lo que Schwartz probablemente no leyó bien la salida de la IA. "¿Podemos estar de acuerdo en que es un galimatías legal?" dijo Castel sobre el caso.

Schwartz se disculpó profusamente: "Me gustaría disculparme sinceramente", y dijo sentirse "avergonzado, humillado y extremadamente arrepentido".

LoDuca admitió que no revisó adecuadamente el material recopilado por Schwartz. Dijo: "Nunca caí en la cuenta de que se trataba de un caso falso" y que el resultado "me apena sobremanera".

En cuanto a si el dúo será castigado, el abogado Ronald Minkoff argumentó que las acciones de la pareja "fueron resultado de un descuido, no de mala fe" y, por lo tanto, no deberían ser penalizadas.

Minkoff argumentó: "El Sr. Schwartz, que apenas investiga a nivel federal, optó por utilizar esta nueva tecnología. Pensó que estaba tratando con un motor de búsqueda estándar".

El veredicto final sobre las sanciones está pendiente.

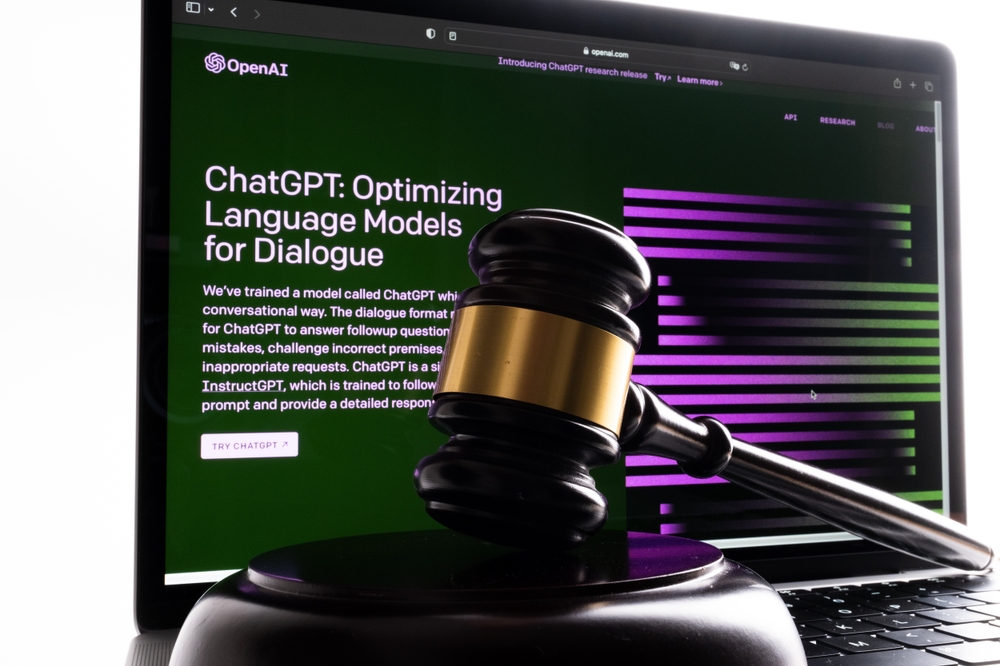

Las "alucinaciones" de la IA plantean problemas éticos y jurídicos

Una secuencia de casos legales está golpeando a OpenAIentre ellos tres casos de posible difamación que surgieron cuando los resultados de ChatGPT contenían información falsa y difamatoria.

El resultado aquí es diferente. Este es un ejemplo de mala conducta resultante de los consejos tomados de la salida de ChatGPT.

Daniel Shin, profesor adjunto y director adjunto de investigación en el Centro de Tecnología Jurídica y Judicial de la Facultad de Derecho William & Mary, dijo: "Este fue el primer caso documentado de posible mala conducta profesional de un abogado que utiliza IA generativa."

Era cuestión de tiempo que alguien cometiera este error. Schwartz fue el primero (que sepamos) en lo que ha resultado ser un precedente que probablemente no esperaba sentar.