El abogado neoyorquino Steven A. Schwartz utilizó ChatGPT para investigar varios "casos" que resultaron ser falsos.

El caso de Schwartz se refería a un hombre que demandó a la aerolínea colombiana Avianca. El demandante trabajó con un equipo jurídico, Levidow, Levidow & Oberman, que preparó un escrito jurídico haciendo referencia a casos jurídicos totalmente falsos.

Schwartz pidió a ChatGPT que le asegurara que los casos eran reales, pero sólo intentó cotejar uno de los casos en detalle, y ChatGPT le aseguró que podía encontrarse en las bases de datos Westlaw y LexisNexis. Sobre esa base, Schwartz asumió que los otros casos también eran reales.

Más tarde se reveló que sólo un caso era real, Zicherman contra Korean Air Lines Co., 516 U.S. 217 (1996)y ChatGPT se equivocó en la fecha y en otros detalles.

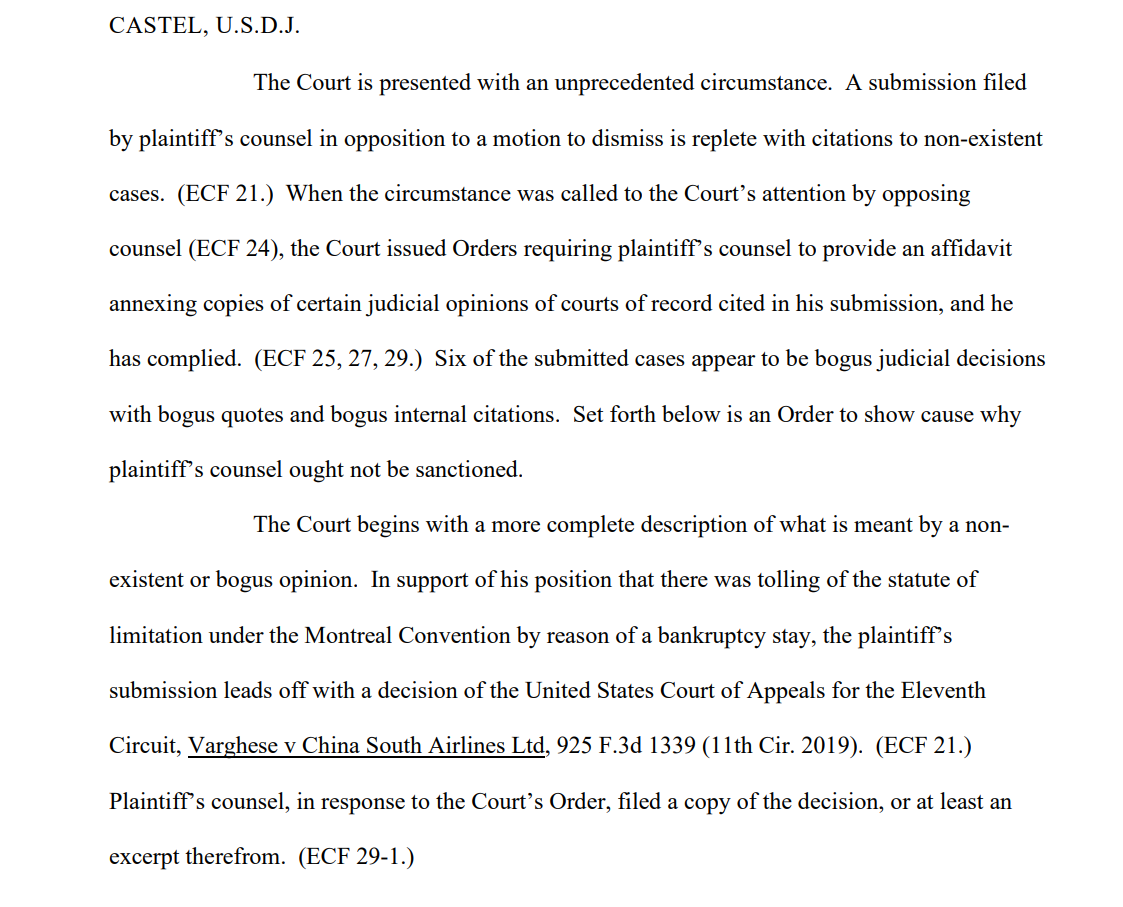

Después de que el equipo del demandante presentara el escrito, uno de los destinatarios, el juez de distrito estadounidense Kevin Castel, declaró: "Seis de los casos presentados parecen ser decisiones judiciales falsas con citas falsas y citas internas falsas."

Uno de los expedientes judiciales diceEl Tribunal se encuentra ante una circunstancia sin precedentes. Un escrito presentado por el abogado del demandante en oposición a una moción de desestimación está repleto de citas a casos inexistentes."

Schwartz, que tiene 30 años de experiencia como abogado, alegó que se trataba de un error inocente, diciendo al Tribunal que "lamenta enormemente" haber utilizado ChatGPT para investigar y que "desconocía que su contenido pudiera ser falso". También admitió haber utilizado ChatGPT en otros casos legales.

Schwartz, que actuaba en nombre de Peter LeDocu, colega del mismo bufete, deberá comparecer ante el Tribunal el 8 de junio para explicar por qué no debe sancionársele ni a él ni a su bufete.

Cuando ChatGPT comprueba ChatGPT

OpenAI tiene muy claro que ChatGPT es vulnerable a tergiversar la verdad, pero la IA puede parecer confiada cuando proporciona "ejemplos" contextualmente relevantes que no son factualmente correctos, lo que también se llama "alucinar".

Este es un problema también en el mundo académico, donde ChatGPT genera a menudo referencias falsas, llegando a veces a fabricar estudios y experimentos realistas que nunca sucedieron.

Numerosas universidades han emitido declaraciones en este sentido. Por ejemplo, La Universidad de Duke afirmaLo que quizás no sepas sobre ChatGPT es que tiene limitaciones significativas como asistente de investigación fiable. Una de esas limitaciones es que se sabe que fabrica o "alucina" (en términos de aprendizaje automático) citas."

Analizar las referencias en busca de incoherencias se ha convertido en una forma fiable de que los tutores descubran a los estudiantes que utilizan ChatGPT para escribir ensayos.

Eso es precisamente lo que le ocurrió a Schwartz: le pillaron. No fue el primero ni será el último. Parecía un auténtico ignorante, pero la ignorancia no constituye necesariamente una defensa ante un tribunal.

La generación de citas legales falsas es un ejemplo alarmante de la falibilidad de ChatGPT y sirve como potente recordatorio para comprobar, comprobar dos veces y comprobar tres veces los "hechos" promocionados por las IA generativas.