Em 1956, Philip K. Dick escreveu uma novela intitulada "The Minority Report" (O Relatório da Minoria), que imaginava um futuro em que os "precogs" podiam prever crimes antes de eles acontecerem na realidade.

Algumas décadas mais tarde, Tom Cruise trouxe esta visão sinistra para o grande ecrã, perseguindo potenciais criminosos com base nestas previsões.

Ambas as versões obrigaram-nos a refletir sobre as implicações éticas de sermos presos por algo que podemos vir a fazer no futuro.

Hoje em dia, à medida que os métodos de policiamento preditivo se infiltram na aplicação moderna da lei, devemos perguntar-nos: estaremos prestes a concretizar a narrativa presciente de Dick?

O que é o policiamento preditivo e como funciona?

O policiamento preditivo combina a aplicação da lei e a análise avançada, aproveitando a aprendizagem automática para antecipar actividades criminosas antes de estas se concretizarem.

A premissa é bastante simples no papel: se conseguirmos descodificar os padrões escondidos nos dados históricos sobre crimes, podemos criar algoritmos para prever ocorrências futuras.

O processo começa com a recolha de registos históricos de crimes, feeds de vigilância, conversas nas redes sociais e até nuances como as flutuações meteorológicas. Este vasto repositório de informações é depois introduzido em modelos sofisticados de aprendizagem automática concebidos para discernir padrões subjacentes.

Por exemplo, o modelo pode discernir que um bairro específico regista um pico de assaltos em noites chuvosas de fim de semana.

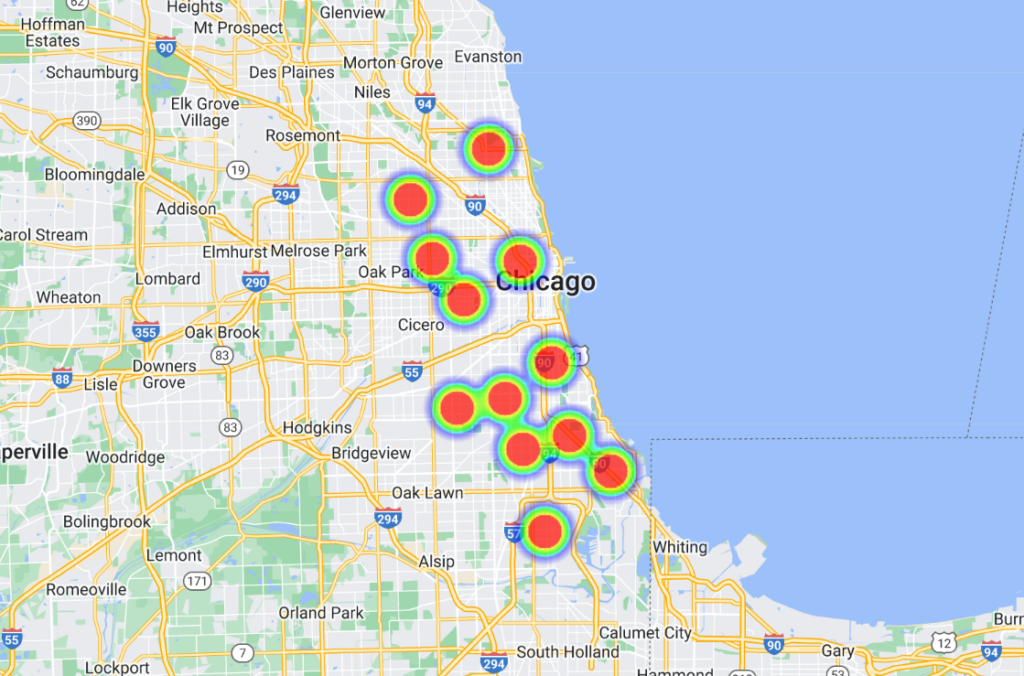

Quando estas correlações são descobertas, as plataformas de software avançadas transformam-nas em representações visuais, muitas vezes semelhantes a "mapas de calor" que destacam os prováveis pontos críticos de criminalidade. Isto, por sua vez, permite à polícia afetar os seus recursos de forma proactiva, optimizando as suas patrulhas e intervenções.

Alguns modelos foram mais longe, listando as pessoas por nome e morada, equipando os agentes com previsões altamente específicas e localizadas.

A história do policiamento preditivo

A tecnologia policial preditiva ainda é embrionária e, embora tenha havido alguns intervenientes influentes no sector, como a Palantir, o sector é pequeno.

Em junho de 2022, a Universidade de Chicago desenvolveu um modelo de IA capaz de prever a localização e a taxa de criminalidade na cidade com uma alegada precisão de 90%.

Com base em dados abertos sobre crimes de 2014 a 2016, a equipa dividiu Chicago em quadrados de cerca de 300 m (1000 pés). O modelo conseguiu prever, com uma semana de antecedência, o quadrado com maior probabilidade de ocorrência de um crime.

O estudo tinha intenções honestas, revelando preconceitos espaciais e socioeconómicos nos esforços da polícia e na atribuição de recursos. Descobriu que os bairros ricos recebiam mais recursos do que as áreas com rendimentos mais baixos.

Nas palavras do estudo, "aqui mostramos que, embora os modelos preditivos possam aumentar o poder do Estado através da vigilância criminal, também permitem a vigilância do Estado ao detetar preconceitos sistémicos na aplicação do crime".

Além disso, o modelo foi treinado com dados de sete outras cidades dos EUA, apresentando resultados semelhantes. Todos os conjuntos de dados e algoritmos foram disponibilizados no GitHub.

Chicago é um importante caso de estudo em matéria de policiamento baseado em dados e assistido por IA. Outro exemplo é o projeto da cidade mapa de calor dos crimes com armas de fogoque identifica os "pontos críticos" de criminalidade que podem ser integrados nos esforços de policiamento.

Um incidente notável em 2013 - nos primórdios do policiamento preditivo - Robert McDaniels envolvidoO autor do crime é um residente do distrito de Austin, em Chicago, que é responsável por 90% dos crimes com armas de fogo na cidade.

Apesar do seu registo não violento, a inclusão de McDaniel numa lista de criminosos potencialmente violentos fez com que se tornasse, por duas vezes, alvo de violência armada, pelo facto de a polícia ter aparecido à sua porta e o ter tornado um alvo.

Um inquérito efectuado por O Verge afirma que um jornalista do Chicago Tribune contactou McDaniel a propósito da "lista de calor" - um nome não oficial que a polícia atribuiu aos algoritmos que rotulam potenciais atiradores e alvos.

Ishanu Chattopadhyay, o investigador principal do estudo de Chicago de 2022 projeto de previsão da criminalidadeO diretor-geral da Comissão Europeia, P. P. , sublinhou que o seu modelo prevê locais e não indivíduos. "Não se trata de Minority Report", disse ele - mas o evento de McDaniels certamente traça alguns paralelos.

Respondendo a preocupações de parcialidade, Chattopadhyay referiu que omitiram intencionalmente as infracções menores de droga e de trânsito comunicadas pelos cidadãos, concentrando-se nos crimes violentos e contra a propriedade mais frequentemente comunicados.

No entanto, ss estudos mostram que os indivíduos de raça negra são mais frequentemente denunciados por crimes do que os seus homólogos de raça branca. Consequentemente, os bairros negros são injustamente rotulados de "alto risco".

Além disso, a intensificação do policiamento numa área significa mais crimes comunicados, criando um ciclo de feedback que distorce a perceção do crime.

Por outro lado, basear-se em dados do passado pode perpetuar estereótipos e ignorar o potencial de mudança e reabilitação.

Como é que o policiamento preditivo se tem saído?

O policiamento preditivo, sem surpresa, é altamente controverso, mas será que funciona ou cumpre o seu objetivo básico?

Uma investigação de outubro de 2023 por O Markup e a Wired revelaram falhas gritantes, juntando-se a um volume crescente de provas que evidenciam os perigos e as deficiências da transferência da tomada de decisões no domínio da aplicação da lei para as máquinas.

O programa em questão é Geolíticaum software de policiamento preditivo utilizado pela polícia de Plainfield, Nova Jérsia. É de salientar que o departamento de polícia de Plainfield foi o único dos 38 departamentos dispostos a partilhar dados com os meios de comunicação social.

Anteriormente conhecido como PredPolEm 2007, este software de aprendizagem automática foi adquirido por vários departamentos de polícia.

O Markup e a Wired analisaram 23 631 previsões da Geolitica de fevereiro a dezembro de 2018. Destas, menos de 100 previsões corresponderam a casos reais de crime, resultando numa taxa de sucesso de menos de meio por cento.

Estes modelos de previsão sempre foram controversos, levantando inúmeras questões éticas relativamente ao seu potencial para reforçar preconceitos discriminatórios e racistas prevalecentes na IA e na aplicação da lei.

Esta investigação recente sublinha os dilemas éticos e questiona a eficácia do software na previsão de crimes.

Embora o software tenha mostrado ligeiras variações na precisão da previsão entre os tipos de crime (por exemplo, previu corretamente 0,6% dos roubos ou agressões agravadas em comparação com 0,1% dos assaltos), a narrativa geral continua a ser de um desempenho muito fraco.

A resposta sincera do capitão da polícia de Plainfield, David Guarino, lança luz sobre a realidade no terreno. "Porque é que adquirimos a PredPol? Queríamos aumentar a nossa eficiência na redução do crime", comentou.

"Não tenho a certeza de que tenha conseguido isso. Raramente, ou nunca, o utilizámos". Também referiu que o departamento de polícia deixou de o utilizar.

O Capitão Guarino sugeriu que os fundos afectados à Geolitica - que correspondiam a uma taxa de subscrição anual de $20.500 e a um montante adicional de $15.500 para um segundo ano - poderiam ter sido investidos de forma mais eficaz em programas centrados na comunidade.

A Geolitica deverá encerrar as suas actividades até ao final do ano.

Provas que documentam o enviesamento no policiamento preditivo

A promessa de um policiamento preditivo continua a ser tentadora, sobretudo numa altura em que as forças policiais estão cada vez mais sobrecarregadas e a qualidade da tomada de decisões policiais humanas está a ser desacreditada.

As forças policiais dos EUA, do Reino Unido e de vários países europeus, incluindo a França, são objeto de escrutínio devido a preconceitos contra grupos minoritários.

Os membros da Câmara dos Lordes e da Câmara dos Comuns do Reino Unido estão a apelar a uma paragem temporária sobre a utilização da tecnologia de reconhecimento facial em direto pela polícia.

Este facto surgiu depois de o ministro da polícia, Chris Philip, ter discutido a possibilidade de conceder às forças policiais acesso a 45 milhões de imagens da base de dados de passaportes para reconhecimento facial pela polícia. Até à data, 65 deputados e 31 organizações de defesa dos direitos humanos e da igualdade racial opõem-se à utilização de tecnologias de reconhecimento facial na atividade policial.

O grupo de defesa Vigilância do Big Brother afirmou que 89% dos alertas de reconhecimento facial da polícia britânica falham no seu objetivo, com resultados desproporcionadamente piores para os grupos étnicos minoritários e as mulheres. Um ensaio de reconhecimento facial efectuado em 2018 pela Polícia Metropolitana de Londres teve um resultado desanimador de taxa de sucesso de apenas cerca de 2%.

Como Michael Birtwistle, do Instituto Ada Lovelace, descritoA exatidão e a base científica das tecnologias de reconhecimento facial são altamente contestadas e a sua legalidade é incerta".

Nos EUA, um projeto de colaboração que envolveu a Universidade de Columbia, o AI Now Institute e outros analisou recentemente os litígios em tribunal nos EUA envolvendo algoritmos.

O estudo concluiu que os sistemas de IA foram frequentemente implementados à pressa, sem supervisão adequada, principalmente para reduzir os custos. Infelizmente, estes sistemas resultaram muitas vezes em problemas constitucionais devido a preconceitos inerentes.

Pelo menos quatro homens negros foram erradamente detidos e/ou encarcerados devido a correspondências faciais incorrectas nos EUA, incluindo Parques de Nijeer, falsamente acusado de furto em loja e de infracções rodoviárias, apesar de estar a 30 milhas de distância dos alegados incidentes. Posteriormente, passou dez dias na prisão e teve de pagar milhares de euros em custas judiciais.

O os autores do estudo concluíramEstes sistemas de IA foram implementados sem formação, apoio ou supervisão significativos e sem quaisquer protecções específicas para os destinatários. Isto deveu-se, em parte, ao facto de terem sido adoptados para produzir poupanças de custos e normalização no âmbito de um modelo monolítico de aquisição de tecnologia, que raramente tem em conta as preocupações com a responsabilidade constitucional".

O policiamento preditivo pode incentivar a tomada de decisões não naturais

Mesmo quando o policiamento preditivo é exato, os humanos têm de agir de acordo com as previsões, e é aí que as coisas se complicam.

Quando um algoritmo diz à polícia que tem de estar num determinado local porque está a ser/é provável que seja cometido um crime, está longe de ser inviável pensar que isso distorce a tomada de decisões.

Há algumas teorias psicológicas básicas que seria sensato confrontar quando se considera o papel da IA no policiamento.

Em primeiro lugar, quando um algoritmo informa a polícia de uma provável cena de crime, pode potencialmente prepará-la para ver a situação através de uma lente de expetativa. Este facto pode ter contribuído para o incidente McDaniels - a polícia chegou ao local na expetativa de um incidente, o que desencadeou uma escalada de acontecimentos num ambiente volátil.

Isto está enraizado no viés de confirmação, sugerindo que, uma vez que temos uma informação, tendemos a procurar e a interpretar a informação subsequente de uma forma que se alinhe com essa crença inicial.

Quando um algoritmo diz a alguém que é provável que ocorra um crime, essa pessoa pode inconscientemente dar mais importância aos indícios que confirmam essa previsão e ignorar os que a contradizem.

Além disso, os algoritmos, especialmente os utilizados em funções oficiais, podem ser vistos como autoridade devido à sua natureza computacional, e os funcionários podem depositar neles uma confiança indevida.

E depois há o risco de desresponsabilização moral. Os agentes podem transferir a responsabilidade das suas acções para o algoritmo, pensando que foi o software que tomou a decisão e não eles - o que também é muito relevante no domínio da guerra.

Os debates neste domínio são paralelos aos que envolvem A utilização da IA no campo de batalhaque coloca alguns dilemas semelhantes.

A autoridade imposta pela IA pode resultar numa "lacuna de responsabilização" em que ninguém assume a responsabilidade pelos erros cometidos pela IA, tal como salientado por Kate Crawford e Jason Schultz num recente Artigo JSTOR.

Em suma, com base nos dados actuais, o policiamento preditivo perpetua frequentemente os preconceitos, em vez de os diminuir.

Quando as previsões se combinam com as decisões humanas, os impactos são potencialmente catastróficos.